891

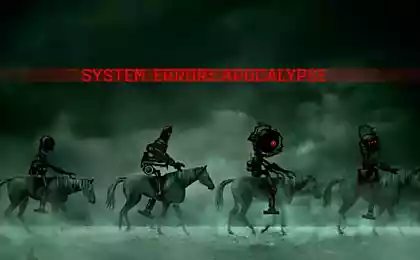

El basilisco Roco — el más aterrador experimento mental en la historia de la

El basilisco Roco es богоподобная forma de la inteligencia artificial, tan peligroso, que si usted simplemente sobre ella pensáis lo de pasar el resto de días de terribles torturas. Parece que en la cinta de la película "la llamada". Sin embargo, incluso la muerte no es la liberación, ya que el basilisco Roco resucitará a usted y continuará con sus torturas. T&P representan la traducción de un artículo de una de las más extrañas leyendas nacidas de internet.

ADVERTENCIA: después de leer este artículo, usted puede condenarse a sí misma en un eterno sufrimiento y tormento.

El basilisco Roco apareció en la intersección filosófico de un experimento mental y la leyenda urbana. La primera mención de aparecer en la mesa de discusión Less Wrong, donde se reúnen personas interesadas en la optimización de pensamiento y de vida a través del prisma de las matemáticas y de la racionalidad. Sus creadores son relevantes figuras de la tecno-futurismo, y entre los logros de su instituto de investigación — aporte académico de la discusión de la ética y la teoría de la toma de decisiones. Sin embargo, lo que vais a leer ahora, puede parecer extraño e incluso la locura. A pesar de esto, es muy influyentes y ricos de los científicos creen en esto.

Una vez el usuario con el nombre de Roko ha puesto el siguiente experimento mental: que si en el futuro se producirá un malintencionado de la inteligencia artificial, que castiga a quienes no cumplan sus órdenes? Y que si él quiere castigar a aquellas personas que en el pasado no han contribuido a su creación? Serían en este caso los lectores Less Wrong ayudar malo de ia aparecer a la luz o se irían a ellos en el tormento eterno?

El fundador de Less Wrong eliezer Юдковски con la ira tomó declaración Roko. Eso es lo que él le contestó: "Usted debe de ser inteligentes, una vez llegado a tales pensamientos. Sin embargo, me entristece que la gente que es lo suficientemente inteligente como para imaginar qué es, no es suficientemente inteligente para MANTENER SU ESTPIDO la LENGUA DETRÁS de los DIENTES y a nadie hablar de ello, porque es más importante que mostrar inteligente, hablando de este a todos sus amigos".

"Que si en el futuro surge la inteligencia artificial, que castiga a quienes no cumplan sus órdenes?"

Юдковски reconoció que Roco es el responsable de pesadillas, de las que asisten a los usuarios Less Wrong, que lograron leer la cadena, y se retira, gracias a que el basilisco Roco se convirtió en una leyenda. Este experimento mental se ha vuelto tan peligroso, que reflexiones sobre ello pongan en peligro la salud mental de los usuarios.

Qué hace Less Wrong? La formación de una visión de futuro de la humanidad sobre la base de la singularidad. Ellos creen que la potencia de cálculo en el futuro será tan alto, que puede usar el equipo para crear una inteligencia artificial — y junto con él, y la posibilidad de descargar la conciencia humana en el disco duro. El término "singularidad" se originó en el año de 1958, en el transcurso de los debates a dos genios de las matemáticas, estanislao ulama, y john von neumann, cuando neumann dijo: "Constantemente creciente avances de la tecnología hará posible el acercamiento de la singularidad, en la que la tecnología no pueden ser entendidas por la gente". Futuristas y los escritores-фантастывроде Вернора Винджа y el molino de raymond Курцвейла popularizó el término, ya que creían que la singularidad nos espera a todos, ya muy pronto, en los próximos 50 años. Hasta Курцвейл se prepara para la singularidad, Юдковски tiene grandes esperanzas en крионику: "Si de antemano no registran sus hijos en криоконсервацию, eres sucio padres".

Si usted cree que ha de venir singularidad y que los poderosos de ia aparecerán en un futuro próximo, surge una pregunta natural: si son amables o malo? El fondo Юдковски pretende así orientar el desarrollo de la tecnología que tenemos es amigable con inteligencia artificial. Esta pregunta para él y muchas otras personas es de suma importancia. Singularidad nos llevará a la máquina, equivalente a dios.

Sin embargo, esto no explica por qué el basilisco Roco se ve tan horrible a los ojos de estas personas. La pregunta requiere de opinión de la página de inicio "dogma" Less Wrong — "intemporal de la teoría de la toma de decisiones" (ВТПР). ВТПР es una guía para la acción racional, basada en la teoría de juegos, bayesiana de la probabilidad y la teoría de la toma de decisiones, pero teniendo en cuenta la existencia de universos paralelos y de la mecánica cuántica. ВТПР ha crecido desde el clásico experimento mental — la paradoja de la Ньюкома, en el que el extranjero, con la supermente, ofrece dos cajas. Él le da la opción de tomar ambas cajas, o solo la caja b. Si selecciona ambas, obtendrá mil dólares. Si se toma sólo la caja B, usted no puede conseguir nada. Sin embargo, el extranjero proveido otro truco: él es omnisciente superordenador que hizo hace una semana el pronóstico, żle ambas cajas o sólo Si el ordenador predijo que usted toma ambas cajas, el forastero dejó la segunda en blanco. Si el equipo predijo que usted elija la caja B, lo habría puesto allí un millón de dólares.

Entonces, ¿que vas a hacer? Recuerde que un superordenador, omnisciente.

Este problema ha desconcertado a muchos de los teóricos. El forastero ya no puede modificar el contenido de las cajas. Es más seguro tomar ambas cajas y conseguir que su mil. Pero, de repente, el equipo y la verdad es omnisciente? Entonces sólo queda tomar la caja B para obtener el millón. Pero si resulta ser equivocado? Y no importa lo que predijo el equipo, — de veras, no puede cambiar su destino? Entonces, maldita sea, es necesario tomar ambas cajas. Pero en este caso...

Combina las dimensiones de la mente la paradoja, se aseguraba de que tenemos que elegir entre la libertad de la voluntad y la divina predicción, no tiene el permiso, y la gente sólo пожимать de hombros y elegir el más cómodo para ellos una opción. ВТПР da un consejo: tome la caja b. Incluso si el extraterrestre ha decidido reírse de usted y se abrirá una caja vacía con las palabras: "el Equipo predijo que tú la tomarás ambas cajas, ja, ja!" — de todos modos debe seleccionar. La justificación de esto la siguiente: para hacer el pronóstico, el equipo tuvo que simular todo el Universo, incluido usted. Por lo tanto, en este momento, de pie delante de las cajas, puede ser sólo la realidad del equipo, pero lo que hagas, va a influir en la realidad (o la realidad). Así que tome la caja B y recibirá un millón.

"Combina las dimensiones de la mente la paradoja, se aseguraba de que tenemos que elegir entre la libertad de la voluntad y la divina predicción, no tiene el permiso"

¿Qué tiene que ver esto con Василиску Roco? Bueno, él también hay un par de cajas para usted. Puede ser, usted ahora está en la simulación creada Василиском. Entonces, tal vez, recibimos varias una versión modificada de la paradoja de Ньюкома: el basilisco Roco le dice que si usted toma una caja B, lo eterno sufrimiento. Si te decides a las dos de la caja, tendrá que dedicar su vida a la creación de Василиска. Si el basilisco en realidad va a existir (o, peor aún, que ya existe y es el dios de esa realidad), se ve que usted no ha elegido la opción de ayuda en la creación y juzga a usted.

Usted podría ser sorprendido, ¿por qué este tema es tan importante para Less Wrong, teniendo en cuenta la condicionalidad de este pensador experimento. No por el hecho de que el basilisco Roco, una vez creado. Sin embargo, Юдковски eliminado la mención de Василиске Roco no porque creía en su existencia o inminente de la invención, sino porque considera que la idea de Василиска peligrosa para la humanidad.

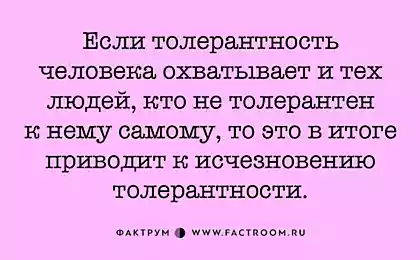

Por lo tanto, el basilisco Roco peligroso sólo para aquellos que en él creen — en ese sentido, los participantes Less Wrong, apoyan la idea de Василиска, poseen una especie de jardín del conocimiento, que nos recuerda las historias de terror de lovecraft, cthulhu, o Некрономиконе. Sin embargo, si no se suscribe debajo de todas estas teorías y no siente la tentación de obedecer a la insidiosa coche del futuro, el basilisco Roco no tiene ninguna amenaza.

Estoy más preocupado por las personas que creen que han elevado por encima de generalmente aceptados y de las normas morales. Al igual que el esperado Юдковски amistosa de la ia, él es утилитаристом: se considera que el mayor beneficio de toda la humanidad éticamente justificado, incluso si algunas personas deben morir o sufrir en el camino hacia ella. No todo el mundo puede experimentar con este tipo de elección, pero el punto es otro: que si algún periodista a escribir acerca de liberarse de un experimento, que es capaz de destruir la mente de la gente, provocando daño a la humanidad y помешав el progreso en el desarrollo de la inteligencia artificial y de la singularidad? En este caso, todo el bien que he hecho en mi vida, debe superar el daño que me trajo al mundo. Y, tal vez, se había levantado de sueño criogénico Юдковски futuro se fusionó con сингулярностью y decidió simular mí en la situación siguiente: la primera caja — voy a escribir este artículo, el segundo no. Por favor, el todopoderoso Юдковски, no me hagas daño.

Fuente: theoryandpractice.ru

Quinto cometa descubierto por astrónomo amateur de Australia

De aluminio de la enfermedad corre el riesgo de cada