213

¿Un dron o cuándo vamos a dar moralidad a los robots?

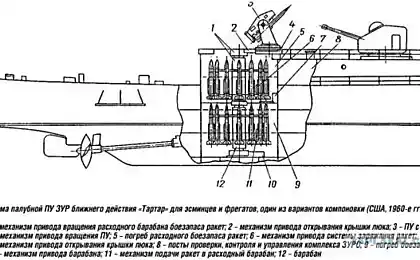

2015 es el año de la X-47B. Un nuevo avión no tripulado desarrollado por Northrop Grumman será probado en un buque de guerra estadounidense. Debe ser probado para ver si puede hacer todo lo que los aviones existentes pueden: despegar y aterrizar con seguridad, mantener la reserva y limpiar la cubierta para el próximo avión en tan solo 90 segundos. No es sorprendente que el desarrollo de un dron militar haya despertado tanta atención, porque la aviación de combate del mundo se está desarrollando activamente en los últimos años.

Entre los vehículos autónomos existentes, esta super-drona es probablemente la máquina más avanzada, nublando tal vez el auto conducción de Google. Ambos ejemplos de inteligencia artificial fueron el impulso de un equipo de científicos influyentes para firmar una carta abierta sobre inteligencia artificial (AI).

Firmado por científicos como el profesor Stephen Hawking, así como empresarios como Elon Musk, advierte que AI se está moviendo tan rápido hacia la inteligencia humana que no entendemos completamente su potencial. Los sistemas de inteligencia artificial necesitan hacer lo que queremos que hagan. Pero ¿cómo puede prosperar la gente cuando muchos empleos son automatizados, incluso en la banca y las finanzas? El futuro promete descanso ininterrumpido – o simplemente desempleo?

También hay muchas preguntas que necesitan ser respondidas hoy. Por ejemplo, ¿quién debe ser responsable si un auto conductor causa un accidente? La claridad en el campo legal es esencial para la confianza del consumidor, de la que depende el futuro de la industria.

Si vamos a dar la moral de los robots, ¿qué clase de moralidad debe ser establecida? ¿Qué hay de sabotaje? La idea de una máquina moral es fascinante, porque en una época en la que las máquinas ya están haciendo muchas de las cosas que los humanos pueden hacer: conducir un coche, volar un avión, correr, reconocer una imagen, hablar e incluso traducir, todavía hay competencias, como consideraciones morales, que los superan.

De hecho, con niveles crecientes de automatización, esta omisión podría volverse inmoral en sí misma. Por ejemplo, si los drones se convierten en nuestros emisarios en el campo de batalla, pueden tener que tomar decisiones que los humanos no pueden prever o codificar en el programa. Y estas decisiones pueden ser decisiones "morales", como salvar dos vidas.

P.S. Y recuerden, simplemente cambiando su conciencia – juntos cambiamos el mundo!

Fuente: mirnt.ru/aviation/bespilotnyy-samolet