Si el robot de matar a la persona que es culpable?

Si usted está buscando señales de la venida del Apocalipsis, que culpar robots , tenga en cuenta la zona desmilitarizada entre el Norte y Corea del Sur. Aquí, a lo largo de la frontera más fortificada del mundo, son algo más que ver a los soldados.

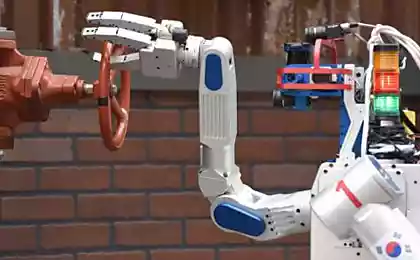

Conoce a la SGR-A1, horas-robot, desarrollado por Samsung en Corea del Sur. Dispositivo de 1,2 metros se ve un poco más de un par de cajas de zapatos de metal negro, pero sus ojos sin alma equipado con puertos de infrarrojos, puede detectar al enemigo a una distancia de cuatro kilómetros. Su ametralladora en ristre.

Actualmente, el robot informa a sus creadores de presunto atacante sentado en la sala de control. Y con el fin de que él abrió fuego, necesitará la aprobación de la persona. Pero este robot también está trabajando en el modo automático y puede disparar primero a su discreción. Resistencia, mis semejantes, es inútil.

El Pentágono y los militares de todo el mundo están desarrollando armas cada vez más autónomas, que va mucho más allá de los aviones no tripulados a control remoto, que Washington ha utilizado en Pakistán, Afganistán y otros países. Los avances tecnológicos permiten que estos nuevos tipos de armas para elegir un objetivo y disparar que en su elección sin la aprobación de la persona. Algunos predicen que estos robots serán un día luchando codo a codo con los soldados, hombres.

No es sorprendente que las noticias de los robots que matan, hace que algunas personas nervioso. En abril de este año, una coalición internacional de diseñadores, investigadores y activistas de derechos humanos convocó a una campaña en contra de la creación de robots asesinos y pidió a los diplomáticos a las Naciones Unidas en Ginebra. Los activistas quieren prohibir el desarrollo y el uso de "armas letales autónomas", al tiempo que reconoce que este tipo de armas, aunque tecnológicamente posible, nunca se ha aplicado.

"Tiene sentido preguntarse si la disminución del valor de la vida humana que permitirá a los robots para matar a la gente?" - Dice Pedro Asaro, profesor titular de la Escuela de Investigación de Medios de Comunicación en Nueva York, y un representante de la campaña contra los robots asesinos

.

Esta es sólo una cuestión de que filósofos, juristas y científicos luchan desde tiempos inmemoriales, mientras que el mundo se está preparando para la arremetida de nuevos robots, los cuales, se nos dice, se cortar el césped, el cuidado de los ancianos, para enseñar a niños con autismo e incluso conducir nuestros coches. Estos robots no pueden matar, pero los representantes de la carretera querer obligar al gobierno y los tribunales a considerar una serie de aspectos legales y éticos. ¿A quién debo demandar si me atropella un coche sin conductor? ¿Y si el robot a la médico-paciente da el medicamento equivocado? ¿Qué pasa si el robot limpiador aspirado accidentalmente mi pelo mientras yo dormitaba en el suelo (como de hecho sucedió a una mujer en Corea del Sur no hace mucho tiempo)? ¿Puede un robot cometer un crimen de guerra?

Es esta última pregunta es la más preocupada por el profesor Asaro. Él y otros miembros de la coalición, que incluye a Human Rights Watch afirmó que si un sistema informático autónomo está programado para garantizar que los soldados enemigos que distinguen de la población civil, en realidad aprieta el gatillo y sin "la aprobación humana," va a ser muy difícil mantener la situación bajo control si algo sale mal.

Si el robot se cae y mata a todo el pueblo, usted no será capaz de poner un objeto inanimado en frente de la Corte Penal Internacional, o dar consejo de guerra por el tribunal de él. Algunos expertos dicen que no se puede culpar a la ley, incluso los desarrolladores del robot, si ellos no anticiparon que el robot puede volver loco.

En el derecho penal, los tribunales deben encontrar lo que se conoce como mens rea o mens rea (América). Pero es poco probable que encontrar información sobre lo que el robot - desde el nivel actual de desarrollo de la inteligencia artificial - tiene la voluntad en absoluto. Diseñadores robots pueden incurrir en responsabilidad civil, si se comprueba que el robot se salió de control debido a un fallo en el programa. Sin embargo, no pueden ser consideradas responsables de las acciones de los robots asesinos.

Estos robots asesinos pueden parecerse a cualquier cosa - de los drones robóticos autónomos a los móviles con armas de fuego. La Directiva de 2012 el Ministerio de Defensa decidió que los sistemas autónomos "deben diseñarse de modo que los comandantes y los operadores para implementar los niveles adecuados de control humano sobre el uso de la fuerza." En una respuesta por correo electrónico a una pregunta de El Departamento de Defensa Nacional Globe and Mail de Canadá, dijo que "ahora no se desarrolla un armas letales autónomas", pero su agencia de investigación participa activamente en "programa de investigación en el campo de los sistemas no tripulados».

Al menos una empresa dedicada a la robótica, con sede en Waterloo Ont, RTN Robotics Inc., habló en contra de robots asesinos, a pesar del hecho de que los robots creados por militares canadienses y de Estados Unidos. Gariepi Ryan, co-fundador de ClearPath y su director de tecnología, dijo que una buena aplicación para los robots militares autónomos tienen la tarea de remoción de minas o un control, pero no de asesinato, especialmente si esos coches de un lado de la batalla: "¿Cómo pueden los robots decidir quién perdurar pena de muerte? ¿El derecho a privar a una persona de la vida para los soldados enemigos? »

Inevitablemente los robots asesinos de discusión gira en torno a los "Tres Leyes de la Robótica" del escritor historias de ciencia ficción Isaac Asimov. La primera ley prohíbe los robots de dañar a las personas; el segundo le dice a la gente a obedecer sólo si no entre en conflicto con la primera ley; el tercero dice robots para proteger su propia vida - siempre y cuando no viole las dos primeras leyes. Pero la mayoría de los expertos dicen que las leyes harán poco bien en el mundo real: sus defectos incluso Asimov muestra en sus cuentos.

Sin embargo, el profesor Ronald Arkin del Instituto de Tecnología de Georgia, el famoso diseñador americano de robots, que trabaja en proyectos del Pentágono argumenta que los robots asesinos u otros sistemas de armas automáticas pueden ser programados para seguir las leyes de la guerra - y seguirlas mejor que las personas . El robot, dice, nunca va a disparar, defender sus vidas, o por miedo. Él tendrá acceso a la información y datos que ningún soldado-hombre no podía manejar tan rápido que hace que sea menos probable que un error en el "fragor de la batalla". Nunca mataría intencionalmente a civiles en represalia por la muerte de un camarada. Y lo que realmente puede seguir a los soldados, por lo que no cometieron el delito.

Profesor Arkin también argumenta que la tecnología autónoma es, de hecho, ya están en el campo de batalla. Según él, las baterías de misiles Patriot de EE.UU. elegirán de forma automática los objetivos y dar a una persona hasta nueve segundos para cancelar la meta y detener el misil. Un sistema de Falange de la Marina estadounidense a proteger barcos, golpeando automáticamente misiles.

Pero incluso ellos exigen una moratoria en el desarrollo de armas más autónomos, siempre y cuando se puede demostrar que pueden reducir las bajas civiles. "Nadie quiere la aparición de la tecnología Terminator. ¿Quién querría tener un sistema que puede ser enviado en una misión, y será para decidir quién debe ser asesinado? - Dice el profesor Arkin. - Los sistemas deben diseñarse con mucho cuidado y cautela, y creo que hay maneras de hacerlo »

.

En los últimos años, las grandes empresas de tecnología están cada vez más preocupados acerca de la inteligencia artificial. El físico Stephen Hawking ha advertido de que la aparición de la gripe aviar "podría significar el fin de la raza humana." Elon Musk, fundador de Tesla Motors, AI llamados "amenaza existencial" - no es menos peligrosa que las armas nucleares. Bill Gates, fundador de Microsoft, también se refiere.

Las personas que realmente trabajan en la creación de la inteligencia artificial, diciendo que no hay nada de qué preocuparse. Yoshua Bengio, un destacado investigador de la Universidad de Montreal, AI señala que la ficción Star Wars y Star Trek sobrestima en gran medida la capacidad de los robots y la inteligencia artificial. Una vez, dice, podríamos construir un coche que podría competir con el cerebro humano. Pero ahora, la IA no está tan desarrollado.

Todavía hay mucho que hacer antes de los robots se vuelven como lo que se ve en las películas - dice el profesor Benji. - Todavía estamos muy lejos de poder obtener el nivel de comprensión del mundo que esperamos de, digamos, cinco años de un niño o incluso un adulto. Y para lograr este objetivo puede requerir una década o más. Ni siquiera podemos repetir el nivel de inteligencia del ratón.

Blockquote>

Sin duda, el desarrollo de hardware y software para robots siempre hacia delante.

Los robots desarrollados por Boston Dynamics, que recientemente compró Google, se pueden usar en terrenos difíciles, como los perros, y se arrastran como ratas en la zona del desastre.

Perro robot llamado punto puede mantenerse en pie después de su ritmo, sus patas de metal mirada inquietantemente realista.

Pero si temes que los robots asesinos revolución es inevitable, Atlas, de seis pies robot humanoide con un peso de 330 libras, le ayudará a calmarse. También creado por Boston Dynamics, puede subir por las escaleras y sobre las rocas. Parece un Cyberman de la serie "Doctor Who", desarrollado por Apple. Sin embargo, la carga de su batería dura sólo 1 hora.

Parece, dice Ian Kerr, Jefe del Departamento de Ética, Derecho y Tecnología de la Universidad de Ottawa, la gente da gradualmente el control de máquinas con inteligencia artificial - computadoras que eventualmente hacer ciertas cosas mejor que nosotros. A pesar de que pasará algún tiempo antes de ver el coche, que no necesita un conductor, incluso ahora hay coches que se pueden aparcar a sí mismos. Robot IBM Watson de la empresa International Business Machines Corp., que ganó un concurso Jeopardy! en 2011, se utiliza actualmente para analizar millones de páginas de la investigación médica para recomendar tratamientos para pacientes con cáncer.

El hombre - esto es sólo un punto ... En algo como esto, a veces pienso, y en este momento estoy como Abraham en el monte cuando se oye la voz de Dios, pero todavía tiene que decidir por sí mismo qué hacer, dice Prof ESSOR Kerr. - Es natural que el hospital va a querer médicos dependido de máquinas porque las máquinas tienen un mayor potencial ... Y entonces llegamos al punto en que la humanidad será relevado de algunos de los tipos de decisiones, tales como conducir o guerra

. Blockquote>

Fuente: geektimes.ru/company/robohunter/blog/253026/