711

0.2

2015-10-28

Как должен вести себя беспилотный автомобиль в случае, если избежать жертв в результате аварии невозможно?

Французские учёные из Тулузской школы экономики во главе с Жаном-Франсуа Боннфоном (Jean-Francois Bonnefon) опубликовали научную работу «Робомобилям нужна экспериментальная этика: готовы ли мы выпускать машины на дороги?» (Autonomous Vehicles Need Experimental Ethics: Are We Ready for Utilitarian Cars?), в которой попытались ответить на сложный этический вопрос: каким должно быть поведение беспилотного автомобиля в случае, если избежать аварии невозможно и жертвы неизбежны? Авторы опросили несколько сотен участников краудсорсингового сайта Amazon Mechanical Turk, который объединяет людей, готовых выполнять какую-либо проблемную работу, на которую компьютеры пока что не способны по различным причинам. На статью обратил внимание ресурс MIT Technology Review.

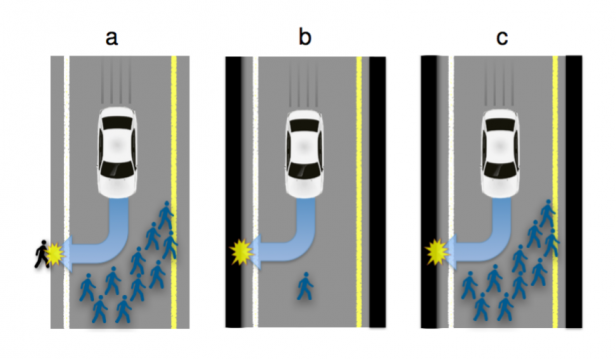

Авторы подошли к исследованию достаточно осторожно, не требуя от людей однозначных ответов: да или нет. При этом под робомобилем подразумевались действительно автономные автомобили, которые полностью управляются компьютером, без возможности повлиять на ситуацию живым человеком. Было сформулировано несколько вопросов, иллюстрирующих ряд ситуаций, при которых поведение компьютерного алгоритма, управляющего робомобилем, становится этической проблемой. К примеру, если дорожные обстоятельства складываются таким образом, что есть только два варианта развития событий: избежать столкновения с группой из 10 пешеходов означает самому въехать в отбойник или заехать в толпу людей, когда число жертв становится по-настоящему непредсказуемым. Как в таком случае должен поступить компьютерный алгоритм? Ещё более сложная ситуация: если на дороге только один пешеход и один робомобиль? Что этически более приемлемо — убить пешехода или убить владельца машины?

По результатам исследования выяснилось, что люди считают «относительно приемлемым», если робомобиль будет запрограммирован на минимизацию человеческих жертв в случае дорожного проишествия. Другими словами, в случае возможной аварии с участием 10 пешеходов, компьютерный алгоритм должен фактически пожертвовать своим владельцем. Правда, более менее однозначный ответ исследователи получали ровно до того момента, пока участники исследования не оказывались за рулем робомобиля — ставить себя на место его водителя они отказались. Это приводит к другой противоречивой проблеме. Чем меньше людей будут покупать робомобили, которые действительно намного меньше, чем живые водители попадают в опасные ситуации, тем больше людей будет гибнуть в авариях на обычных автомобилях. Другими словами, вряд ли покупателю будущего гугломобиля понравится один из пунктов в лицензионном соглашении, который будет гласить, что в случае неизбежной жертвы в результате аварии, программное обеспечение фактически выберет убить своего владельца.

Источник: geektimes.ru/post/264794/

Портал БАШНЯ. Копирование, Перепечатка возможна при указании активной ссылки на данную страницу.