1700

час польоту

Ви знаєте, я іноді дивився дивною структурою громадської думки. За допомогою технології візуалізації 3D для прикладу. Величезна громадська справа викликається останнім часом технологією віртуальних окулярів реальності: Oculus Rift, Google Glass. Але тут немає нічого нового, перші шоломи віртуальної реальності з'явилися в кінці 90-х років. Так, вони були ускладненими, вони випереджали свій час, але чому не мали такого ефекту WOW? Або 3D принтери. Статті про те, як вони круті, або як швидко, вони збираються по всьому світу, поповнюючи двічі на тиждень протягом останніх трьох років. Я не задуха, це круто, і вони збираються по всьому світу. Але ця технологія була створена в 80-х роках і була повільно прогресуюча. 3D телевізор? 1915 р.

Технологія - це все хороше і цікаве, але чому є так багато гіп про кожен хиз?

Що, якщо я сказав, що в останні 10 років технологія 3D-фотозйомки була винайдена, розвинена і масово-продукована, дуже відрізняється від інших технологій? Технологія вже широко використовується. Доступні і доступні для звичайних людей в магазинах. Ви чули про це? (докладно лише фахівці з робототехніки та суміжних полів вже здогадали, що я розмовляю про фотокамери ToF).

Що таке камера ToF? У Російській Вікіпедії ви не знайдете навіть коротку згадку про те, що це таке. "Час льотної камери" перекладається як "Час льотної камери". Камера визначає діапазон через швидкість світла, вимірюючи час польоту світлового сигналу, що випускається камерою і відображає кожну точку отриманого зображення. Поточний стандарт - це 320 * 240піксельна матриця (попереднє покоління становитиме 640 * 480). Камера забезпечує точність вимірювання глибини близько 1 сантиметра. Я, ї. Матриця датчиків 76,800 забезпечують точність вимірювання часу замовлення 1/10,000,000,000 (10^-10) секунд. На продажу. Для 150 греків. Або можливо, ви навіть використовуєте його.

Тепер трохи більше про фізику, як це працює, і де ви знаходитеся з цією красою.

В наявності три основні типи камер ToF. Для кожного з типів використовується власна технологія вимірювання діапазону положення точки. Найпростіший і найбільш зрозумілий - "Пультова модуляція", ака "Пряме часові зображення" Відводиться імпульс і в кожній точці матриці точний час його повернення:

578163

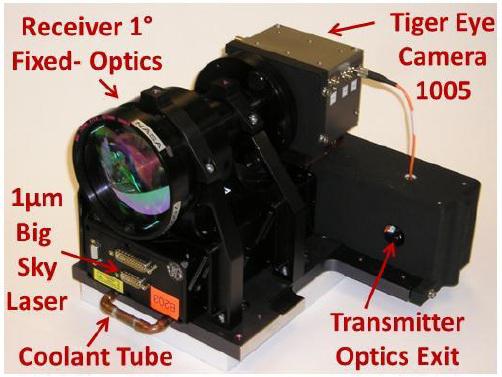

Насправді, матриця складається з тригерів, які запускаються вздовж хвилі фронту. Те ж саме метод використовується в оптичних синхронах для спалахів. Прийміть його замовлення більш точно. Це головна труднощі даного методу. Дуже точне виявлення часу відгуку, що вимагає специфічних технічних рішень (що я не можу знайти). Зараз такі датчики проходять випробування НАСА для землеробів своїх суден.

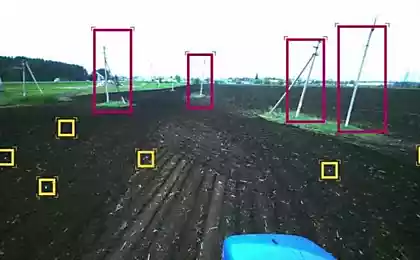

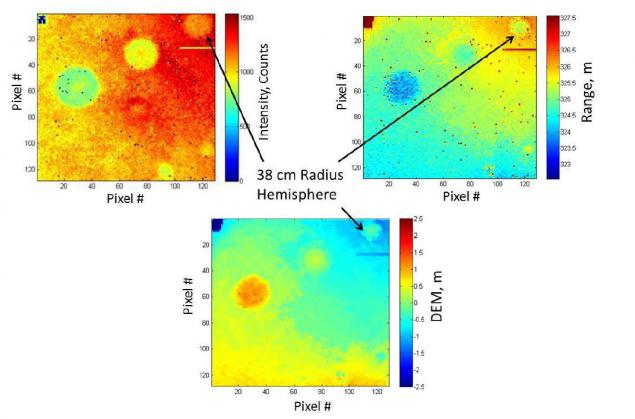

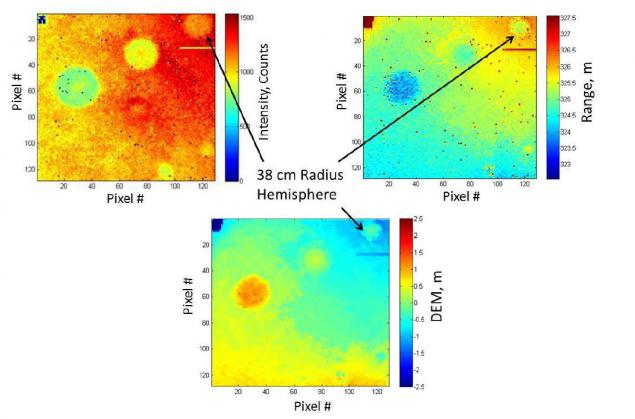

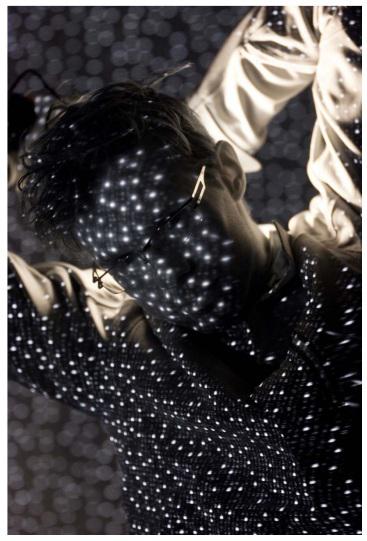

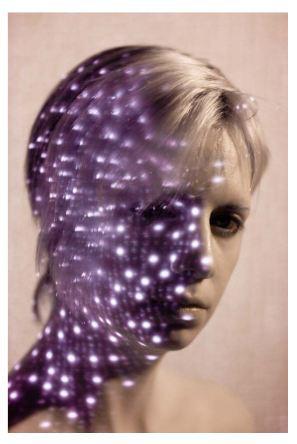

Ось фотографії вона дає:

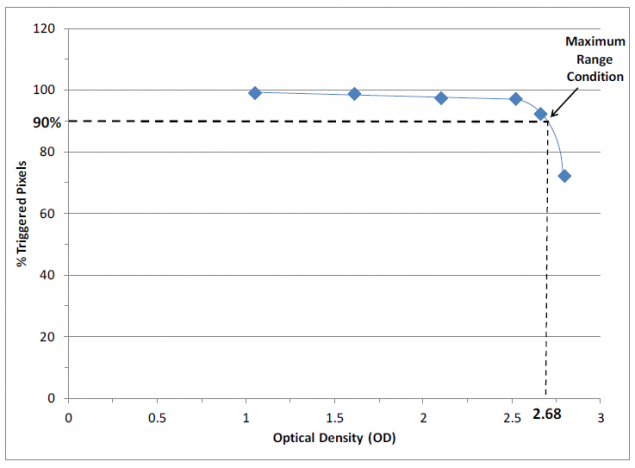

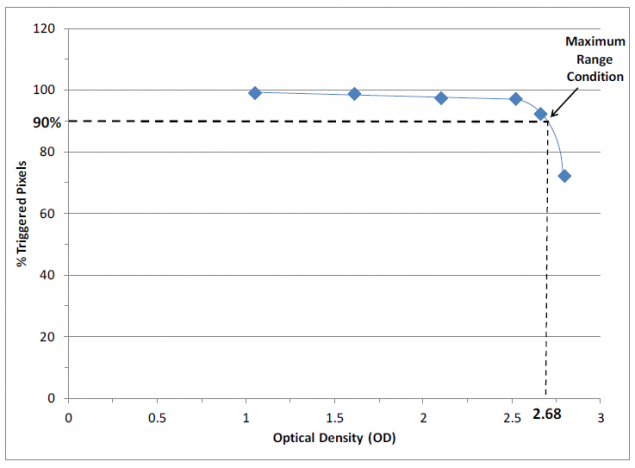

Підсвітка на них достатньо для запуску оптичного потоку від відстані близько 1 кілометра. На графіку показано кількість запущених пікселів в матриці в залежності від відстані 90% роботи на відстані 1 км:

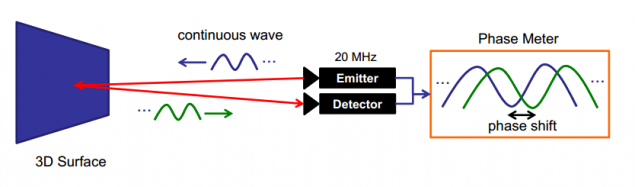

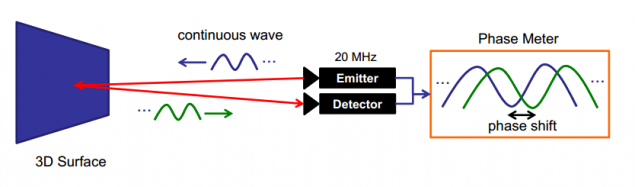

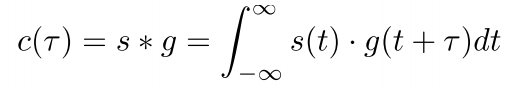

Другий метод є постійним модуляція сигналу. Випромінювач відправляє певну модульну хвилю. Ресивер знаходить максимальну кореляцію того, що він бачить з цією хвилею. Це визначає час, який бере сигнал, щоб відмовлятися і прибути на ресивер.

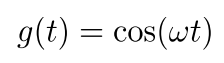

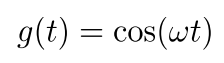

Дозволяти сигнал:

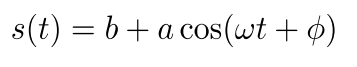

де w є модулююча частота. Тоді отриманий сигнал буде виглядати:

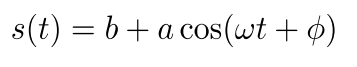

де b- some зсув, амплітуда. Поєднання вхідних і вихідних сигналів:

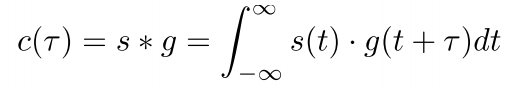

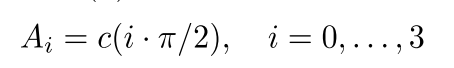

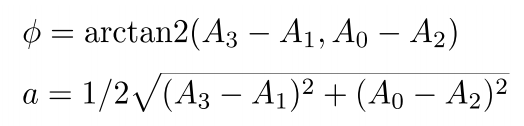

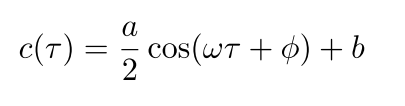

Але повна кореляція з усіма можливими зсувами в часі досить важко виробляти в режимі реального часу в кожному піксельі. Тому використовується хитрий прийом з вушками. Одержаний сигнал отримується в 4 сусідніх пікселів з фазовим зсувом 900 і гофрує з собою:

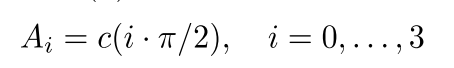

Потім фазовий зсув визначається як:

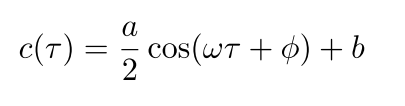

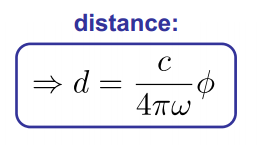

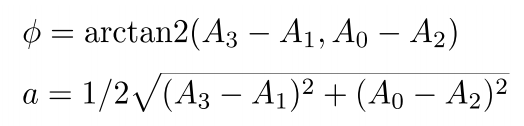

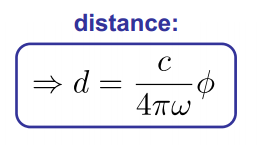

Знаючи отриманий фазовий зсув і швидкість світла, ми отримуємо діапазон до об'єкта:

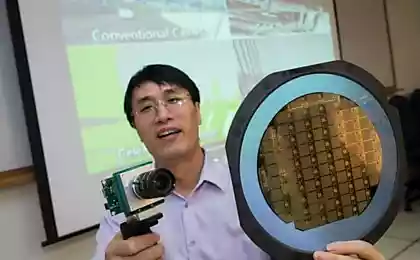

Ці фотокамери трохи простіші, ніж ті, побудовані з першою технологією, але вони ще складні і дорогі. Ця компанія робить їх. І вони вартість близько 4 фунтів. Але милий і футуристичний:

Третя технологія - Range Gated Imagers. В основному камера затвору. Ідея тут не дуже проста і не вимагає високоточних ресиверів, а не складних кореляцій. Перед матрицею. Припустимо, що це ідеальний і працює миттєво. На час 0, освітлення сцени перетворюється. Застібка закривається в час т. Потім об'єкти далеко від т/(2∙c), де c - швидкість світла не буде видно. Світло не встигне дістатися до них і повернутися назад. Точка, розташована поруч з камерою, підсвічується в усі часи впливу т і має яскравість І. Так, будь-яка точка впливу матиме яскравість 0 до I, а яскравість буде представлення відстані до точки. Чим яскравіше, тим ближче.

Залишилося робити лише пара тріфл: ввести в модель час закривання штепсельної матриці і поведінку матриці в цьому заході, імперфікацію джерела освітлення (для точкового джерела світла, залежність діапазону і яскравості не буде лінійним), різне відображення матеріалів. Це дуже великі і складні завдання, які вирішили автори пристрою.

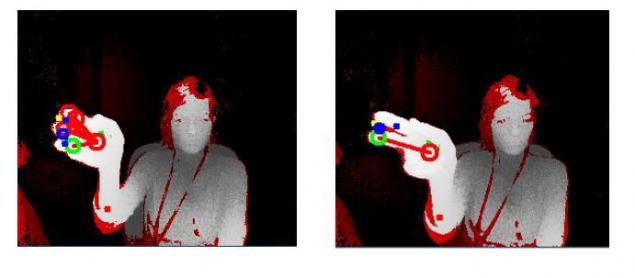

Ці фотокамери є найбільш неточними, але найпростішими і найдешевшими: всі складності в них є алгоритмом. Як виглядає ця камера? Ось він:

У другому Kinect є камера. Не плутайте другий кінект з першим (на хабі колись була хорошою і докладною статтю, де все ще плутати). Перший Kinect використовує структуроване освітлення. Це набагато більша, менш надійна і повільна технологія.

Використовується традиційна інфрачервона камера, яка виглядає на шаблоні. Його спотворення визначають діапазон (відокремлення методів можна побачити тут).

Але Кінект не єдиний на ринку. Наприклад, Intel виробляє камеру за 150 доларів, яка виробляє карту для зображень 3D. Він орієнтований на зону ближнього кута, але у них є SDK для аналізу жестів в кадрі. Ось ще одна версія від SoftKinetic (вони також мають SDK, плюс вони якось прив'язані до texas інструментів).

р.

р.

Я не бачив ніяких цих фотокамер, але це шампан. Але я думаю, і сподіваюсь, що в п'ять років вони вступають в використання і мій поворот прийде. Наскільки я знаю, вони активно використовуються в орієнтації роботів, введених в системи розпізнавання обличчя. Широкий асортимент завдань і додатків.

Джерело: habrahabr.ru/post/224605/

Технологія - це все хороше і цікаве, але чому є так багато гіп про кожен хиз?

Що, якщо я сказав, що в останні 10 років технологія 3D-фотозйомки була винайдена, розвинена і масово-продукована, дуже відрізняється від інших технологій? Технологія вже широко використовується. Доступні і доступні для звичайних людей в магазинах. Ви чули про це? (докладно лише фахівці з робототехніки та суміжних полів вже здогадали, що я розмовляю про фотокамери ToF).

Що таке камера ToF? У Російській Вікіпедії ви не знайдете навіть коротку згадку про те, що це таке. "Час льотної камери" перекладається як "Час льотної камери". Камера визначає діапазон через швидкість світла, вимірюючи час польоту світлового сигналу, що випускається камерою і відображає кожну точку отриманого зображення. Поточний стандарт - це 320 * 240піксельна матриця (попереднє покоління становитиме 640 * 480). Камера забезпечує точність вимірювання глибини близько 1 сантиметра. Я, ї. Матриця датчиків 76,800 забезпечують точність вимірювання часу замовлення 1/10,000,000,000 (10^-10) секунд. На продажу. Для 150 греків. Або можливо, ви навіть використовуєте його.

Тепер трохи більше про фізику, як це працює, і де ви знаходитеся з цією красою.

В наявності три основні типи камер ToF. Для кожного з типів використовується власна технологія вимірювання діапазону положення точки. Найпростіший і найбільш зрозумілий - "Пультова модуляція", ака "Пряме часові зображення" Відводиться імпульс і в кожній точці матриці точний час його повернення:

578163

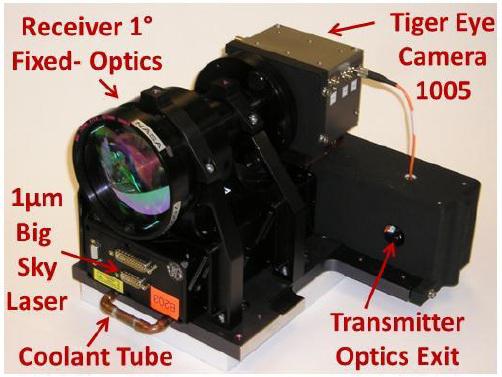

Насправді, матриця складається з тригерів, які запускаються вздовж хвилі фронту. Те ж саме метод використовується в оптичних синхронах для спалахів. Прийміть його замовлення більш точно. Це головна труднощі даного методу. Дуже точне виявлення часу відгуку, що вимагає специфічних технічних рішень (що я не можу знайти). Зараз такі датчики проходять випробування НАСА для землеробів своїх суден.

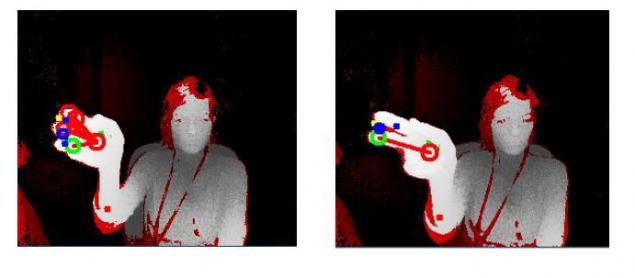

Ось фотографії вона дає:

Підсвітка на них достатньо для запуску оптичного потоку від відстані близько 1 кілометра. На графіку показано кількість запущених пікселів в матриці в залежності від відстані 90% роботи на відстані 1 км:

Другий метод є постійним модуляція сигналу. Випромінювач відправляє певну модульну хвилю. Ресивер знаходить максимальну кореляцію того, що він бачить з цією хвилею. Це визначає час, який бере сигнал, щоб відмовлятися і прибути на ресивер.

Дозволяти сигнал:

де w є модулююча частота. Тоді отриманий сигнал буде виглядати:

де b- some зсув, амплітуда. Поєднання вхідних і вихідних сигналів:

Але повна кореляція з усіма можливими зсувами в часі досить важко виробляти в режимі реального часу в кожному піксельі. Тому використовується хитрий прийом з вушками. Одержаний сигнал отримується в 4 сусідніх пікселів з фазовим зсувом 900 і гофрує з собою:

Потім фазовий зсув визначається як:

Знаючи отриманий фазовий зсув і швидкість світла, ми отримуємо діапазон до об'єкта:

Ці фотокамери трохи простіші, ніж ті, побудовані з першою технологією, але вони ще складні і дорогі. Ця компанія робить їх. І вони вартість близько 4 фунтів. Але милий і футуристичний:

Третя технологія - Range Gated Imagers. В основному камера затвору. Ідея тут не дуже проста і не вимагає високоточних ресиверів, а не складних кореляцій. Перед матрицею. Припустимо, що це ідеальний і працює миттєво. На час 0, освітлення сцени перетворюється. Застібка закривається в час т. Потім об'єкти далеко від т/(2∙c), де c - швидкість світла не буде видно. Світло не встигне дістатися до них і повернутися назад. Точка, розташована поруч з камерою, підсвічується в усі часи впливу т і має яскравість І. Так, будь-яка точка впливу матиме яскравість 0 до I, а яскравість буде представлення відстані до точки. Чим яскравіше, тим ближче.

Залишилося робити лише пара тріфл: ввести в модель час закривання штепсельної матриці і поведінку матриці в цьому заході, імперфікацію джерела освітлення (для точкового джерела світла, залежність діапазону і яскравості не буде лінійним), різне відображення матеріалів. Це дуже великі і складні завдання, які вирішили автори пристрою.

Ці фотокамери є найбільш неточними, але найпростішими і найдешевшими: всі складності в них є алгоритмом. Як виглядає ця камера? Ось він:

У другому Kinect є камера. Не плутайте другий кінект з першим (на хабі колись була хорошою і докладною статтю, де все ще плутати). Перший Kinect використовує структуроване освітлення. Це набагато більша, менш надійна і повільна технологія.

Використовується традиційна інфрачервона камера, яка виглядає на шаблоні. Його спотворення визначають діапазон (відокремлення методів можна побачити тут).

Але Кінект не єдиний на ринку. Наприклад, Intel виробляє камеру за 150 доларів, яка виробляє карту для зображень 3D. Він орієнтований на зону ближнього кута, але у них є SDK для аналізу жестів в кадрі. Ось ще одна версія від SoftKinetic (вони також мають SDK, плюс вони якось прив'язані до texas інструментів).

р.

р.

Я не бачив ніяких цих фотокамер, але це шампан. Але я думаю, і сподіваюсь, що в п'ять років вони вступають в використання і мій поворот прийде. Наскільки я знаю, вони активно використовуються в орієнтації роботів, введених в системи розпізнавання обличчя. Широкий асортимент завдань і додатків.

Джерело: habrahabr.ru/post/224605/

Panoramic HD камера Girоптичний: пагони під водою, викручені в картридж з лампочки, потоки через Ethernet і WiFi

Лазерний автофокус на смартфоні LG переміщається з пилососа