486

La inteligencia artificial ha aprendido a describir en lenguaje humano lo que él ve

Primero, los equipos han aprendido a reconocer nuestros rostros en las fotos, y ahora ellos no son lo suficientemente capaces de describir exactamente lo que el hombre hace en una u otra imagen.

El mes pasado, los ingenieros de Google han demostrado público de la red neuronal en el Deep Dream, que es capaz de transformar la imagen en el fantástico abstracto de la visión, ahora los científicos de stanford presentaron su desarrollo NeuralTalk, capaz de describir en lenguaje humano lo que ella ve.

Por primera vez NeuralTalk se mencionó el año pasado. El desarrollo de este sistema se dirigen director del Laboratorio de inteligencia artificial de la universidad de stanford de las hadas-las hadas Si, así como su graduado andrés Карпатый. El software escrito en el marco del proyecto, es capaz de analizar integral de la imagen y definir exactamente lo que está pasando, detallando todo lo hablado en lenguaje humano.

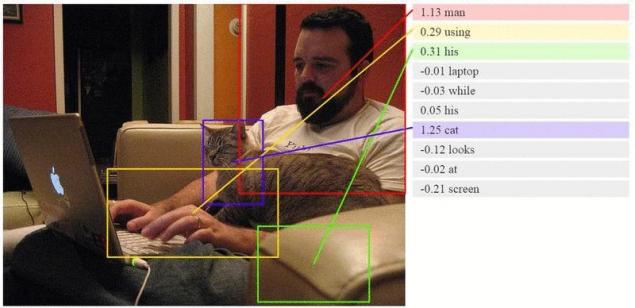

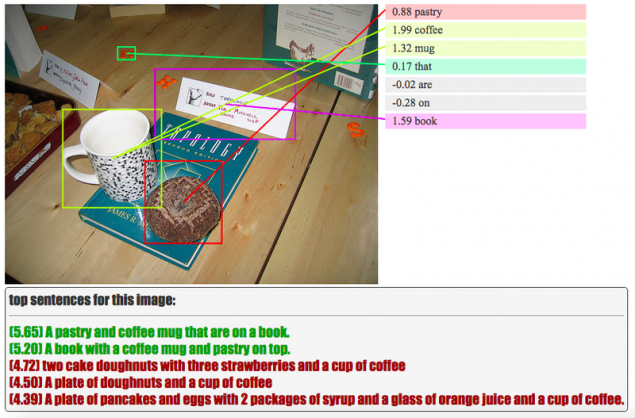

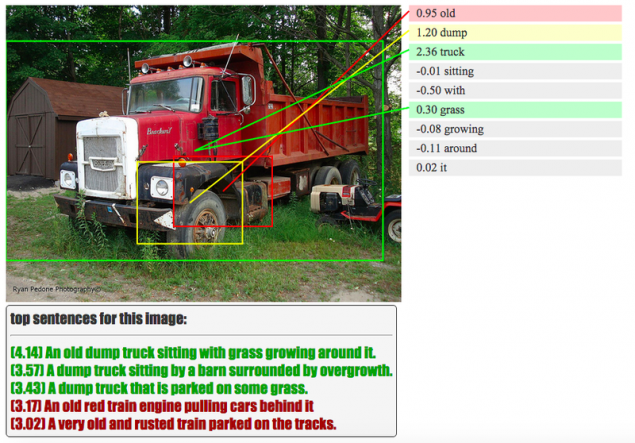

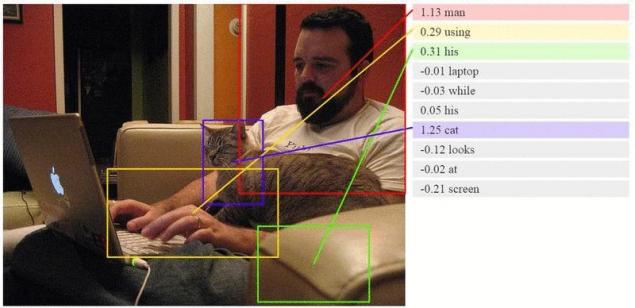

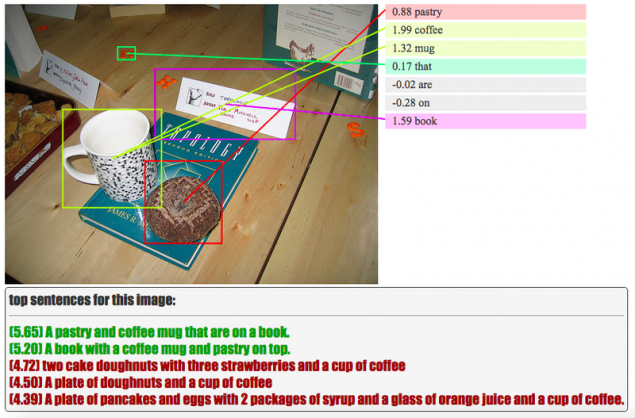

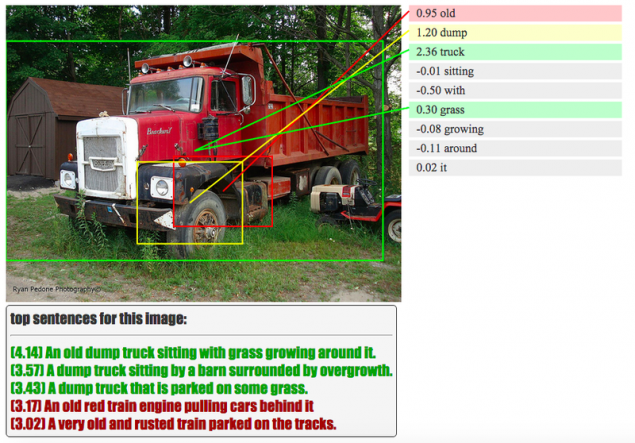

Por ejemplo, si en la foto se ve un hombre con una camiseta negra, tocando la guitarra, la inteligencia artificial y describir lo que vio: "un hombre con una camiseta negra toca la guitarra". Por supuesto, el trabajo aún continúa, por lo que el algoritmo es bastante a menudo permite divertidos errores, pero sin esto, la ciencia moderna de la nada. Puedes ver un poco más abajo, como se ve la interfaz de la versión de prueba del algoritmo. La ia busca en la imagen de los objetos individuales, un evento o actividad y les asigna las palabras, en definitiva, de un plegable en el sentido de la propuesta.

Cuando este en diferentes colores se notan los objetos, es el reconocimiento de que la inteligencia artificial de seguro en mayor o menor medida. Usted mismo puede ver el proceso de aprendizaje de la inteligencia artificial en el sitio web oficial de los investigadores.

Al igual que el sistema de Deep Dream de Google, NeuralTalk utiliza para su funcionamiento neuronal en la red. El algoritmo compara una imagen nueva con la ya antes vistas las fotos, al igual que un niño pequeño, asimilando nuevas palabras y recordar las imágenes de los objetos. Los científicos una y otra vez explican la inteligencia artificial, como se parece a un gato, o una hamburguesa de zapatos, y NeuralTalk recuerda todo esto y prácticamente sin errores reconoce estas imágenes en el futuro.

Los desarrolladores de juego fácil y muy tediosa labor de formación hambriento hasta el conocimiento de la inteligencia artificial. Deben colocarse millones "de las etiquetas con los nombres de los diferentes objetos que aparecen en miles de fotografías, antes de que la ia de aprender independientemente describir mostradas en él las imágenes y la situación. Para empezar, los científicos esperan que resultará crear un motor de la máquina, que en un instante puede encontrar interesa la imagen en los vastos espacios del internet.

Potencialmente en el futuro, esta red neuronal es capaz de mucho más. Por ejemplo, este algoritmo puede encontrar no sólo la fotografía, sino que le interesa en el momento de la película, serie de tv o video de YouTube.publicado

P. S. Y recuerde, sólo cambiando su consumo — estamos juntos cambiando el mundo! ©

Fuente: hi-news.ru

El mes pasado, los ingenieros de Google han demostrado público de la red neuronal en el Deep Dream, que es capaz de transformar la imagen en el fantástico abstracto de la visión, ahora los científicos de stanford presentaron su desarrollo NeuralTalk, capaz de describir en lenguaje humano lo que ella ve.

Por primera vez NeuralTalk se mencionó el año pasado. El desarrollo de este sistema se dirigen director del Laboratorio de inteligencia artificial de la universidad de stanford de las hadas-las hadas Si, así como su graduado andrés Карпатый. El software escrito en el marco del proyecto, es capaz de analizar integral de la imagen y definir exactamente lo que está pasando, detallando todo lo hablado en lenguaje humano.

Por ejemplo, si en la foto se ve un hombre con una camiseta negra, tocando la guitarra, la inteligencia artificial y describir lo que vio: "un hombre con una camiseta negra toca la guitarra". Por supuesto, el trabajo aún continúa, por lo que el algoritmo es bastante a menudo permite divertidos errores, pero sin esto, la ciencia moderna de la nada. Puedes ver un poco más abajo, como se ve la interfaz de la versión de prueba del algoritmo. La ia busca en la imagen de los objetos individuales, un evento o actividad y les asigna las palabras, en definitiva, de un plegable en el sentido de la propuesta.

Cuando este en diferentes colores se notan los objetos, es el reconocimiento de que la inteligencia artificial de seguro en mayor o menor medida. Usted mismo puede ver el proceso de aprendizaje de la inteligencia artificial en el sitio web oficial de los investigadores.

Al igual que el sistema de Deep Dream de Google, NeuralTalk utiliza para su funcionamiento neuronal en la red. El algoritmo compara una imagen nueva con la ya antes vistas las fotos, al igual que un niño pequeño, asimilando nuevas palabras y recordar las imágenes de los objetos. Los científicos una y otra vez explican la inteligencia artificial, como se parece a un gato, o una hamburguesa de zapatos, y NeuralTalk recuerda todo esto y prácticamente sin errores reconoce estas imágenes en el futuro.

Los desarrolladores de juego fácil y muy tediosa labor de formación hambriento hasta el conocimiento de la inteligencia artificial. Deben colocarse millones "de las etiquetas con los nombres de los diferentes objetos que aparecen en miles de fotografías, antes de que la ia de aprender independientemente describir mostradas en él las imágenes y la situación. Para empezar, los científicos esperan que resultará crear un motor de la máquina, que en un instante puede encontrar interesa la imagen en los vastos espacios del internet.

Potencialmente en el futuro, esta red neuronal es capaz de mucho más. Por ejemplo, este algoritmo puede encontrar no sólo la fotografía, sino que le interesa en el momento de la película, serie de tv o video de YouTube.publicado

P. S. Y recuerde, sólo cambiando su consumo — estamos juntos cambiando el mundo! ©

Fuente: hi-news.ru