486

人工智能已经学会了描述了在人类的语言,他看到什么

第一,计算机已经学会认识到我们面临的图片,现在他们所有人都能够准确地描述什么是一个人不会在一个特定的图像。

上个月,谷歌工程师向公众展示了一个神经网络深的梦想,这是能够改变的图片进入梦幻般的抽象的愿景,而现在科学家从斯坦福大学提出了他们的项目NeuralTalk来描述在人类的语言是什么她看到。

第一次NeuralTalk中提到的最后一年。 该系统的开发是导致总干事的人工智能实验室在斯坦福大学的阿飞-飞李和他的研究安德鲁喀尔巴阡山脉。 软件编写该项目的框架,能够执行复杂的图像和准确地确定发生了什么他介绍,描述了一切你看到的就是说在人类的语言。

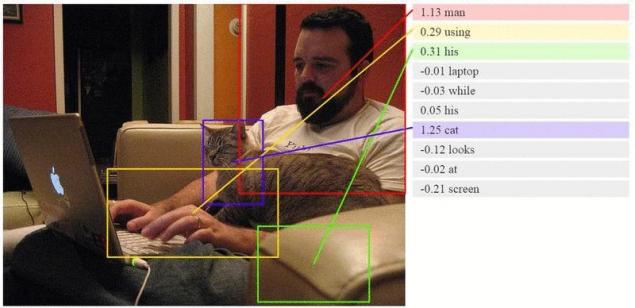

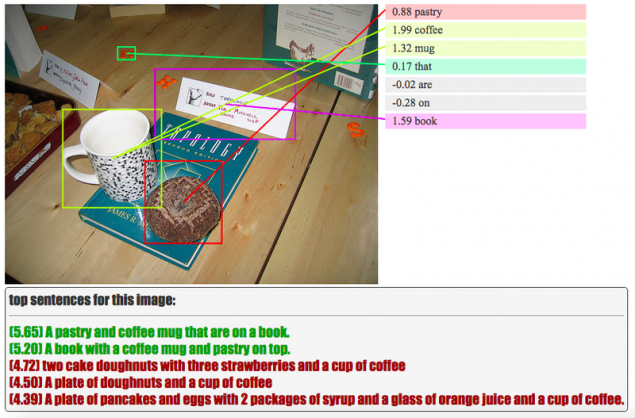

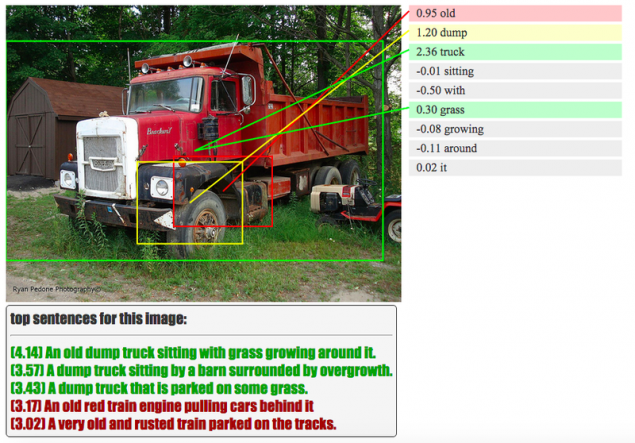

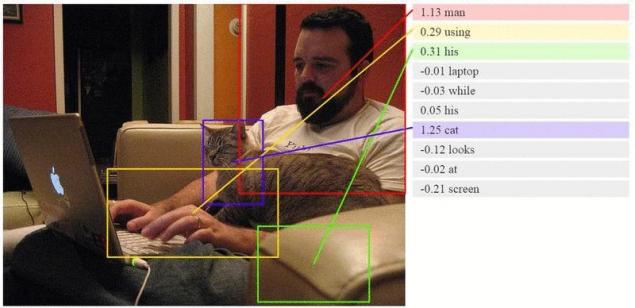

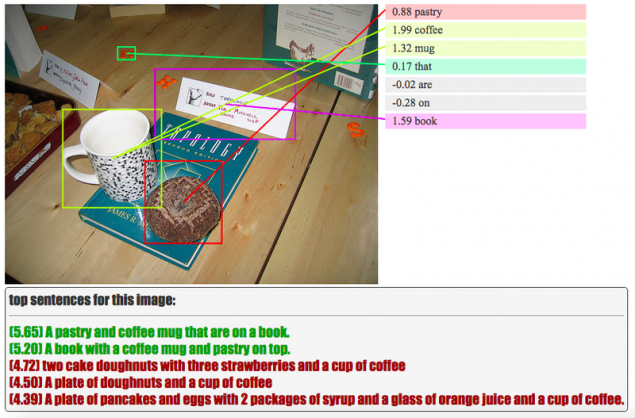

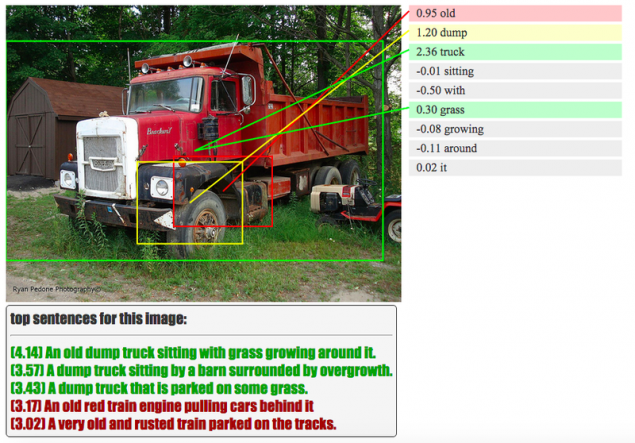

例如,如果照片描绘了一名男子在黑色衬衫弹吉他、人工智能,并描述了他所看到的:"一名男子在黑色衬衫弹吉他的"。 当然,这项工作仍在进行,因此算法往往使得有趣的错误,但没有它,现代科学的任何地方。 你可以看到下面,看起来像一个UI测试版本的算法。 AI现在图像正独立的对象、活动或行动,并赋予他们个人的话,最终折他们成为一个有意义的句子。

不同的颜色标记的目的、正确的认识,它是人工智能我相信,在一种或另一种方式。 你可以看到的过程中学习的人工智能的官方网站上的研究人员。

像深深的梦想系统,NeuralTalk使用神经网络。 对算法进行比较新的图像已经看到前面的照片,像一个小孩子学习新的词汇和想起了图片的对象。 科学家们反复解释的人工智能看起来像猫一样的汉堡或者靴子,并NeuralTalk记住这一切,并且几乎无误地确定了这些图像的未来。

开发商将有困难的和非常繁琐的工作,教饥饿的知识的人工智能。 他们应该把数以百万计的"签名"的不同对象的描绘成千上万的镜头前AI学来描述的图像显示他和情况。 首先,科学家们希望,他们将创建一个搜索引擎,这对于那一刻将能够找到一个有趣的画面在广袤的互联网。

可能在未来,这样的神经网络能够更多。 例如,算法可以找到不仅照片,但是你感兴趣的一刻,在电影,电视剧或视频传到YouTube。出版

P.S.记住,仅仅通过改变他们的消费—我们一起改变世界了。 ©

资料来源:hi-news.ru

上个月,谷歌工程师向公众展示了一个神经网络深的梦想,这是能够改变的图片进入梦幻般的抽象的愿景,而现在科学家从斯坦福大学提出了他们的项目NeuralTalk来描述在人类的语言是什么她看到。

第一次NeuralTalk中提到的最后一年。 该系统的开发是导致总干事的人工智能实验室在斯坦福大学的阿飞-飞李和他的研究安德鲁喀尔巴阡山脉。 软件编写该项目的框架,能够执行复杂的图像和准确地确定发生了什么他介绍,描述了一切你看到的就是说在人类的语言。

例如,如果照片描绘了一名男子在黑色衬衫弹吉他、人工智能,并描述了他所看到的:"一名男子在黑色衬衫弹吉他的"。 当然,这项工作仍在进行,因此算法往往使得有趣的错误,但没有它,现代科学的任何地方。 你可以看到下面,看起来像一个UI测试版本的算法。 AI现在图像正独立的对象、活动或行动,并赋予他们个人的话,最终折他们成为一个有意义的句子。

不同的颜色标记的目的、正确的认识,它是人工智能我相信,在一种或另一种方式。 你可以看到的过程中学习的人工智能的官方网站上的研究人员。

像深深的梦想系统,NeuralTalk使用神经网络。 对算法进行比较新的图像已经看到前面的照片,像一个小孩子学习新的词汇和想起了图片的对象。 科学家们反复解释的人工智能看起来像猫一样的汉堡或者靴子,并NeuralTalk记住这一切,并且几乎无误地确定了这些图像的未来。

开发商将有困难的和非常繁琐的工作,教饥饿的知识的人工智能。 他们应该把数以百万计的"签名"的不同对象的描绘成千上万的镜头前AI学来描述的图像显示他和情况。 首先,科学家们希望,他们将创建一个搜索引擎,这对于那一刻将能够找到一个有趣的画面在广袤的互联网。

可能在未来,这样的神经网络能够更多。 例如,算法可以找到不仅照片,但是你感兴趣的一刻,在电影,电视剧或视频传到YouTube。出版

P.S.记住,仅仅通过改变他们的消费—我们一起改变世界了。 ©

资料来源:hi-news.ru