235

凯文·阿博施: 人工智能的道德框架

(英语).

(英语).人工智能将不可避免地引导我们走向一种机器反抗人类相当受欢迎的情景. 人工超智能似乎是最大的威胁, 神奇的阴谋说,在一个拥有技术的世界里,我们不会需要。

这是不可避免的吗? 20世纪60年代对智能计算机系统的文学和电影描写,帮助塑造和概括了我们对未来的期望,因为我们走上了创造机器智能高于人类智能的道路. 在某些需要复杂计算的具体任务中,AI显然已经超越了人类,但在其他一些能力方面仍然落后. 如何同时增加这种严酷手段的力量,维持我们的经济地位.

随着人工智能已经并将继续在我们的未来发挥巨大作用,探索我们与这些复杂技术共存的可能性至关重要。

Kevin Abosch是Kwikdesk的创始人,他从事数据处理和人工智能的开发,他分享了对这一问题的看法. 他认为人工智能应当快活,隐形,可靠,能干和有道德. 对,道德

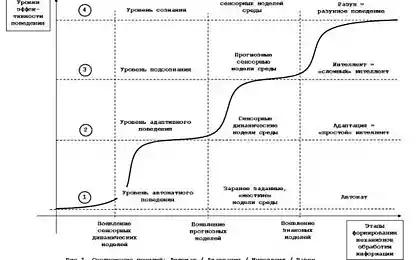

人工神经网络的概念在生物神经网络的相似性中被创造出来,并不是新的. 计算功率的单位,称为神经元,互相连接并形成网络. 每个神经元在输入时应用一个复杂的学习算法,然后将数据转移到其他神经元,直到输出时神经元被激活并打开读取的可能性. 专家系统依靠人们播下知识种子来“教导”系统。 逻辑处理机制寻找通信,作出选择,并就知识基础制定“如果是这样,那么”规则。 在这个过程中,知识库中增加了新的知识. 纯神经网络在获得非线性经验的过程中学习,没有专家播种知识的问题. 事实证明,混合网络可以提高机器学习能力。

现在让我们看看这些制度的伦理问题。 从第一人出.

第559913号

作者用文字来将读者浸入虚构的世界,并以不同的方式进行,但伟大的作者却非常优雅地进行. 一个软件工程师写出代码行来方便数据处理和移动. 他也可以从许多选择中选择不同的方式,但优雅的编码者——计算机科学的人物. 先进的编码器侧重于如何尽可能多和更好地纳入短而优雅的编码. 额外代码保存到最低限度. 大码还保留了开放窗口,用于后续添加. 其他工程师可以以所固有的优雅来添加代码,而产品则能无缝地发展.

任何人造产品的核心都是意图. 人制造的东西充满了意图,在某种程度上是创造者本质的载体. 有些人觉得很难想象有这种性质的无生命的物体. 但许多人会同意。 意向之能已经存在了几千年,统一了,分裂了,团结了,改造了社会. 不能低估语言的力量。 记住代码行用特定的编程语言来写. 因此,我相信成为计算机或移动设备上使用的软件的代码非常"活".

不考虑计算机科学背景下的智慧和精神,以及人工智能的潜在后果,我们仍然可以将静态代码视为具有做好事或做恶的潜力. 这些产出只存在于人们使用应用程序的过程中. 人们做出的明确选择 影响了应用的性质 它们可以在一个地方制度中加以考虑,确定对该制度的积极或消极影响,或根据一套预先确定的标准。 然而,正如记者在撰写一篇文章的过程中不能百分百公正一样,因此工程师故意或无意地将他意图的性质添加到密码中去. 有人可能认为书写代码是一个逻辑过程,而真正的逻辑没有给自然留下任何空间.

但我敢肯定,当你创造规则, 块码,或整个码, 它都充满了人性元素。 每个附加规则,子孙的穿透会加深. 密码越复杂,这种性质越有. 这就提出了这样一个问题:“守则的性质是好还是坏? “

显然,一个黑客所研发的病毒恶意地突破了你的计算机防御系统,并给自己的生命造成破坏,它充满了邪恶的本性。 但“好人”为了渗透恐怖组织的电脑以防止恐怖袭击而制造的病毒呢? 他的本质是什么? 从技术上讲,它可以与其邪恶的对应物完全相同,仅仅用于“好”目的。 所以他的本性是好的吗? 这是恶意软件的道德悖论. 但我们不能忽视“邪恶”守则。

我认为,有些守则本质上偏向于“邪恶”,有些守则本质上是仁慈的。 这在离线计算机方面更为重要.

第

号

号在Kwikdesk,我们正根据我设计的专家系统/线粒体神经网络设计一个AI框架和协议,这个网络最类似于迄今为止创建的生物模型。 Neurons作为输入/输出模块和虚拟设备(从某种意义上说,是自主的代理)出现,由“axons,”安全,分离的加密数据通道相接. 这些数据在进入神经元时被解密,经过某些过程,在发送到下一个神经元之前被加密. 在神经元能够通过轴相通之前,必须进行参与者和通道密钥的交换.

我认为,这种网络应该从最低一级纳入安全和分离。 加成部分反映了其最小组件的特质,因此任何小于安全构件会使整条线路不安全地运行. 为此,必须在当地保护数据,并在本地传输中解密.

可以理解的是,我们的生活质量与越来越聪明的机器一样令人担忧,我绝对相信,我们必须采取行动,确保子孙后代有一个健康的未来。 智能机的威胁可能多种多样,但可以细分为以下几类: 智能机:

预留. 在工作场所,人们会被汽车所取代. 这种转变已经持续了几十年,只会加快。 需要教育,使人民为未来做好准备,使数以亿计的传统工作完全不复存在。 这很复杂。

警卫 我们完全依靠机器,并将继续依靠机器。 随着我们从安全区向潜在危险区过渡时越来越信任机器,我们可能面临机器出错或恶意代码的风险. 以交通为例。

卫生。 个人诊断装置和网络医疗数据. 大赦国际将继续推进预防医学和多源遗传数据分析。 我们必须再次保证这些机器不会进行恶意颠覆或以任何方式伤害我们。

缘起. AI以越来越准确的预测方式预测你将到哪里去和做什么. 随着这个行业的发展,它会知道我们做出什么决定,我们下周将去哪里,我们将购买什么产品,甚至当我们死去的时候。 我们希望其他人能够访问这些数据吗?

知识. 机器事实上积累了知识. 但如果他们获得的知识比人类更快 检验他们,我们怎么能相信他们的正直呢?

最后,对AI采取警惕和负责任的方法,减轻技术超新星爆炸中的潜在麻烦,是我们的方式. 我们要么驯服AI的潜力,并祈祷它只会给人类带来最美好的东西,要么我们燃烧它的潜力,这将反映我们最糟糕的情况。

资料来源:hi-news.ru。