2095

危险的技术

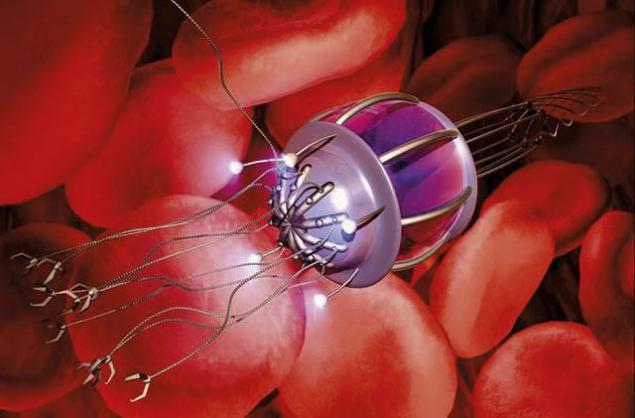

例如,纳米技术。一方面,它们可以杜绝赤字在几乎每个行业,它们可以清洁环境,改变的人(生理学,生物化学和基因),但在另一方面,它们可以在一段相对较短的时间用于地球上的生命的破坏。因此,当谈到时间为未来技术的创造和发展,我们必须非常谨慎。

技术突破 - 它不仅带来的好处,和人工智能可以是一个例子。帕特里克·林,«道德+新兴科技集团»主任加州州立理工大学说:

“技术本身就是中性。他们是不道德的,必须消除一个神话。每个创建者可以填补他的创作的道德,即使它本身并不重要。在大多数情况下,人们不会注意到,但一些现代技术最初诞生与恶意。在任何情况下,每个人都知道,大多数成熟的技术可以用于好还是坏。如果使用更不利的机会,那么这可能是创造技术的原因,仅仅是不值得的。“

Nanooruzhie

没有什么能结束在地球上我们的统治,比武器“分子组装”更快。

两个非常强大的因素导致的威胁。这种不受控制的自我复制和这种武器与指数自发传播。政府或一般人能设计出会消耗我们的地球的有限资源,以光的速度,并在同一时间复制自身,创造一个无用的产品,被称为“灰色粘质”微观机。

理论家罗伯特·弗雷塔斯,冲昏头脑纳米技术,来到我们这个世界中可以存在多种nanoubiyts结论:除尘灰,灰色的浮游生物,灰色地衣和所谓的杀手生物质。灰色的灰尘不会错过的阳光,灰色的浮游生物复制会造成海底世界,这将吸收的能量丰富的海底世界,灰色地衣毁灭地球的植被和生物杀手会攻击并摧毁一切可能的生物。

据塔斯,最坏的情况下,为人类 - “全球ecophagy”(Ecophagy或灰色粘质 - 分子纳米技术的成功相关假设最坏的情况)的情况下,需时约20个月就足以推动建立一个有效的防御。为保护,弗雷塔斯心目中可能涉及反措施自我复制的纳米技术,或某种违反纳米机器人的内部机制的系统。另一方面,我们可以事先建立一个“有源盾”,尽管大多数专家认为,它们将是无用的。

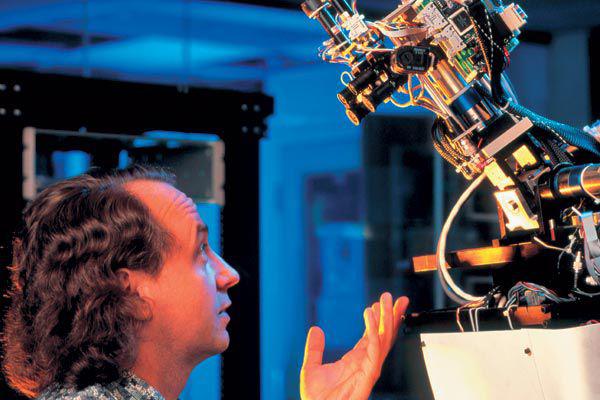

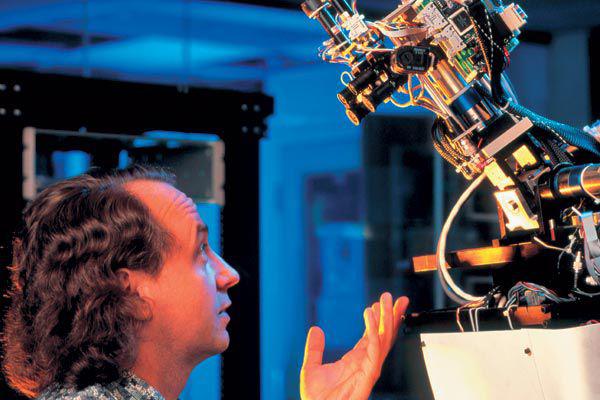

机器的意识

,在结束时,我们被赋予了智能机的想法,是很自然的感觉。但是,你首先需要在这样做之前要三思而后行。创建一台机器能正常的大脑内(名副其实),能够模拟人类和动物是很危险的我们。

早在2003年,哲学家托马斯·梅青格尔认为,这将是非常不道德的开发软件,能吃苦。

你会说,如果有人来了,说:“我们希望基因修改弱智婴儿一般的科学进步。我们需要孩子具有一定的认知和情感的局限,探讨产后心理发展!“你肯定已经决定,它不仅是荒谬的,可怕的,和不道德的想法。我希望,没有道德委员会并没有在现代世界批准。然而,今天的伦理委员会并不认为这是理性的第一辆车的原型。

未来学家路易斯头盔同意这个观点。这就是他告诉我:

“一个计算机的主要优点是,你可以问他们一个亿的方案和目标,他们不会无聊地实现它们,因为它会与谁仍然会采取进攻的工作,这样的容积的人。由于我们计划使用的,而不是人类的智力劳动人工智能,我认为这将是不道德的故意编程意识的机器。»

把意识进入机内,并使其做的工作对我们来说,其实是真正的奴隶。此外,意识 - 真是脆弱的东西。只是在人体内的几个不正确编码的基因可导致唐氏综合症,精神分裂症,孤独症或癫痫。这是可怕的,知道你原先设定的功能障碍。它是如此思维机器进行编程。

例如,一些资金雄厚的开发商AI(人工智能 - 人工智能)要重新人类智能的机器,模仿人脑的生物结构。为了防止社会的崩溃,它不应该防止与自我意识的创造人工智能。不是因为它是不冷静甚至是不可能的,但仅仅是因为使用意识之中,即使机器人,其实是一种苦役。

人工超级智能

根据今年霍金“创造人工智能可能会在历史上我们最大的失误。”事实上,正如我们已经提到,超级智能的出现可能是灾难性自己的。系统的实施,这将是比我们更快,更聪明,迫使我们要靠边站。我们只是等待超级智能的怜悯 - 而不是事实,我们可以用心友好创建AI,因此,建立一个超级AI将完成疯狂。

时光倒流回去

如果你想清楚,然后,在本质上,时间旅行 - 最所有的技术是不可能的。但是,如果可能的话,应该远离它。这将是令人难以置信的危险。任何关于时间的科幻片偏移间隔一定不自禁地想到这样的旅程的潜在危险。即使某种形式的量子时间旅行是完全不同的文明之间可能的,文化和技术交流会结束得厉害。

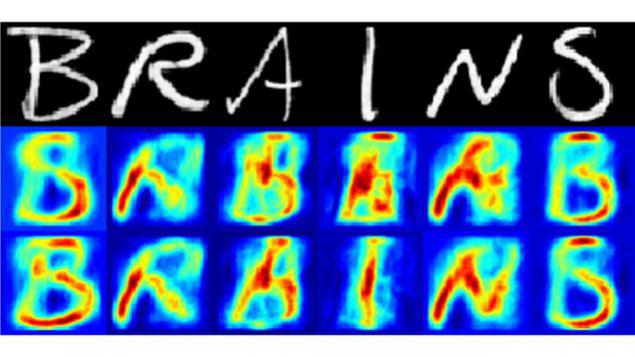

设备,读心术

即使在今天,也有创造,可以在距离读心术和人们的记忆机的成功,没有他们的同意。但可能只会是可能的人脑以任何方式之后被集成到互联网的网络或其他通信手段。

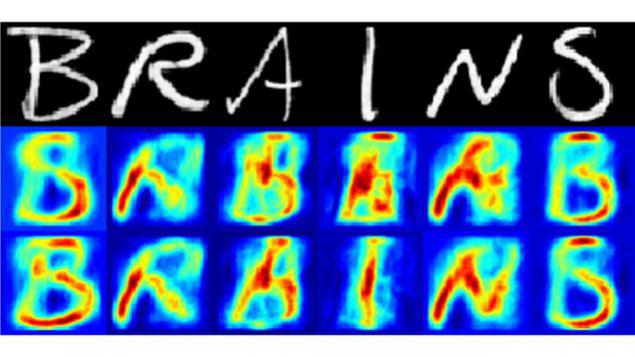

以去年为例,荷兰科学家利用脑扫描算法的数据,以确定哪些字母观看的人。该实验是一个真正的突破,并表明,即使现在可以用一个足够高的水平的细节,包括有关我们所看到的,思考和记忆信息恢复人的心灵。这样的设备,如果他们中的任何极权主义政权被大量使用,就会使生活难以忍受。这将是一种奥威尔式的世界中,将有一个真正的惩罚“思想犯罪”。

设备,“破解”大脑

另一种可能改变我们的思想对我们的意志,没有我们的知识。当我们的大脑建立一个芯片,我们变得容易对他们的影响从外部和我们的头脑将是在互联网上,约等于您的设备从你正在阅读这篇文章。

令人难以置信的是,我们已经采取了实现这一目标的第一步。最近,神经学家的一个国际研究小组建立了一个实验,让参与者基本上是使用所谓的通过Internet进行通信的“数字心灵感应”。当然,这是伟大的,但它是一个数字心灵感应可以打开了潘多拉的盒子。也许你在“攻壳机动队”,那里的黑客有能力修改的回忆和受害者的意愿人工智能所描述的可能情形。现在想象一下,在有组织犯罪或偏执政府手中的武器。

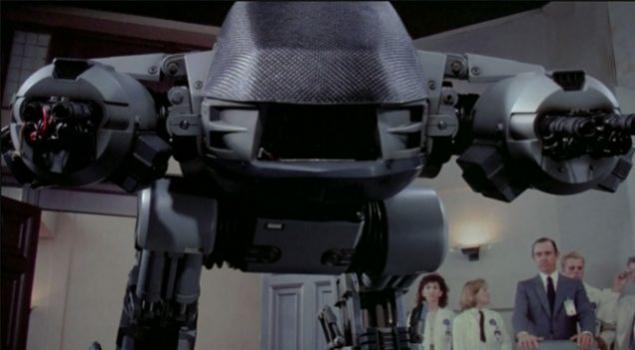

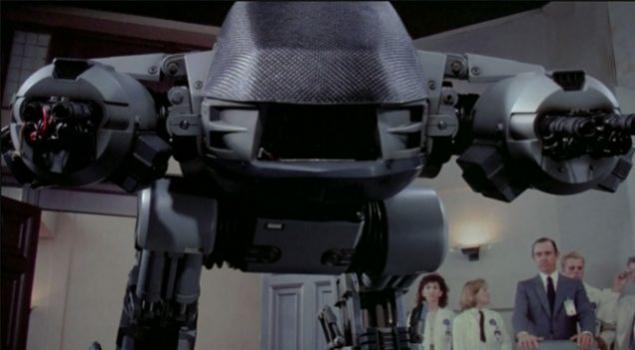

自主杀手机器人

这个问题已经有今天。在这里,在这个场合表示,未来学家迈克尔·拉托:

“我们尚没有这样的机器,它会表现出智慧,一个人的一般水平,而是一种特殊roboubiytsam不介意。制造各种机器人战斗的机器已经交付到流。机器人-tanki,-samolety,离车,-podvodnye船,和人类robosoldaty今天存在。与遥控无人驾驶飞机,军用机器人可以识别目标并摧毁他们无需人工干预,让自己的最终命令“火”。这种技术的危险性是显而易见的,因为即使在今天,由士兵控制,机器人已经有很多十倍误杀死自己,甚至是无辜平民。»

在巨大的危险潜伏在可以开始,如果任何国家将委托这种部队的国际军备竞赛。之后的改进该技术的几个周期,其电平可以超过所有可以想象方面。自主机器人可以影响人类所控制的任何系统。于是,无论是意外发生或有恶意企图,人类将在人工智能完全服从。

病毒

另一个非常糟糕的主意。早在2005年,雷库兹威尔和比尔·乔伊指出,公布的致命病毒的基因组 - 它就像一个配方的煎饼,但最终得到的产品,为地球上所有生命的毁灭。总有一些白痴风扇或在世界上重新创建病毒或改善现有的,以使其更加有效,然后“释放”的概率。据估计,例如,修改后的禽流感可能杀死世界人口的一半。因此,研究人员从中国加入了禽流感和猪流感,创建由飞沫传播的突变病毒。敌人必须知道的人,当然好,但它仍然是值得记住的事实,突变病毒可以用作武器攻击的想法。此外,总有一种危险,即该病毒可以从实验室逸出和肆虐。

虚拟监狱和惩罚

什么是监狱,当人们能活几百年甚至上千的惩罚?伦理学家丽贝卡·罗奇认为以下情形:

“的显着提高预期寿命的好处是显而易见的,但它也可能会导致增加惩罚的严重程度。试想,一个人能活1000年以上,那么他将是微不足道的5-50年期限,时间,因此对所有罪行将增加的长度。但问题出现了,当守法公民将需要支付100-500年的凶手,这是比较合理的。当然,这将击中社会的口袋。但是,如果增加预期寿命povsemestro,这些成本可以通过在劳动力的长寿命的代表增加捐款抵消。»

但最有可能到那个时候会有人类大脑的编程活动的方式。编程判处超快的运行速度的大脑,我们就可以把它变成8.5小时留在监狱千年辛勤劳动。显然,这将是比1000年的徒刑的实时送达便宜得多。

这当然是好的,但也存在问题,伦理和道德的一面。

设计地狱

这有点类似于前面“技术”。一些未来学家也要讲采用先进的技术,尤其是虚拟现实的意识开机直接进入人脑。也走过了艰难的一天之后,大脑连接到网络,并在天堂。但是,如果你可以创建一个天堂,你可以创建和地狱。事实上,这是你能想象的最糟糕的点子之一。这是另一个原因,应禁止人工超级智能的开发,由于担心蛇怪罗科的所谓时代的开始。

蛇怪罗茨科 - 人工智能的一个神圣的形式,如此危险,如果你只是想想而已,然后再花我的余生在可怕的折磨。

而鉴于现代人迷上了现代技术(如社交网络),人类的一对高科技的未来似乎并不那么耀眼。

来源:muz4in.net

技术突破 - 它不仅带来的好处,和人工智能可以是一个例子。帕特里克·林,«道德+新兴科技集团»主任加州州立理工大学说:

“技术本身就是中性。他们是不道德的,必须消除一个神话。每个创建者可以填补他的创作的道德,即使它本身并不重要。在大多数情况下,人们不会注意到,但一些现代技术最初诞生与恶意。在任何情况下,每个人都知道,大多数成熟的技术可以用于好还是坏。如果使用更不利的机会,那么这可能是创造技术的原因,仅仅是不值得的。“

Nanooruzhie

没有什么能结束在地球上我们的统治,比武器“分子组装”更快。

两个非常强大的因素导致的威胁。这种不受控制的自我复制和这种武器与指数自发传播。政府或一般人能设计出会消耗我们的地球的有限资源,以光的速度,并在同一时间复制自身,创造一个无用的产品,被称为“灰色粘质”微观机。

理论家罗伯特·弗雷塔斯,冲昏头脑纳米技术,来到我们这个世界中可以存在多种nanoubiyts结论:除尘灰,灰色的浮游生物,灰色地衣和所谓的杀手生物质。灰色的灰尘不会错过的阳光,灰色的浮游生物复制会造成海底世界,这将吸收的能量丰富的海底世界,灰色地衣毁灭地球的植被和生物杀手会攻击并摧毁一切可能的生物。

据塔斯,最坏的情况下,为人类 - “全球ecophagy”(Ecophagy或灰色粘质 - 分子纳米技术的成功相关假设最坏的情况)的情况下,需时约20个月就足以推动建立一个有效的防御。为保护,弗雷塔斯心目中可能涉及反措施自我复制的纳米技术,或某种违反纳米机器人的内部机制的系统。另一方面,我们可以事先建立一个“有源盾”,尽管大多数专家认为,它们将是无用的。

机器的意识

,在结束时,我们被赋予了智能机的想法,是很自然的感觉。但是,你首先需要在这样做之前要三思而后行。创建一台机器能正常的大脑内(名副其实),能够模拟人类和动物是很危险的我们。

早在2003年,哲学家托马斯·梅青格尔认为,这将是非常不道德的开发软件,能吃苦。

你会说,如果有人来了,说:“我们希望基因修改弱智婴儿一般的科学进步。我们需要孩子具有一定的认知和情感的局限,探讨产后心理发展!“你肯定已经决定,它不仅是荒谬的,可怕的,和不道德的想法。我希望,没有道德委员会并没有在现代世界批准。然而,今天的伦理委员会并不认为这是理性的第一辆车的原型。

未来学家路易斯头盔同意这个观点。这就是他告诉我:

“一个计算机的主要优点是,你可以问他们一个亿的方案和目标,他们不会无聊地实现它们,因为它会与谁仍然会采取进攻的工作,这样的容积的人。由于我们计划使用的,而不是人类的智力劳动人工智能,我认为这将是不道德的故意编程意识的机器。»

把意识进入机内,并使其做的工作对我们来说,其实是真正的奴隶。此外,意识 - 真是脆弱的东西。只是在人体内的几个不正确编码的基因可导致唐氏综合症,精神分裂症,孤独症或癫痫。这是可怕的,知道你原先设定的功能障碍。它是如此思维机器进行编程。

例如,一些资金雄厚的开发商AI(人工智能 - 人工智能)要重新人类智能的机器,模仿人脑的生物结构。为了防止社会的崩溃,它不应该防止与自我意识的创造人工智能。不是因为它是不冷静甚至是不可能的,但仅仅是因为使用意识之中,即使机器人,其实是一种苦役。

人工超级智能

根据今年霍金“创造人工智能可能会在历史上我们最大的失误。”事实上,正如我们已经提到,超级智能的出现可能是灾难性自己的。系统的实施,这将是比我们更快,更聪明,迫使我们要靠边站。我们只是等待超级智能的怜悯 - 而不是事实,我们可以用心友好创建AI,因此,建立一个超级AI将完成疯狂。

时光倒流回去

如果你想清楚,然后,在本质上,时间旅行 - 最所有的技术是不可能的。但是,如果可能的话,应该远离它。这将是令人难以置信的危险。任何关于时间的科幻片偏移间隔一定不自禁地想到这样的旅程的潜在危险。即使某种形式的量子时间旅行是完全不同的文明之间可能的,文化和技术交流会结束得厉害。

设备,读心术

即使在今天,也有创造,可以在距离读心术和人们的记忆机的成功,没有他们的同意。但可能只会是可能的人脑以任何方式之后被集成到互联网的网络或其他通信手段。

以去年为例,荷兰科学家利用脑扫描算法的数据,以确定哪些字母观看的人。该实验是一个真正的突破,并表明,即使现在可以用一个足够高的水平的细节,包括有关我们所看到的,思考和记忆信息恢复人的心灵。这样的设备,如果他们中的任何极权主义政权被大量使用,就会使生活难以忍受。这将是一种奥威尔式的世界中,将有一个真正的惩罚“思想犯罪”。

设备,“破解”大脑

另一种可能改变我们的思想对我们的意志,没有我们的知识。当我们的大脑建立一个芯片,我们变得容易对他们的影响从外部和我们的头脑将是在互联网上,约等于您的设备从你正在阅读这篇文章。

令人难以置信的是,我们已经采取了实现这一目标的第一步。最近,神经学家的一个国际研究小组建立了一个实验,让参与者基本上是使用所谓的通过Internet进行通信的“数字心灵感应”。当然,这是伟大的,但它是一个数字心灵感应可以打开了潘多拉的盒子。也许你在“攻壳机动队”,那里的黑客有能力修改的回忆和受害者的意愿人工智能所描述的可能情形。现在想象一下,在有组织犯罪或偏执政府手中的武器。

自主杀手机器人

这个问题已经有今天。在这里,在这个场合表示,未来学家迈克尔·拉托:

“我们尚没有这样的机器,它会表现出智慧,一个人的一般水平,而是一种特殊roboubiytsam不介意。制造各种机器人战斗的机器已经交付到流。机器人-tanki,-samolety,离车,-podvodnye船,和人类robosoldaty今天存在。与遥控无人驾驶飞机,军用机器人可以识别目标并摧毁他们无需人工干预,让自己的最终命令“火”。这种技术的危险性是显而易见的,因为即使在今天,由士兵控制,机器人已经有很多十倍误杀死自己,甚至是无辜平民。»

在巨大的危险潜伏在可以开始,如果任何国家将委托这种部队的国际军备竞赛。之后的改进该技术的几个周期,其电平可以超过所有可以想象方面。自主机器人可以影响人类所控制的任何系统。于是,无论是意外发生或有恶意企图,人类将在人工智能完全服从。

病毒

另一个非常糟糕的主意。早在2005年,雷库兹威尔和比尔·乔伊指出,公布的致命病毒的基因组 - 它就像一个配方的煎饼,但最终得到的产品,为地球上所有生命的毁灭。总有一些白痴风扇或在世界上重新创建病毒或改善现有的,以使其更加有效,然后“释放”的概率。据估计,例如,修改后的禽流感可能杀死世界人口的一半。因此,研究人员从中国加入了禽流感和猪流感,创建由飞沫传播的突变病毒。敌人必须知道的人,当然好,但它仍然是值得记住的事实,突变病毒可以用作武器攻击的想法。此外,总有一种危险,即该病毒可以从实验室逸出和肆虐。

虚拟监狱和惩罚

什么是监狱,当人们能活几百年甚至上千的惩罚?伦理学家丽贝卡·罗奇认为以下情形:

“的显着提高预期寿命的好处是显而易见的,但它也可能会导致增加惩罚的严重程度。试想,一个人能活1000年以上,那么他将是微不足道的5-50年期限,时间,因此对所有罪行将增加的长度。但问题出现了,当守法公民将需要支付100-500年的凶手,这是比较合理的。当然,这将击中社会的口袋。但是,如果增加预期寿命povsemestro,这些成本可以通过在劳动力的长寿命的代表增加捐款抵消。»

但最有可能到那个时候会有人类大脑的编程活动的方式。编程判处超快的运行速度的大脑,我们就可以把它变成8.5小时留在监狱千年辛勤劳动。显然,这将是比1000年的徒刑的实时送达便宜得多。

这当然是好的,但也存在问题,伦理和道德的一面。

设计地狱

这有点类似于前面“技术”。一些未来学家也要讲采用先进的技术,尤其是虚拟现实的意识开机直接进入人脑。也走过了艰难的一天之后,大脑连接到网络,并在天堂。但是,如果你可以创建一个天堂,你可以创建和地狱。事实上,这是你能想象的最糟糕的点子之一。这是另一个原因,应禁止人工超级智能的开发,由于担心蛇怪罗科的所谓时代的开始。

蛇怪罗茨科 - 人工智能的一个神圣的形式,如此危险,如果你只是想想而已,然后再花我的余生在可怕的折磨。

而鉴于现代人迷上了现代技术(如社交网络),人类的一对高科技的未来似乎并不那么耀眼。

来源:muz4in.net