2105

Хазардні технології

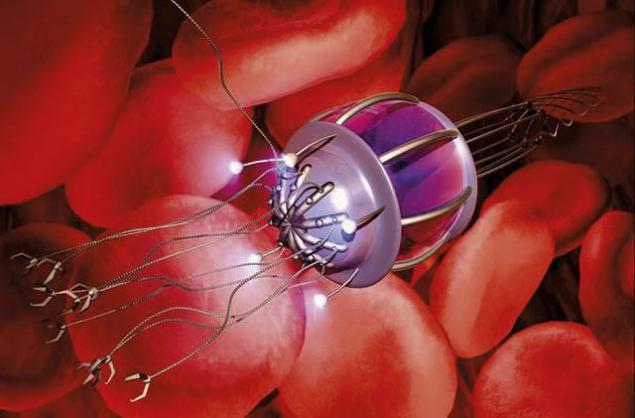

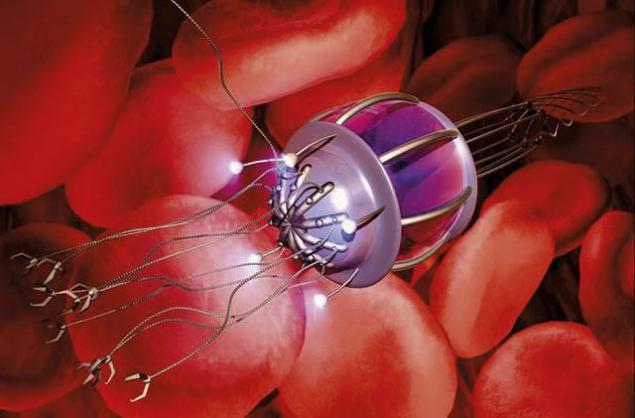

Наприклад, нанотехнології. З одного боку, вони можуть призвести до дефіциту, практично в будь-якій галузі, вони можуть очищати навколишнє середовище, відтворити людей (фізіологічно, біохімічно і генетично), але з іншого боку, вони можуть використовуватися для знищення життя на Землі в досить короткий час. Ми можемо самі зателефонувати одержувачу і узгодити зручний час і місце вручення квітів.

Технологічні прориви не просто про переваги, а штучний інтелект може бути прикладом цього. Патрик Лін, директор групи Ethics + Emerging Sciences в Каліфорнійському політехнічному університеті, сказав:

«Технологія притаманна нейтральному. Його безсмертність - міф, який повинен бути розбитий. Кожен творець може перенести його на моральність, навіть якщо він не має одного. У більшості випадків люди не помітили, але деякі сучасні технології народжувалися з шкідливим інтентом. У будь-якому випадку, кожен розуміє, що більшість технологій, створених, можуть використовуватися для хорошого і для шкоди. Якщо шанси звикати до шкоди більше, то це може стати причиною, чому це просто не варто створювати цю технологію. й

Р

Р

Навушники

Ніщо не може закінчити наше панування на Землі швидше, ніж молекулярна збірна зброя.

Два дуже потужних чинники створюють цю загрозу. Це неконтрольоване саморозвиток і спонтанне поширення такої зброї. Уряд або загальна людина може розробляти мікроскопічні верстати, які споживають кінцеві ресурси нашої планети на швидкості світла і одночасно відтворять себе, створюючи непотрібні продукти, які називають «сірою стрункістю».

Аоріст Роберт Фрейтас, зачарований нанотехнологією, прийшов до висновку, що в нашому світі може бути кілька видів нанавиків: сірий пил, сірий планктон, сірий лишай і так звані біомаси вбивці. Сірий пил не дасть сонячним променям, сірий планктон створить реплікатори підводного світу, що поглинає енергію-багатим підводним світом, сірі лишені знищать наземну рослинність, а біомасові вбивці атакують і знищать всі можливі живі організми.

За словами Фрітаса, найгірший сценарій для людства є сценарієм «глобальної екофагії» (екофагії або сірого слизу – це гіпотетичний сценарій, пов’язаний з успіхом молекулярної нанотехнології) займе близько 20 місяців, що досить створити ефективний захист заздалегідь. Як захист, Freitas посилається на протипоказання, швидше за все, за участю самореплічуючих нанотехнологій, або своєрідної системи, яка б порушить внутрішні механізми наноботів. З іншого боку, ми можемо створити "активні щити" заздалегідь, хоча більшість експертів вважають, що вони будуть без використання.

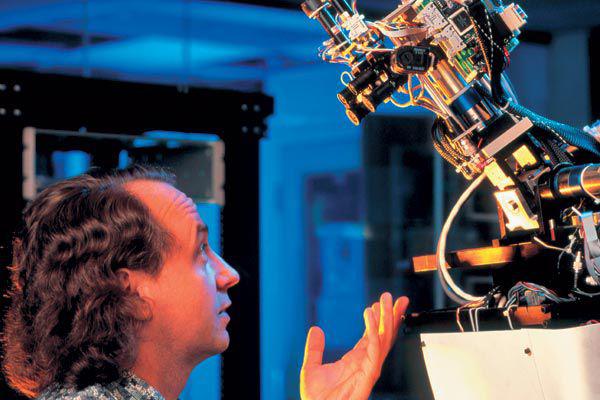

Складні машини

Ідея, яку ми в кінцевому підсумку доведемо машину з інтелектом вже природною. Але перш за все, ви повинні ретельно подумати перед цим. Створення верстата з функціонуванням мозку всередині (літерально і фігурно), що може імітувати людей і тварин.

Повернувшись у 2003 році, філософ Томас Метзінгер стверджує, що він буде неетичну для розробки програмного забезпечення, яке може постраждати.

Що б ви сказали, що хтось прийшов і сказав: "Ми хочемо, щоб генетично змінити психічно ретаровані немовляти для наукового прогресу по всьому світу". Для вивчення психологічного розвитку післяпартуму потрібні діти з певними когнітивними та емоційними обмеженнями. Ви обов'язково подумайте, що це не просто абсурд, терористична і безсмертна ідея. Я сподіваюсь, що в сучасному світі немає етики. Тим не менш, сьогодні етичний комітет не бачить його як прототип першого верстата, що наданий інтелектом.

Футуристи Луїс Хальм погоджується з цим видом. Ось що сказав мені:

«Одна з найбільших переваг комп’ютерів полягає в тому, що ви можете надати їм мільйони програм і завдань, і вони не будуть нудьгувати їх, оскільки вони будуть з особою, яка буде відхилена такою великою кількістю робіт». Оскільки ми плануємо використовувати штучний інтелект замість людської інтелектуальної праці, я думаю, що це буде безсмертним для навмисно програмувальних машин з свідомістю. ?

Поставляючи свідомість всередині машини і роблячи це зробити роботу для нас дуже раб. Свідомість є дійсно крихким. У людському тілі можна викликати синдром внизу, шизофренія, аутизм або епілепсія. Для того, щоб зрозуміти, що ви спочатку запрограмовані для дисфункції. Це те, як будуть запрограмовані машини.

Наприклад, кілька добре фінансованих AI (Artificial Intelligence) розробники хочуть відтворити людський інтелект в машинах, зміщуючи біологічну структуру мозку людини. Для запобігання розпаду суспільства не варто допускати створення штучного інтелекту з самовідомістю. Не тому, що це не крутий або неможливий, але просто тому, що використання свідомої істоти, навіть робот, по суті, рабство.

Штучна суперінтелігенція

Як Стівен Гокін заявив раніше цього року, «Будівля штучного інтелекту може стати нашою найбільшою помилкою.» Насправді, як ми неодноразово відзначили, поява суперінтелігента може бути катастрофічною для себе. Впровадження систем, які набагато швидше і розумніше, ніж ми змусимо нас крокувати. Ми просто збираємося бути на занурення суперінтелекту — і це не те, що ми зможемо створити штучний інтелект з дружними намірами, тому будувати над AI буде божевільним.

Час подорожі

По суті, час подорожі є найбільш неможливим для всіх технологій. Але якщо це можливо, ми повинні триматися від неї. Небезпечний. Будь-яка плівка про часові інтервали, що зміщуються, обов'язково пропонує потенційні небезпеки такої поїздки. І навіть якщо деякі форми квантових часових поїздок можливі, культурно-технологічні обміни між гетерогенними цивілізаціями можуть бути погані.

Розумні пристрої

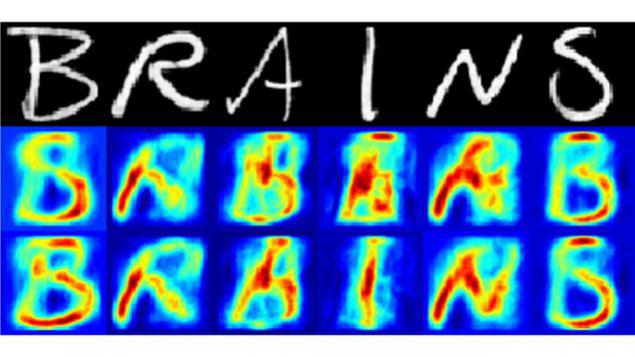

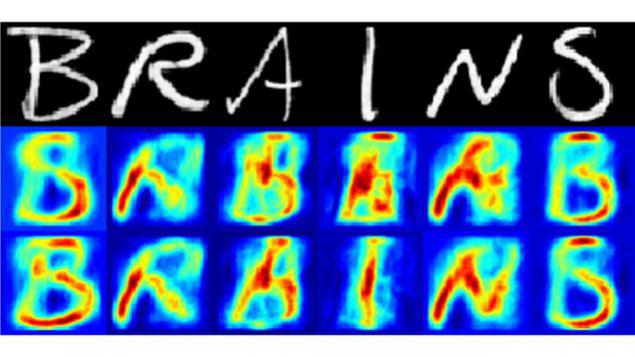

Вже в процесі створення машин, які можуть читати думки та спогади людей з далеких відстаней і без згоди. Але це, ймовірно, стане можливим тільки після того, як мозок людини, якось інтегрований в Інтернет або інші засоби зв'язку.

Минулого року, наприклад, вчені в Нідерландах використовували дані з алгоритмів сканування мозку, щоб визначити, які листи шукали людину. Експеримент виявився справжнім проривом, і показав, що вже можна реконструювати людські думки з достатньо високим рівнем деталей, включаючи інформацію про те, що ми бачимо, думають і пам'ятаємо. Такі пристрої, якщо використовуються масивно в будь-якому повнолітарному режимі, зроблять життя нестерпним. Це буде свого роду Орвеллійський світ, де дійсно буде покарання за "сумні злочини".

Р

Р

Пристрої, які "хака" мозку

Ще одна можливість змінити нашу свідомість і без наших знань. Ми можемо самі зателефонувати одержувачу і узгодити зручний час і місце вручення квітів, а якщо необхідно, то збережемо сюрприз.

Неймовірно, ми вже взяли перші кроки до цієї мети. Останнім часом міжнародна команда нейронауковців налаштувала експеримент, який дозволило учасникам спілкуватися в Інтернеті за допомогою чого називається «цифрова телепатія». Звичайно, це чудово, але це цифрова телепатія може відкрити Pandora. Можливо, один можливий сценарій описаний в Ghost в Shell, де хакер був штучним інтелектом, здатним модифікувати спогади і наміри його жертв. Тепер уявіть, чи є зброя в руках організованих злочинів або параноїдних урядів.

р.

р.

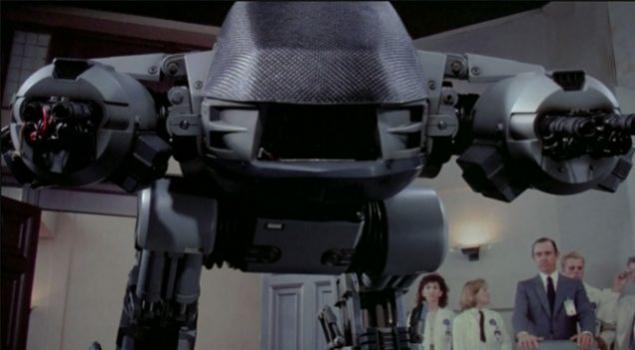

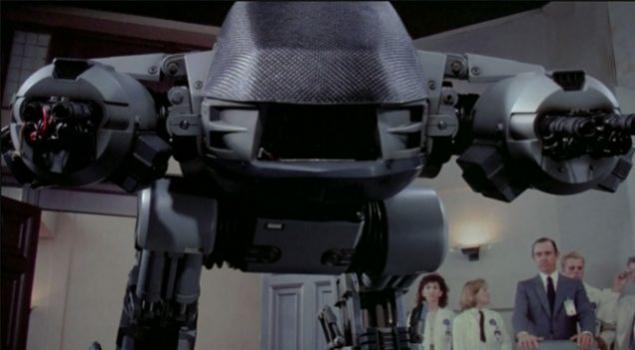

Автономні аварійні роботи

Ця проблема вже сьогодні. Ось що футурист Майкл Ла Торра сказав:

«Ми ще не маємо машини, яка демонструє загальний рівень інтелекту людини, але не потребує особливого інтелекту. Створення робототехніки всіх видів вже було поставлено на потік. Робо-танки, літаки, кораблі, підводні човни, люди-подібні солдати працюють сьогодні. На відміну від дистанційного керування безпілотним літаком, військові роботи можуть визначити цілі і знищити їх без втручання людини, надати собі остаточне замовлення «багаття». Небезпека таких технологій очевидна, тому що навіть сучасні, солдати-контрольовані роботи помилково загиближували себе, або навіть невинних цивільних, десятки разів.

Великою небезпекою є на міжнародній арені, яка може початися, якщо будь-яка нація поставила такі війська в службу. Після декількох циклів удосконалення такої техніки рівень його може перевершувати всі замкнені і немислимі грані. Автономні роботи зможуть вразити будь-які системи, які контролюються людьми. Після цього, як випадково, так і через шкідливий намір, людство буде в повній подачі на штучний інтелект.

р.

р.

Віруси

Ще одна дуже погана ідея. Повернувшись у 2005 році, Рай Курцвіл і Білл Джой зазначив, що видавництво геномів смертельних вірусів, як рецепт млинців, але в кінці буде продукт знищити все життя на Землі. У світі завжди є можливість відтворити вірус або рефінувати існуючий, щоб зробити його ще більш ефективним, а потім звільнити його у світ. За оцінками, що модифікований птаховий потік може вбити половину населення світу. Таким чином, дослідники з Китаю поєднують птахи і свинячий грипу, створюючи мутантний вірус, що передається повітряно-десантними крапельками. Ідея знаючи противника є хорошою ідеєю, але варто пам'ятати, що мутантні віруси можуть використовуватися як зброя атаки. Крім того, є завжди небезпека, що вірус може зламатися з лабораторій і гавочка.

Віртуальні тюрми та покарання

Що таке тюрма і покарання, коли люди можуть жити на сотні або тисячі років? Фахівці Ethics Rebecca Roach дивляться на наступний сценарій:

«Пригоди радикального збільшення тривалості життя очевидні, але це також може призвести до збільшення тяжкості покарання. Уявіть, що людина може жити протягом 1000 років або більше, то 5-50 років буде непристойним для нього, тому тривалість позбавлення від всіх злочинів підвищиться. Але є проблема, коли правополучаючі громадяни обов’язково сплачувати за 100-500 років позбавлення, і це чудово обґрунтоване. Це, звичайно, вдарить кишеню суспільства. Однак, якщо збільшення тривалості життя було поширено, ці витрати можуть бути зміщені за рахунок збільшення внесків з більш тривалої робочої сили. ?

Але, швидше за все, за допомогою цього часу, будуть способи програмувати діяльність мозку людини. Ми можемо перетворювати 8,5-годинну в’язницю, що перебуває в 1,000-річній праці. Очевидно, що це буде значно дешевшим, ніж подача 1,000-річного вироку в режимі реального часу.

Це добре, але є також етична сторона.

Дизайн Хелл

Це схоже на попередні технології. Деякі футуристи також говорять про використання передової технології, особливо для свідомості завантаження віртуальної реальності безпосередньо в мозок людини. Як добре приїхати після важкої роботи дня, підключити мозок до мережі і бути в небі. Якщо ви можете створити небес, ви можете створити пекл. По суті, це один з найгірших ідей явний. Це ще одна причина, чому ми повинні заборонити розвиток штучного суперінтелекту для страху так званої ери Базиліка Роко.

Роко Базилік - це гондоподібна форма штучного інтелекту, тому небезпечна, що якщо ви просто думаєте про це, ви будете витрачати інші дні в жахливій катування.

А враховуючи те, що сучасні люди звикли до сучасних технологій (наприклад, соціальних мереж), майбутнє людства попарюється з високими технологіями, не здаватися так безхмарно.

Джерело: muz4in.net

Технологічні прориви не просто про переваги, а штучний інтелект може бути прикладом цього. Патрик Лін, директор групи Ethics + Emerging Sciences в Каліфорнійському політехнічному університеті, сказав:

«Технологія притаманна нейтральному. Його безсмертність - міф, який повинен бути розбитий. Кожен творець може перенести його на моральність, навіть якщо він не має одного. У більшості випадків люди не помітили, але деякі сучасні технології народжувалися з шкідливим інтентом. У будь-якому випадку, кожен розуміє, що більшість технологій, створених, можуть використовуватися для хорошого і для шкоди. Якщо шанси звикати до шкоди більше, то це може стати причиною, чому це просто не варто створювати цю технологію. й

Р

РНавушники

Ніщо не може закінчити наше панування на Землі швидше, ніж молекулярна збірна зброя.

Два дуже потужних чинники створюють цю загрозу. Це неконтрольоване саморозвиток і спонтанне поширення такої зброї. Уряд або загальна людина може розробляти мікроскопічні верстати, які споживають кінцеві ресурси нашої планети на швидкості світла і одночасно відтворять себе, створюючи непотрібні продукти, які називають «сірою стрункістю».

Аоріст Роберт Фрейтас, зачарований нанотехнологією, прийшов до висновку, що в нашому світі може бути кілька видів нанавиків: сірий пил, сірий планктон, сірий лишай і так звані біомаси вбивці. Сірий пил не дасть сонячним променям, сірий планктон створить реплікатори підводного світу, що поглинає енергію-багатим підводним світом, сірі лишені знищать наземну рослинність, а біомасові вбивці атакують і знищать всі можливі живі організми.

За словами Фрітаса, найгірший сценарій для людства є сценарієм «глобальної екофагії» (екофагії або сірого слизу – це гіпотетичний сценарій, пов’язаний з успіхом молекулярної нанотехнології) займе близько 20 місяців, що досить створити ефективний захист заздалегідь. Як захист, Freitas посилається на протипоказання, швидше за все, за участю самореплічуючих нанотехнологій, або своєрідної системи, яка б порушить внутрішні механізми наноботів. З іншого боку, ми можемо створити "активні щити" заздалегідь, хоча більшість експертів вважають, що вони будуть без використання.

Складні машини

Ідея, яку ми в кінцевому підсумку доведемо машину з інтелектом вже природною. Але перш за все, ви повинні ретельно подумати перед цим. Створення верстата з функціонуванням мозку всередині (літерально і фігурно), що може імітувати людей і тварин.

Повернувшись у 2003 році, філософ Томас Метзінгер стверджує, що він буде неетичну для розробки програмного забезпечення, яке може постраждати.

Що б ви сказали, що хтось прийшов і сказав: "Ми хочемо, щоб генетично змінити психічно ретаровані немовляти для наукового прогресу по всьому світу". Для вивчення психологічного розвитку післяпартуму потрібні діти з певними когнітивними та емоційними обмеженнями. Ви обов'язково подумайте, що це не просто абсурд, терористична і безсмертна ідея. Я сподіваюсь, що в сучасному світі немає етики. Тим не менш, сьогодні етичний комітет не бачить його як прототип першого верстата, що наданий інтелектом.

Футуристи Луїс Хальм погоджується з цим видом. Ось що сказав мені:

«Одна з найбільших переваг комп’ютерів полягає в тому, що ви можете надати їм мільйони програм і завдань, і вони не будуть нудьгувати їх, оскільки вони будуть з особою, яка буде відхилена такою великою кількістю робіт». Оскільки ми плануємо використовувати штучний інтелект замість людської інтелектуальної праці, я думаю, що це буде безсмертним для навмисно програмувальних машин з свідомістю. ?

Поставляючи свідомість всередині машини і роблячи це зробити роботу для нас дуже раб. Свідомість є дійсно крихким. У людському тілі можна викликати синдром внизу, шизофренія, аутизм або епілепсія. Для того, щоб зрозуміти, що ви спочатку запрограмовані для дисфункції. Це те, як будуть запрограмовані машини.

Наприклад, кілька добре фінансованих AI (Artificial Intelligence) розробники хочуть відтворити людський інтелект в машинах, зміщуючи біологічну структуру мозку людини. Для запобігання розпаду суспільства не варто допускати створення штучного інтелекту з самовідомістю. Не тому, що це не крутий або неможливий, але просто тому, що використання свідомої істоти, навіть робот, по суті, рабство.

Штучна суперінтелігенція

Як Стівен Гокін заявив раніше цього року, «Будівля штучного інтелекту може стати нашою найбільшою помилкою.» Насправді, як ми неодноразово відзначили, поява суперінтелігента може бути катастрофічною для себе. Впровадження систем, які набагато швидше і розумніше, ніж ми змусимо нас крокувати. Ми просто збираємося бути на занурення суперінтелекту — і це не те, що ми зможемо створити штучний інтелект з дружними намірами, тому будувати над AI буде божевільним.

Час подорожі

По суті, час подорожі є найбільш неможливим для всіх технологій. Але якщо це можливо, ми повинні триматися від неї. Небезпечний. Будь-яка плівка про часові інтервали, що зміщуються, обов'язково пропонує потенційні небезпеки такої поїздки. І навіть якщо деякі форми квантових часових поїздок можливі, культурно-технологічні обміни між гетерогенними цивілізаціями можуть бути погані.

Розумні пристрої

Вже в процесі створення машин, які можуть читати думки та спогади людей з далеких відстаней і без згоди. Але це, ймовірно, стане можливим тільки після того, як мозок людини, якось інтегрований в Інтернет або інші засоби зв'язку.

Минулого року, наприклад, вчені в Нідерландах використовували дані з алгоритмів сканування мозку, щоб визначити, які листи шукали людину. Експеримент виявився справжнім проривом, і показав, що вже можна реконструювати людські думки з достатньо високим рівнем деталей, включаючи інформацію про те, що ми бачимо, думають і пам'ятаємо. Такі пристрої, якщо використовуються масивно в будь-якому повнолітарному режимі, зроблять життя нестерпним. Це буде свого роду Орвеллійський світ, де дійсно буде покарання за "сумні злочини".

Р

РПристрої, які "хака" мозку

Ще одна можливість змінити нашу свідомість і без наших знань. Ми можемо самі зателефонувати одержувачу і узгодити зручний час і місце вручення квітів, а якщо необхідно, то збережемо сюрприз.

Неймовірно, ми вже взяли перші кроки до цієї мети. Останнім часом міжнародна команда нейронауковців налаштувала експеримент, який дозволило учасникам спілкуватися в Інтернеті за допомогою чого називається «цифрова телепатія». Звичайно, це чудово, але це цифрова телепатія може відкрити Pandora. Можливо, один можливий сценарій описаний в Ghost в Shell, де хакер був штучним інтелектом, здатним модифікувати спогади і наміри його жертв. Тепер уявіть, чи є зброя в руках організованих злочинів або параноїдних урядів.

р.

р.Автономні аварійні роботи

Ця проблема вже сьогодні. Ось що футурист Майкл Ла Торра сказав:

«Ми ще не маємо машини, яка демонструє загальний рівень інтелекту людини, але не потребує особливого інтелекту. Створення робототехніки всіх видів вже було поставлено на потік. Робо-танки, літаки, кораблі, підводні човни, люди-подібні солдати працюють сьогодні. На відміну від дистанційного керування безпілотним літаком, військові роботи можуть визначити цілі і знищити їх без втручання людини, надати собі остаточне замовлення «багаття». Небезпека таких технологій очевидна, тому що навіть сучасні, солдати-контрольовані роботи помилково загиближували себе, або навіть невинних цивільних, десятки разів.

Великою небезпекою є на міжнародній арені, яка може початися, якщо будь-яка нація поставила такі війська в службу. Після декількох циклів удосконалення такої техніки рівень його може перевершувати всі замкнені і немислимі грані. Автономні роботи зможуть вразити будь-які системи, які контролюються людьми. Після цього, як випадково, так і через шкідливий намір, людство буде в повній подачі на штучний інтелект.

р.

р.Віруси

Ще одна дуже погана ідея. Повернувшись у 2005 році, Рай Курцвіл і Білл Джой зазначив, що видавництво геномів смертельних вірусів, як рецепт млинців, але в кінці буде продукт знищити все життя на Землі. У світі завжди є можливість відтворити вірус або рефінувати існуючий, щоб зробити його ще більш ефективним, а потім звільнити його у світ. За оцінками, що модифікований птаховий потік може вбити половину населення світу. Таким чином, дослідники з Китаю поєднують птахи і свинячий грипу, створюючи мутантний вірус, що передається повітряно-десантними крапельками. Ідея знаючи противника є хорошою ідеєю, але варто пам'ятати, що мутантні віруси можуть використовуватися як зброя атаки. Крім того, є завжди небезпека, що вірус може зламатися з лабораторій і гавочка.

Віртуальні тюрми та покарання

Що таке тюрма і покарання, коли люди можуть жити на сотні або тисячі років? Фахівці Ethics Rebecca Roach дивляться на наступний сценарій:

«Пригоди радикального збільшення тривалості життя очевидні, але це також може призвести до збільшення тяжкості покарання. Уявіть, що людина може жити протягом 1000 років або більше, то 5-50 років буде непристойним для нього, тому тривалість позбавлення від всіх злочинів підвищиться. Але є проблема, коли правополучаючі громадяни обов’язково сплачувати за 100-500 років позбавлення, і це чудово обґрунтоване. Це, звичайно, вдарить кишеню суспільства. Однак, якщо збільшення тривалості життя було поширено, ці витрати можуть бути зміщені за рахунок збільшення внесків з більш тривалої робочої сили. ?

Але, швидше за все, за допомогою цього часу, будуть способи програмувати діяльність мозку людини. Ми можемо перетворювати 8,5-годинну в’язницю, що перебуває в 1,000-річній праці. Очевидно, що це буде значно дешевшим, ніж подача 1,000-річного вироку в режимі реального часу.

Це добре, але є також етична сторона.

Дизайн Хелл

Це схоже на попередні технології. Деякі футуристи також говорять про використання передової технології, особливо для свідомості завантаження віртуальної реальності безпосередньо в мозок людини. Як добре приїхати після важкої роботи дня, підключити мозок до мережі і бути в небі. Якщо ви можете створити небес, ви можете створити пекл. По суті, це один з найгірших ідей явний. Це ще одна причина, чому ми повинні заборонити розвиток штучного суперінтелекту для страху так званої ери Базиліка Роко.

Роко Базилік - це гондоподібна форма штучного інтелекту, тому небезпечна, що якщо ви просто думаєте про це, ви будете витрачати інші дні в жахливій катування.

А враховуючи те, що сучасні люди звикли до сучасних технологій (наприклад, соціальних мереж), майбутнє людства попарюється з високими технологіями, не здаватися так безхмарно.

Джерело: muz4in.net