672

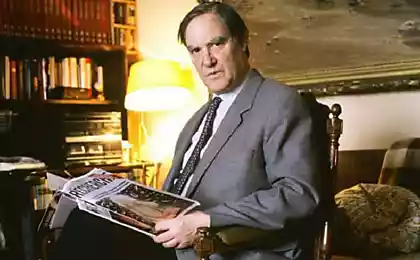

Стівен Гокін: Науково-технічний прогрес може знищити життя на Землі

746109

Ядерна війна, глобальне потепління та генетично модифіковані віруси є деякими сценаріями, що заробляються як причину можливого вимирання людства з Землі. І каже, що досягнення в галузі науки і техніки створять більше і більше загроз, тому кожен рік підвищує ризик.

«Увімкніть загрозу глобальної катастрофи на планеті можна оцінити як порівняно низький за певний рік, ризик збільшить час, роблячи таку катастрофу практично неминучою в наступних тис. або десяти тис. років», - сказав він. За цей час нам доведеться поселитися в космосі, на інших зірок, щоб кінець Землі не ставало кінця людства.

р.

р.

Професор Хокінг провів лекції в рамках проекту BBC Reith Лекція, присвяченого вивченню чорних отворів. Відповіли на запитання аудиторії.

«Ми не в положенні, щоб побудувати автономні колонії в космосі принаймні на наступні 100 років, тому ми повинні бути дуже обережними в цей час», - сказав він.

Головною загрозою для людства є не астероїдний або чорний отвір, але люди самі. «Увімкніть, якщо ви потрапляєте в чорний отвір, ви можете вижити, є вихід», - сказав він. Прогрес швидше за все, щоб знищити нас. Ми не повинні зупинити його, але ми повинні визнати небезпеку науки і контролювати її більш ретельно. й

Цього року Стівен Гоукін попередив загрозу штучного інтелекту, зателефонувавши до неї «найбільша помилка». З можливістю самооцінки AI постійно поліпшить себе, це спровокує процес технологічного співу. Така технологія виведена у людей, які починають керувати фінансовими ринками, науковими дослідженнями, людьми та розвитком зброї за межами нашої компресії.

Джерело: geektimes.ru/post/269456/

Ядерна війна, глобальне потепління та генетично модифіковані віруси є деякими сценаріями, що заробляються як причину можливого вимирання людства з Землі. І каже, що досягнення в галузі науки і техніки створять більше і більше загроз, тому кожен рік підвищує ризик.

«Увімкніть загрозу глобальної катастрофи на планеті можна оцінити як порівняно низький за певний рік, ризик збільшить час, роблячи таку катастрофу практично неминучою в наступних тис. або десяти тис. років», - сказав він. За цей час нам доведеться поселитися в космосі, на інших зірок, щоб кінець Землі не ставало кінця людства.

р.

р.Професор Хокінг провів лекції в рамках проекту BBC Reith Лекція, присвяченого вивченню чорних отворів. Відповіли на запитання аудиторії.

«Ми не в положенні, щоб побудувати автономні колонії в космосі принаймні на наступні 100 років, тому ми повинні бути дуже обережними в цей час», - сказав він.

Головною загрозою для людства є не астероїдний або чорний отвір, але люди самі. «Увімкніть, якщо ви потрапляєте в чорний отвір, ви можете вижити, є вихід», - сказав він. Прогрес швидше за все, щоб знищити нас. Ми не повинні зупинити його, але ми повинні визнати небезпеку науки і контролювати її більш ретельно. й

Цього року Стівен Гоукін попередив загрозу штучного інтелекту, зателефонувавши до неї «найбільша помилка». З можливістю самооцінки AI постійно поліпшить себе, це спровокує процес технологічного співу. Така технологія виведена у людей, які починають керувати фінансовими ринками, науковими дослідженнями, людьми та розвитком зброї за межами нашої компресії.

Джерело: geektimes.ru/post/269456/