571

Стівен Говерлінг: Cheering Doomed, Esley Not Pokenet Land

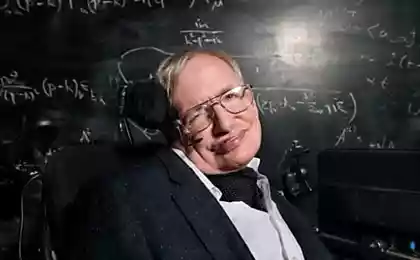

Якщо людство вижити в довгостроковій перспективі, необхідно знайти спосіб залишити планету Земля. Хто знайомий? Цього разу вони звучали з рота відомого астрофізика Стівена Гокінга. Людина може мати менше 200 років, щоб зрозуміти, як втекти з своєї домашньої планети, Hawking сказав в недавньому інтерв'ю з Big Think. В іншому випадку наш вид може бути погрожений від голоду.

«Це буде досить важко уникнути катастрофи в найближчих сто років, нехай тільки наступна тисяча або мільйона років», - сказав він. Ми можемо самі зателефонувати одержувачу. Люди, які застрягають на Землі, мають ризик двох видів катастроф, - сказав він. Ми можемо самі зателефонувати одержувачу і узгодити зручний час. Чи можна витерти обличчя Землі і низку космічних явищ. Астероїдний зв'язок з землею вбити більшість населення і залишити решту планети неприпустимо. Флеш гамма променя супернова біля молочного шляху може бути позбавлений життя на Землі.

Життя на Землі також може бути погрожені позаземними цивілізаціями, оскільки Голандія любить поговорити. Небезпечні відчуження можуть брати на себе планету і свої ресурси для власного використання. Для виживання наших видів буде безпечніше мати резервний план у вигляді інших світів.

«У людини не слід зберігати всі яйця в одному кошику або на одній планеті. Ми сподіваємося, що ми не скидаємо кошик до того, як ми перебираємо навантаження. У той же день запропонували, що людина не в змозі змінити, і які віртуї він покращить, якщо це можливо. Він сказав: «Все, я хотів би виправити агресію людини». Це дав перевагу виживанню печерних днів, щоб отримати більше їжі, території або половинку, з ким протворити, але сьогодні це загрожує знищити нас все.

У листопаді генеральний директор SpaceX та Tesla Елон Муск заявив про те, що шанс чогось небезпечного відбувається в результаті появи машин зі штучним інтелектом може падати в п'ять років. Він раніше сперечався, що розвиток автономних машин мислення є дивним для "розрахування демону". У жовтні Муск розповів про штучний інтелект, як наша «велика загроза виживання». Він сказав, що я думаю, що ми повинні бути дуже обережні з штучним інтелектом. Якщо я здогадав, що наша найбільша загроза виживання буде, це буде його. Ми повинні бути дуже обережними з штучним інтелектом. «Я знаю, що ми не робимо жодних помилок. й

«З штучним інтелектом ми підбиваємо демон. Ви знаєте ці історії, де хлопець з петаграмою і святою водою... Він думав, що він може контролювати демон, але ні. Повернутися до Hawking. «Якість, яку я хотів би поліпшити, емпатія. Ми зберігаємо нас в стані миру і любові. Професор додав, що космічна гонка для людини повинна бути «страховим страхуванням» і слід продовжити.

«Закінчення людини в місяць змінило майбутнє людської гонки, як ми ще не знаємо», - сказав він. На планеті немає проблем, але це дозволило нам поглянути на них з іншого кута, зсередини. «Я вірю, що довгострокове майбутнє людської гонки має бути простором і що це є важливим страхуванням життя для нашого продовження виживання, оскільки це може запобігти вимиранню людства, за допомогою колонізації інших планет». У грудні 2014 року «Захар Беркут» видав чергове попередження про те, що штучний інтелект може записати закінчення людської гонки. «Розвиток повноцінного штучного інтелекту може закінчити людський гонщик.»

У січні група науковців та підприємців, в тому числі Ельона Муска та Стівена Гоукінг підписали відкритий лист, що перспективний для запуску досліджень безпеки AI. Повідомляємо, що без будь-яких гарантій, розвиток смарт-машини може означати темне майбутнє для людства. Видання

Джерело: hi-news.ru