569

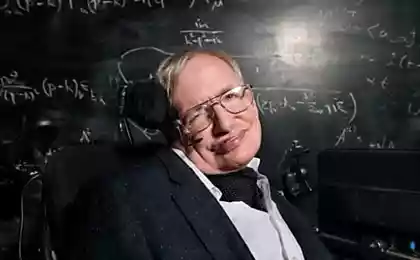

Stephen hawking: la humanidad está condenada, si no salen de la Tierra

Si la humanidad quiere sobrevivir en el largo plazo, tiene que encontrar la manera de abandonar el planeta Tierra. Las conocidas palabras? En esta ocasión, se escucharon de la boca de la famosa astrofísica de stephen hawking. Es posible que las personas quedan menos de 200 años, para averiguar cómo escapar de su planeta de origen, dijo hawking en una entrevista reciente con the Big Think. En caso contrario, nuestra mente puede existir riesgo de extinción.

"Será muy difícil evitar el desastre en los próximos cien años, por no hablar de la próxima mil o un millón de años", dijo hawking. — Nuestra única posibilidad a largo plazo de la supervivencia — no permanecer en el planeta Tierra, y extenderse en el espacio".Las personas que se han quedado en la Tierra, a la espera de riesgo de los dos tipos de catástrofes, considera hawking. El primer tipo podemos crear, por ejemplo, provocando un cambio radical del clima o mediante la creación de armas nucleares o biológicas. Puede borrar de nosotros faz de la Tierra y una serie de fenómenos cósmicos. El asteroide que se enfrenta con la Tierra, matar a la mayor parte de la población, y deja el resto del planeta inhabitable. El brote de rayos gamma, cerca de una supernova en la vía láctea también puede ser destructiva para la vida en la Tierra.

La vida en la Tierra también puede ser bajo la amenaza de civilizaciones extraterrestres, que le gusta hablar hawking. Peligrosos extraños pueden apoderarse del planeta y de sus recursos para su propio uso. Para la supervivencia de nuestra especie sería más seguro para tener un plan alternativo en forma de otros mundos.

"La raza humana no vale la pena guardar todos los huevos en una sola canasta, o en el mismo planeta. Esperemos que no nos уроним la papelera de reciclaje hasta que no перераспределим la carga".El otro día hawking le preguntaron qué los vicios de la gente habría cambiado, y ¿qué virtudes mejoró, si hubiera sido posible. Él respondió: "lo que Más me gustaría reparar en la persona de su agresión. Daba ventaja a la hora de la supervivencia en los días de la cueva de las personas, para obtener más de la comida, el territorio o el socio con el que puede continuar con la raza, pero hoy en día lo amenaza con destruir a todos nosotros".

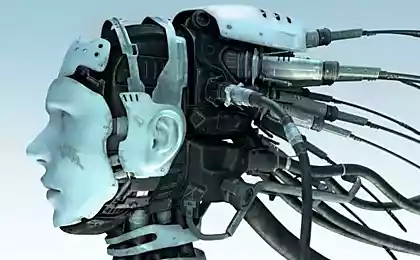

En noviembre de elon Musk, ceo de SpaceX y Tesla, advirtió que la posibilidad de que suceda algo peligroso en el que la aparición de las máquinas con inteligencia artificial, puede disparar en el plazo de cinco años. Anteriormente se afirmaba que el desarrollo de autónomos piensa máquinas similar a "la invocación del demonio". Haciendo uso de la palabra en el simposio AeroAstro Centennial en el mes de octubre, Musk ha descrito la inteligencia artificial como la nuestra "la mayor amenaza para la supervivencia". Entonces dijo: "creo que deberíamos ser muy cuidadosos con la inteligencia artificial. Si yo pudiera suponer cuál será nuestra mayor amenaza para la supervivencia, es él. Debemos ser muy cuidadosos con la inteligencia artificial. Estoy cada vez más y más inclinado a pensar que debe haber algún tipo de regulación, la supervisión, tal vez, a nivel nacional e internacional, simplemente para saber que no estamos haciendo estúpidos errores".

"Con la inteligencia artificial que llamamos demonio. Usted sabe estas historias, en las que el chico con una estrella de cinco puntas y el agua bendita... él pensaba que podía controlar a un demonio, pero no".Volvemos a Хокингу. "La calidad que me gustaría mejorar es la empatía, la compasión. Ella nos mantienen en un estado de paz y de amor". El profesor también añadió que la carrera espacial para que la gente se "seguro de vida" y debe continuar.

Enviar personas a la luna cambió el futuro de la raza humana, por lo tanto, sobre el que aún ni siquiera sospechar, dijo. — Ella no resuelve nuestros problemas existentes en el planeta Tierra, pero nos ha permitido echar un vistazo a ellos desde un ángulo diferente, desde dentro y desde fuera"."Yo creo que a largo plazo el futuro de la raza humana debe ser el espacio, y que representa un importante seguro de vida para nuestra supervivencia, ya que puede impedir la desaparición de la humanidad a través de la colonización de otros planetas".En diciembre de 2014 hawking hizo otra advertencia es que la inteligencia artificial podría significar el fin de la raza humana. Haciendo uso de la palabra en un evento en londres, el físico dijo a la BBC que "el desarrollo pleno de la inteligencia artificial podría poner fin a la raza humana".

En enero, un grupo de científicos y empresarios, incluida elona Máscara y stephen hawking, ha firmado una carta abierta, обещающее de dar comienzo a la investigación de la seguridad de la ia. La carta advierte que sin ningún tipo de garantía para el desarrollo de máquinas inteligentes puede significar un futuro oscuro para la humanidad. publicado

Fuente: hi-news.ru

Como construir una nueva relación después del divorcio

Todo lo que necesita saber acerca de las nueces