559

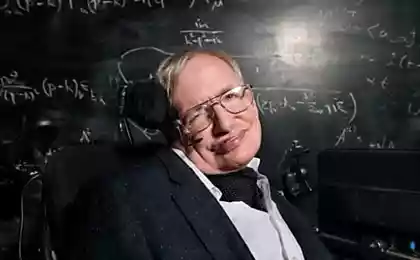

史蒂芬*霍金:人类注定的,如果你不离开地面

如果人类要生存,在长期的,他需要找到一个方法离开地球。 熟悉的话吗? 这一次,他们来自的嘴唇着名的天体物理学家斯蒂芬霍金。 也许该人不到200年的时间要找出如何逃离自己家园的星球,霍金在最近的一次采访中说,与大的想法。 否则,我们的物种可能面临的灭绝。

"这将是难以避免的灾难在未来百年来,更不要说下千万年来,—说霍金。 我们唯一的机会的长期生存是不要留在地球上,但是扩散到空间"。人就死在地上,等待风险的两种类型的灾害,说霍金。 第一类,我们创造,例如,造成一个自由基的气候变化,或者通过创建核或生物武器。 可以消灭我们地球的面貌和数量的宇宙的现象。 小行星与地球相撞,将会杀了大多数的人口和离开该世界其他地区无法居住。 的闪光的伽马射线附近一个超新星在银河系,也可以破坏地球上的生命。

地球上的生命也可能受到威胁的外星文明的,喜欢谈论什么霍金。 危险的外国人可以接管地球及其资源的供自己使用。 为了生存我们人类将是安全的,有一个备份计划的形式,其他的世界。

"人类不应该有你所有的鸡蛋放在一个篮子里或在一个星球。 让我们希望我们不要放弃篮子里直到你重新分配的载荷。"其他天,霍金被问及什么样的缺点他会改变,其优点已经改善,如果这是可能的。 他说,"最重要的是,我想纠正男人的侵略。 它给了一个优势生存的洞穴的人,以获得更多的粮食、领地或与合作伙伴是谁,你可以继续比赛,但今天,它威胁要摧毁我们所有人。"

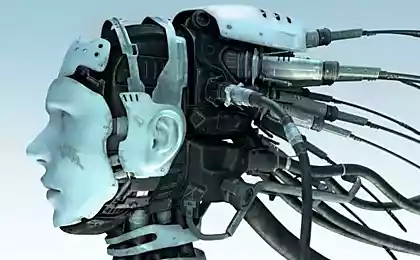

在日,伊隆*马斯克的首席执行官美和拉,警告说,机会是危险的东西会发生的结果,机器的人工智能,可以拍摄在五年。 此前,他认为,发展自治的思考机器像"叫一个魔鬼。" 发言AeroAstro百年纪念专题讨论会在日,麝香描述的人工智能为我们的"最大威胁的生存。" 然后他说,"我认为,我们应当非常小心的人工智能。 如果我不得不猜测,这将是我们的最大威胁的生存,就是他。 我们需要非常小心的人工智能。 我越来越倾向于认为,应该有某种监督管理也许在国家和国际一级,只需要知道,我们不要做愚蠢的错误。"

"人工智能我们呼吁一个恶魔。 你知道这些故事里的那个五角星和圣水...他以为他可以控制的恶魔,但没有。"回到霍金。 "我谨提高是同情、同情。 它让我们在一个国家的和平和爱情。" 教授还补充说,空间竞赛,为男性是"人寿保险",必须继续下去。

"发送人,到月球改变的未来的人类,使我们甚至不怀疑—他说。 —它没有解决我们紧迫的问题在地球上,但是让我们看看他们从不同的角度,内部和外部。""我相信那长期未来的人类必须空间,它代表着一个重要的人寿保险,为我们今后的生存,因为它可能防止失踪的人类通过殖民化的其它行星。"在2014年十二月,霍金给了警告其他人—那个人工智能可能意味着结束人类。 说在事件在伦敦,物理学家告诉英国广播公司,"发展的全的人工智能可以结束人比赛"。

在一月,一群科学家和企业家,包括伊隆*马斯和斯蒂芬*霍金,已经签署一封公开信承诺要发起研究AI安全。 信中警告说,没有任何保证发展的智能机器可能意味着一个黑暗的未来,为人类。 出版

资料来源:hi-news.ru