1152

Sintetizador de voz, conecte directamente en el cerebro

"Grabaciones" de la superficie del cerebro para producir científicos de ideas sin precedentes en la gente cómo paralizados con la ayuda del cerebro para controlarlo.

¿Puede un hombre paralítico que es incapaz de hablar, como el físico Stephen Hawking, utilizado implantes en el cerebro para llevar a cabo una conversación?

Hoy en día es el principal objetivo de constante desarrollo de las universidades de investigación en los EE.UU., que ya es más de cinco años demuestran que los dispositivos de grabación colocados bajo el cráneo humano puede detectar la actividad cerebral asociada con la conversación humana.

Aunque los resultados son preliminares, Edward Chang, un neurocirujano de la Universidad de California en San Francisco, dijo que se está trabajando en la construcción de una interfaz cerebro-ordenador inalámbrico que puede traducir las señales cerebrales directamente en voz audible utilizando el sintetizador de voz.

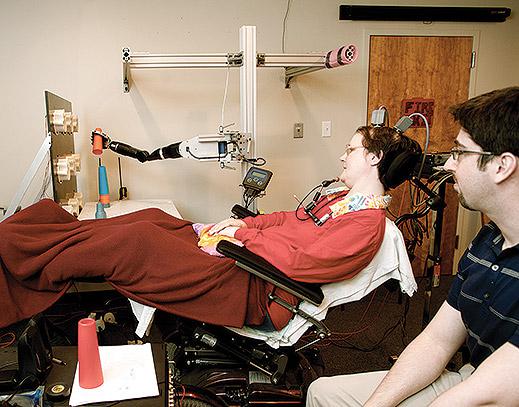

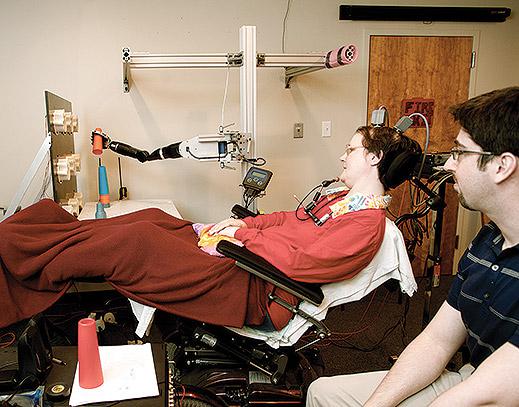

El trabajo en la creación de la prótesis de voz basado en el éxito de los experimentos: personas paralizadas en calidad de voluntarios, los implantes cerebrales utilizados para manipular las extremidades robóticas, por sus pensamientos (ver & quot; мысленный Experimento quot y;). Esta tecnología es viable y funciona porque los científicos son capaces de interpretar la excitación aproximado de neuronas dentro de la corteza motora y relacionarlos con los movimientos de los brazos o las piernas.

Ahora un equipo de Chang trata de repetir lo mismo para la capacidad de una persona para hablar. Esta tarea es mucho más difícil, en parte porque la totalidad del lenguaje humano es único para él, y esta tecnología no puede fácilmente ser probado, por ejemplo, en animales.

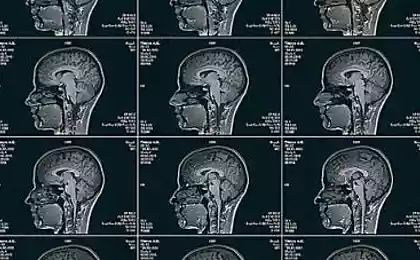

En su Universidad, Chung lleva a cabo experimentos en el habla, en relación con las operaciones en el cerebro, lo que pasa en los pacientes con epilepsia. Los electrodos de placas colocadas bajo el cráneo del paciente, registra la actividad eléctrica de la superficie del cerebro. Los pacientes usan un dispositivo conocido como "array (rejilla) electrocardiografía" "array electrocorticografía", durante unos días, para que los médicos pudieran encontrar la fuente exacta de un ataque epiléptico.

Chang estudiar la actividad cerebral de sus pacientes, ya que pueden hablar. En un artículo en la revista "Nature" el año pasado, él y sus colegas describen cómo utilizaron la matriz de electrodos para mostrar un modelo de la actividad eléctrica en el cerebro llamada la corteza sensoriomotora ventral cuando los pacientes pronunciadas las palabras simples como acaba de sonidos, en la semejanza " bah "(" sin sentido ")," goo "(" slime ") y otros.

La idea es registrar la actividad eléctrica en la corteza motora, que impulsa los labios, la lengua y las cuerdas vocales, cuando una persona está hablando. De acuerdo con cálculos matemáticos equipo Chang mostró que estos datos pueden destacar los "muchos rasgos fonéticos clave."

Uno de los peores efectos de la enfermedad como un lado (lateral), la esclerosis lateral amiotrófica (ELA), así que esto es como la difusión de la parálisis, la gente pierde no sólo la capacidad de moverse, sino también la capacidad de hablar. Algunos pacientes ALS el uso de dispositivos que permiten el uso de la capacidad residual para comunicarse. Si Hawking, utiliza un software que le permite muy lentamente, sílaba por sílaba pronunciar las palabras, cortando los músculos de las mejillas. Otros pacientes utilizan los movimientos oculares de dispositivos de seguimiento ("eye-trackers") para controlar un ratón de ordenador.

La idea de usar interfaz cerebro-ordenador para lograr en términos prácticos se ofrecía anteriormente, una empresa que desde 1980 está probando la tecnología que utiliza un solo electrodo para grabar directamente en el interior del cerebro humano en las personas con el síndrome de "encerrados" (despertar coma). En 2009, la compañía describió el trabajo en el discurso de la decodificación de 25 años de edad, paralítico, que es incapaz de moverse o hablar.

Otro estudio, que este año publicó por Mark Slutsky de la Universidad Northwestern - hizo un intento de descifrar las señales en la corteza motora cuando los pacientes leen en voz alta las palabras que contienen los 39 fonemas de la lengua Inglés (consonantes y vocales que componen el habla) . El comando identifica fonemas con una precisión promedio de 36 por ciento. El estudio utilizó el mismo tipo de electrodos de superficie, que se utilizan Chang.

Slutsky dijo que hasta que esta precisión puede parecer muy bajo, pero se ha logrado con una muestra relativamente pequeña de las palabras habladas en una cantidad limitada de tiempo. "Esperamos que para lograr resultados mucho mejores en la decodificación futuro", dice. Sistema de reconocimiento de voz también puede ayudar a entender lo que la gente está tratando de decir la palabra, dicen los científicos.

Artículo preparado equipo Telebreeze Equipo

Nuestra página de Facebook y Twitter

Fuente: habrahabr.ru/company/telebreeze/blog/230263/

¿Puede un hombre paralítico que es incapaz de hablar, como el físico Stephen Hawking, utilizado implantes en el cerebro para llevar a cabo una conversación?

Hoy en día es el principal objetivo de constante desarrollo de las universidades de investigación en los EE.UU., que ya es más de cinco años demuestran que los dispositivos de grabación colocados bajo el cráneo humano puede detectar la actividad cerebral asociada con la conversación humana.

Aunque los resultados son preliminares, Edward Chang, un neurocirujano de la Universidad de California en San Francisco, dijo que se está trabajando en la construcción de una interfaz cerebro-ordenador inalámbrico que puede traducir las señales cerebrales directamente en voz audible utilizando el sintetizador de voz.

El trabajo en la creación de la prótesis de voz basado en el éxito de los experimentos: personas paralizadas en calidad de voluntarios, los implantes cerebrales utilizados para manipular las extremidades robóticas, por sus pensamientos (ver & quot; мысленный Experimento quot y;). Esta tecnología es viable y funciona porque los científicos son capaces de interpretar la excitación aproximado de neuronas dentro de la corteza motora y relacionarlos con los movimientos de los brazos o las piernas.

Ahora un equipo de Chang trata de repetir lo mismo para la capacidad de una persona para hablar. Esta tarea es mucho más difícil, en parte porque la totalidad del lenguaje humano es único para él, y esta tecnología no puede fácilmente ser probado, por ejemplo, en animales.

En su Universidad, Chung lleva a cabo experimentos en el habla, en relación con las operaciones en el cerebro, lo que pasa en los pacientes con epilepsia. Los electrodos de placas colocadas bajo el cráneo del paciente, registra la actividad eléctrica de la superficie del cerebro. Los pacientes usan un dispositivo conocido como "array (rejilla) electrocardiografía" "array electrocorticografía", durante unos días, para que los médicos pudieran encontrar la fuente exacta de un ataque epiléptico.

Chang estudiar la actividad cerebral de sus pacientes, ya que pueden hablar. En un artículo en la revista "Nature" el año pasado, él y sus colegas describen cómo utilizaron la matriz de electrodos para mostrar un modelo de la actividad eléctrica en el cerebro llamada la corteza sensoriomotora ventral cuando los pacientes pronunciadas las palabras simples como acaba de sonidos, en la semejanza " bah "(" sin sentido ")," goo "(" slime ") y otros.

La idea es registrar la actividad eléctrica en la corteza motora, que impulsa los labios, la lengua y las cuerdas vocales, cuando una persona está hablando. De acuerdo con cálculos matemáticos equipo Chang mostró que estos datos pueden destacar los "muchos rasgos fonéticos clave."

Uno de los peores efectos de la enfermedad como un lado (lateral), la esclerosis lateral amiotrófica (ELA), así que esto es como la difusión de la parálisis, la gente pierde no sólo la capacidad de moverse, sino también la capacidad de hablar. Algunos pacientes ALS el uso de dispositivos que permiten el uso de la capacidad residual para comunicarse. Si Hawking, utiliza un software que le permite muy lentamente, sílaba por sílaba pronunciar las palabras, cortando los músculos de las mejillas. Otros pacientes utilizan los movimientos oculares de dispositivos de seguimiento ("eye-trackers") para controlar un ratón de ordenador.

La idea de usar interfaz cerebro-ordenador para lograr en términos prácticos se ofrecía anteriormente, una empresa que desde 1980 está probando la tecnología que utiliza un solo electrodo para grabar directamente en el interior del cerebro humano en las personas con el síndrome de "encerrados" (despertar coma). En 2009, la compañía describió el trabajo en el discurso de la decodificación de 25 años de edad, paralítico, que es incapaz de moverse o hablar.

Otro estudio, que este año publicó por Mark Slutsky de la Universidad Northwestern - hizo un intento de descifrar las señales en la corteza motora cuando los pacientes leen en voz alta las palabras que contienen los 39 fonemas de la lengua Inglés (consonantes y vocales que componen el habla) . El comando identifica fonemas con una precisión promedio de 36 por ciento. El estudio utilizó el mismo tipo de electrodos de superficie, que se utilizan Chang.

Slutsky dijo que hasta que esta precisión puede parecer muy bajo, pero se ha logrado con una muestra relativamente pequeña de las palabras habladas en una cantidad limitada de tiempo. "Esperamos que para lograr resultados mucho mejores en la decodificación futuro", dice. Sistema de reconocimiento de voz también puede ayudar a entender lo que la gente está tratando de decir la palabra, dicen los científicos.

Artículo preparado equipo Telebreeze Equipo

Nuestra página de Facebook y Twitter

Fuente: habrahabr.ru/company/telebreeze/blog/230263/