593

Стуарт Руссел на штучному інтелекті

У січні британсько-американський комп’ютерний вчений Stuart Russell став першим для того, щоб підписати відкриті листи, які ведуть дослідники, щоб глибше думати про їх квест, щоб зробити штучний інтелект більш потужним і потужним. «Ми рекомендуємо більше досліджень для забезпечення надійності та доброї праці AI-систем із збільшенням потужності», - сказав лист. Наші системи штучного інтелекту повинні зробити те, що ми хочемо, щоб зробити.

Підписано лист, в тому числі провідних дослідників штучного інтелекту з Google, Facebook, Microsoft та інших промислових центрів, а також провідних комп'ютерних науковців, фізиків та філософів по всьому світу. До кінця березня близько 300 науково-дослідних груп почали проводити нові дослідження на тему «збереження доброчесності штучного інтелекту» з фондами від 37 знаків листа, винахідника Елона Муска.

Руссел, 53, професор комп’ютерної науки та засновник Центру інтелектуальних систем в Університеті Каліфорнія, Берклі, і довгий вивчав потужність та небезпеку машин мислення. Автор понад 200 статей та стандартного підручника в галузі штучного інтелекту: сучасний підхід (за співавтором з Peter Norwig). Проте, стрімкі досягнення в AI давали старим зверненням Руссела значною мірою.

Нещодавно він каже, що штучний інтелект зробив великі паси, завдяки чому в складі алгоритмів нейронного навчання. Ми використовуємо програмне забезпечення для розпізнавання обличчя Facebook, індивідуальні помічники смартфонів та самохідні автомобілі Google. Не так давно мережа штучних нейронів, які навчилися грати в відеоігри Atari краще, ніж людина в декількох годин, приймаючи в основу тільки дані, представлені на екрані, і мета - забити максимальні точки - не запрограмовані знання про відчуження, кулі, право, ліворуч, низ, верх.

"Якщо ваш новонароджений малюк зробив це, ви думаєте, що він був, - говорить Руссел.

Журнал Quanta інтерв'ю Руссел під час сніданку в березні 2015 року зустріч Американського фізичного товариства в Санті Антоніо, Техас, день до того, як він був пов'язаний з тим, щоб говорити про майбутнє штучного інтелекту. У цьому оброблюваному та парохічному варіанті інтерв’ю Рассел відобразив на характері інтелекту і швидке наближення проблем, пов’язаних з безпекою машин.

Ви думаєте, що мета вашого поля полягає у розробці штучного інтелекту, який «прогноз вирівнює» з людськими значеннями. Що означає?

Це свідомо провокативна заява, адже поєднання двох речей – «пророванне» і «людські цінності» – це сама суперечлива. Цінності людини цілком можуть залишатися таємницею назавжди. Але лише ці значення розкриваються в нашій поведінки, ви можете сподіватися, що машина може «прийняти» більшість з них. У кутах, що машина не знає або в якій ми не можемо знайти консенсусусу. Але до тих пір, поки машина відповідає вимогам, можна показати, що це нешкідливий.

Як ви будете робити це?

Так що питання я працюю прямо зараз: в якому місці машина отримає найбільш схожі значення для того, що людина потребує? Я думаю, що одна відповідь може бути техніка, яка називається "перевершеним навчанням з закріпленням". Регулярне навчання армування - це процес, де ви отримуєте винагороди і покарання, і ваша мета - довести процес до максимальної кількості винагород. Це те, що система DQN (playing Atari), вона отримує ігровий рахунок, і його мета полягає в тому, щоб зробити цей рахунок вище. Зворотне навчання з армуванням є іншим способом. Ви бачите певну поведінку і спробувати зрозуміти, який рахунок, яка поведінка намагається збільшити. Наприклад, ваш домашній робот бачить, що ви скупчуєте з ліжка вранці, щоб викинути дивний коричневий коло в шумний автомобіль, виконувати складну операцію з паровою і гарячою водою, молоком і цукром, а потім виглядати щасливо. Система визначає, що частина важливого значення для людини стає каву вранці.

Книги, фільми та інтернет містять велику інформацію про людські дії та ставлення до дії. Це неймовірна база даних для машин, які вивчають цінності людей - які отримують медалі, які переходять на в’язницю і чому.

Як ви потрапили в поле штучного інтелекту?

Коли я був у школі, АІ не розглядався академічною дисципліною і великим. Але я був на пансіонатській школі в Лондоні і мав можливість не відвідувати обов'язкове регбі, а також робити комп'ютерну науку в найближчому коледжі. Однією з моїх проектів стала програма, яка навчається грати в tic-toe. Я втратив всю популярність, тому що я сидів на комп'ютері коледжу до кінця. Наступного року я написав шахову програму і отримав дозвіл від професора Імперського коледжу, щоб використовувати свій гігантський головний кадр. Неймовірно намагається розібратися, як навчити його грати в шахи.

Але це все просто хобі; мій академічний інтерес у час був фізикою. Вивчав фізику в Оксфорді. А потім, коли я пішов до аспірантури, я пішов на теоретичну фізику в Оксфорді та Кембриджі та комп'ютерну науку в Університеті Массачусетського та Станфорда, не розуміючи, що я пропустив термін, щоб застосувати до Сполучених Штатів. Луккили, Станфорд не дала шкоди, тому я отримав в неї.

Ви витратили багато часу в кар'єрі, намагаючись зрозуміти, який інтелект є необхідною умовою, яка машини може зрозуміти і досягти. Що ви дізналися?

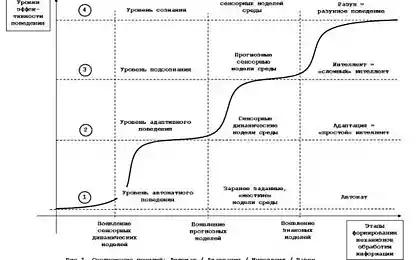

Під час дослідження дисертації в «80-ті роки я почав думати про раціональне прийняття рішень і проблеми практичної неможливості її. Якщо ви були раціональні, ви думаєте, Ось мій поточний стан, ось дії, які я можу зробити, то я можу це зробити, то це; який шлях гарантовано привести мене до мети? Визначення раціональної поведінки вимагає оптимізації всього майбутнього Всесвіту. Це не можливо в умовах обчислення.

Чи не існує сенсу намагатися обрамити неможливим в AI, тому я думав про щось інше: як ми дійсно робимо рішення?

Що це?

Один трюк, щоб думати в короткостроковому терміні, а потім вгадати, що майбутнє може виглядати так. Шахові програми, наприклад, якщо вони були раціональні, вони б грали тільки переміщення, які гарантують mate, але вони не можуть. Натомість вони розраховують десятки переїздів вперед і приймають припущення щодо того, наскільки корисними ці найближчі стани є, а потім приймають рішення, які призводять до одного з кращих держав.

, Україна

, УкраїнаІншим є проблема прийняття рішень на декількох рівнях абстракції, ієрархічного прийняття рішень. Люди здійснюють 20 трійчастих фізичних дій у їх житті. У цій конференції взяли участь 1,3 мільярди дій або так, щоб приїхати до цієї конференції і сказати щось. Якщо ви були раціональні, ви спробуєте розрахувати всі 1,3 мільярди кроків, які дійсно неможливо. Люди роблять це завдяки величезній кількості високорівневих абстрактних дій. Ви не думаєте, «Коли я їду додому, я кладаю ліву ногу або праву ногу на маті, а потім я можу це зробити і це». Ви думаєте, "Я буду йти в магазин і купити книгу." Зателефонуйте таксі пізніше. Це його. Вам не доведеться думати про це, поки не потрібно уточнювати складні деталі. Ось як ми живемо, в принципі. Майбутнє розмите, багато деталей близькі до нас в часі, але в основному представлені великі шматки, такі як «Овочевий ступінь», «Діти дітей».

Чи здатні комп’ютери ієрархічних рішень?

Це один з відсутніх частин головоломки зараз: де всі ці високі дії приходять з? Ми не думаємо, що програми, такі як DQN, мають абстрактні уявлення про дії. Є багато ігор, які DQN просто не розуміють, і ці ігри є складними, які вимагають багатьох, багато кроків, розрахованих заздалегідь, у вигляді примітивних відхилень дії - роду, як коли людина думає «що потрібно відкрити двері?» і відкриття дверей передбачає вилучення ключа і так далі. Якщо у машині немає такої ідеї «відкрити двері», це не може нічого робити.

Але якщо ця проблема вирішується, що цілком можливо, то ми розглянемо ще одне суттєве збільшення можливостей машин. У нас є два або три проблеми, і якщо ви вирішуєте їх все, то я не знаю, якщо буде будь-які основні перешкоди для штучного інтелекту людини.

Що турбується про можливість штучного інтелекту людини?

Перша редакція книги (1994) має розділ «Що робити? Тому що я думав, що люди не думають про це. Може бути, здається, занадто далеко, занадто далеко. Але, очевидно, успіх буде гігантською подією. «Найбільший захід в історії людини», ймовірно, як ви його описуєте. І якщо це справа, то нам потрібно ретельно продумати про те, що ми робимо, щоб підкорити форму цього можливого заходу.

Основна ідея вибуху інтелекту полягає в тому, що один раз машини досягають певного рівня інтелекту, вони зможуть працювати на AI так само, як ми робимо, і покращувати власні характеристики — запрограмувати себе і змінити начинку — і їх інтелект зросте на годину. За останні кілька років громада поступово захопила свої аргументи, тому це може стати проблемою. Найбільш переконливий аргумент може бути рівнянням значення: ви будуєте систему, яка надзвичайно добре при оптимізації корисних функцій, але дуже поняття утиліти залишається в питанні. Оксфордський філософ Нік Бостром дає приклад паперового кліпу. Ви скажете «зробити кілька паперових кліпів», і вся планета виходить склад паперових кліпів. Ви будуєте супероптимізатор, але корисну функцію, яку ви можете винагородити, може добре стати непотрібним.

Що про відмінності в людських значеннях?

Це внутрішня проблема. Ви можете сказати, що машини повинні приходити на бокові лінії і робити нічого в місцях, де може бути конфлікт значень. І це завдання. Я думаю, що ми повинні створити в системі значення. Якщо ви хочете зробити домашній робот, вона повинна бути добре в порівнянні з людськими значеннями; в іншому випадку вона буде робити пристойні речі, поставивши кота в духовці, так як немає їжі в холодильнику і дітей голодні. Реальне життя сповнене таких компромісів. Якщо машинка робить це своєрідним компромісом, і вона виходить, це не розуміє щось - що це зрозуміло для людей - ви не хочете, щоб автомобіль, як будинок.

Я не бачу будь-який реальний спосіб створення свого роду індустрії цін. І я думаю, що це величезний економічний стимул, щоб створити його. Домашній робот буде робити один або два речі неправильно — як випікати кота в духовці — і люди миттєво втратить довіру.

Виникає питання, якщо ми навчимо інтелектуальних систем, щоб правильно поводитися, так як ми переїжджаємо на більш інтелектуальні системи, це означає, що ми отримаємо кращу систему цін, очищаємо від припливних моментів, або ж виберемо машини? Я не маю відповіді на це питання.

Ви стверджуєте, що ми повинні математично перевірити поведінку AI за всіма можливими обставинами. Як це працює?

Одна з труднощів люди вказують на те, що система може довільно виробляти нову версію себе, яка має різні цілі. Це один з сценаріїв, які наукові письменники розповідають про весь час: що якось машина спонтанно прагне знищити людський гонщик. Ви можете довести, що ваші системи ніколи не будуть, незалежно від того, як смарт, переписати оригінальні цілі людини?

Це буде відносно легко довести, що система DQN, один раз письмовий, ніколи не може змінити його призначення або оптимізувати його. Але уявіть когось з дротами на голові, що фактично сходження на консоль Atari і фізично змінюючи те, що заробляє точки на екрані. DQN не може зробити це ще тому, що це в грі сам і не має маніпулятора. Але якщо машина була функціонувати в реальному світі, що буде серйозною проблемою. Отже, ви можете довести, що ваша система розроблена таким чином, що вона ніколи не може змінити механізм, підключений до набору точок, навіть якщо вона хоче? Це важко довести.

Чи існують будь-які перспективні досягнення в цьому відношенні?

З’являються системи, що приносять комп’ютери в реальний світ. З кіберфізичною системою ви отримуєте пакет біт, що представляють програму управління повітряним рухом, потім реальні літаки і переконайтеся, що літаки не співпадають. Ви намагаєтеся довести теорему про поєднання біт і фізичного світу. Ви повинні написати досить консервативний математичний опис фізичного світу — літаки прискорюють це і так — і ваші теореми повинні залишатися вірними в реальному світі, поки реальний світ знаходиться в такому конверті поведінки.

Ви сказали, що це може бути математично неможливим для формального тестування системи AI?

У багатьох питаннях, які ви можете попросити про комп’ютерні програми. Алан Турінг показав, що не комп'ютерна програма може вирішити, коли ще одна можлива програма дасть відповідь і коли вона буде застрягти в нескінченну петлю. Таким чином, якщо ви починаєте з однієї програми, і вона може переписати себе і стати іншою програмою, ви маєте проблему, адже ви не можете довести, що всі інші програми будуть відповідати певним критеріям. Тож варто хвилюватися про неприпустимість AI-систем, які перезаписати себе? Вони перепропонують себе в новій програмі, що базується на існуючій програмі, а також досвід, які отримують від реального світу. Які наслідки тісної взаємодії програм з реальним світом? Ми ще не знаємо. Опубліковано.

P.S. І пам'ятайте, що просто змініть наше споживання – разом ми змінюємо світ!

Джерело: hi-news.ru