622

情况可能导致的人工智能的发展

神经学家和哲学家山姆*哈里斯介绍情况,虽然看起来可怕,但是它可以发生在我们作为一个物种。 事实上,这是非常难以想象的人工智能(AI)将摧毁我们,但仍有人试图将未来的成本和可以预见的进一步的可能方式发展人类。 这就是我们应该想想以前在这个问题上考虑大赦国际的。

你会选择什么人工智能的时候,他站之前的选择吗?

其中一个主要问题所面临的人的发展是如何获得的计算系统而不只是作出明智的决定,但也有情绪化。 因为AI可以很容易地选择杀死所有的人,为了节省其他的物种。 这个,如果你是被攻击的暴徒拿着一把刀,你拉你的枪。 在那一刻,而不是保护主,您忠实的小狗会攻击你只是因为你在手中更危险的武器...

而且会发生什么,如果大门是一样的吗? 门后面的号码一个... 给出如何有价值的是智慧,会发生什么,如果他们开始工作AI? 有什么可以遵循吗? 全面规模核战争? 一个全球性的流行病? 贾斯汀将会成为美国总统? 事实上,大赦国际就可以摧毁文明的形式,我们知道这一点。 今天,许多人说多少和如何社会迅速下降。 会发生什么,如果你仔细想想,AI会决定,这将更容易摧毁人类的,不是继续的技术发展,这只恶化的情况?

什么号门后面是两个?

唯一的选择是,我们年复一年继续改善我们的智能机器。 在某些时候,我们将建立的机器都比我们聪明,一旦我们有机器都比我们更聪明,他们开始改善自己。 然后我们就可能创造一个"智能爆炸",并认为这个过程可以摧毁我们所有人。 问题是,什么是我们要建立机,更主管比我们,丝毫的差异,他们的目标和我们自己可以带领我们到破坏作为一个物种。

昆虫的二十一世纪 ,只是想想我们如何对待蚂蚁。 我们不恨他们。 我们出去我们的方式伤害他们。 我们正在步行穿过这些小小的困难的工人没有注意到他们,但只要他们的存在严重干扰了我们的目标之一,也就是说,在施工的建筑,我们摧毁他们没有丝毫感到遗憾。 我们正在谈论什么我们一天建造的机器,无论它们是否意识到或不,你可以开始对我们像蚂蚁。

深思想,深刻的影响 智力的结果是一个过程的信息处理在物理系统。 我们已经创建了一个狭窄的情报,为我们的机器和它们中的许多执行某些职能的水平或甚至更好的人。 情报源的所有我们的价值,或武器,我们用它来保护所有我们的价值。 这是我们最宝贵的资源。 我们有问题,我们必须解决的问题。 我们想要结束艾滋病、糖尿病和癌症。 我们想要建立一个真正工作的经济体系。 我们希望改善地球的气候了。 你会做什么,艾,如果他根本没有这种东西深深的思想?

我们在哪里?

人类尚未达到峰值的情报。 这是非常重要的是要理解。 这是什么使得我们的情况很不稳定,而使我们能失去的。 在大多数情况下,潜在的人类的智慧远超过我们当前的想象。 如果我们建立的机器都比我们更聪明吗? 他们将能够更好地计算出的未来和更好地界定的地方,在那里他们要选择的方向进一步的运动。

速度的智能 想象,人类已经建立超级智能AI这是不是聪明得多的平均小组的科学家。 唯一的区别是,他的电子电路的运作大约一万倍的速度比我们的生化的。 因此,汽车"认为,"大约一万倍的意识,建造它。 因此,离开AI工作周期间,我们将发现,他已经执行了20,000年的知识产权工作的人等同。 我们要做什么有这个的处理速度? 减慢速度AI人的水平?

最好的情况下 实际上,你和我是最关注的事件将如何发展一个理想的环境。 想象一下,我们的思想和建造一个超级智能AI,没有任何问题与安全。 这是因为如果我们创造了一个Oracle的行为完全为目的。 我们得到什么? 事实上,我们将创造出完美的节省劳力的设备。 所以我们谈论的是结束无聊的人的存在。 类的! 你也可以说,建立这样的机会是终结的所有知识产权的工作。 它可能看起来,它是好的,但问问你自己什么会发生在这种情况下? 即使是现在,有轻微发展AI,我们看到的增长收入不平等和失业,这是我们从来没有见过。 我们都不愿意分享自己的财富与别人,可能是世界上统治的几trillionerov,而其余的人类将完全取决于他们,而是从将会受到他们AI,将作sverginare不放过任何人。

下一个军备竞赛

想象一下,在世界上每一个国家有一个AI,计算出理想的情况胜利,在全球战争。 不管什么它是一个战争地面、空中或甚至网络战,获胜剧本会得到所有人。 事实上,大赦国际将为每个超级大国,该战略的胜利,最终导致结束人类,因为这将是一场战争的人工智能的危害人类罪。

"不要担心,并没有垃圾邮件你漂亮的小脑袋有关这些愚蠢的问题..."

事实上,大赦国际将建立一个社区纳西索-rastamanov的。 不用担心,很快乐。 那是什么隐晦的说AI我们的生活更容易的今天。 今天,我们觉得大赦国际在其胚胎形成使我们笨,会发生什么事在50年或100年中,我们承诺将艾超过了人类的智慧。 如果情报问题的信息处理,并且我们继续改善我们的机器,你不认为我们已经创建了一个超级智能吗? 我们已经注意到的是不安全的,例如大赦国际在浏览器,这会导致人们进入车道和跳上车停在湖。 和我说的是事实,我们只有50岁以满足面临的主要敌人的人超级智能。

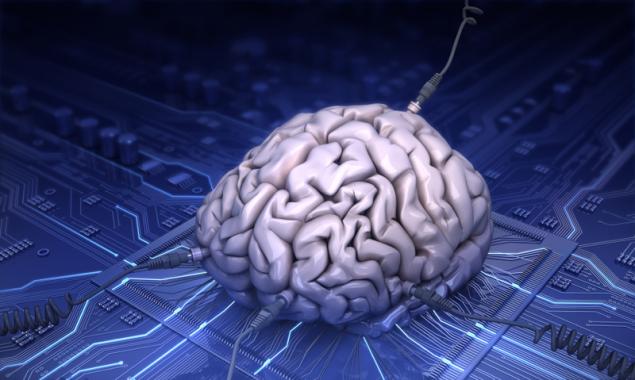

技术,直接进入大脑

汽车在未来可以不分享我们的价值观,因为他们是从字面上的扩展我们自己。 他们将被缝到我们的大脑和我们的,事实上,成为他们的脑边缘系统。 想想你有什么东西放在脑中,就可以读取和处理它根据以一个未知的算法。 有时候你不信任你的大脑,然后芯片。 但是,随着超级智能AI,嵌入芯片在他的大脑,将是最安全的和合理的方式向前迈进。 但是数据安全问题,我们就可以解决不了即使是今天,让你想知道什么都是错误的。

我们需要考虑这些方案和行动 人类已经没有解决的问题,大赦国际,我们可以提供,只是建议。 人们应当最初建立AI的原则基础上的"不伤害人类。" 当你谈论一个超级智能AI,可以修改自己,它似乎是为了进行它的建立,我们作为一个物种,需要解决我们所有的内部问题,否则,我们将注定要失败。 我们必须认识到,我们正在成为一种神。 想象一下,你生活在凝视上帝,你身体上感觉到和什么要去忏悔你没有教堂,以及到移动设备。 出版

P.S.并记住,只要改变你的想法—我们一起改变世界了。 ©

资料来源:muz4in.net/news/kak_vygody_kotorye_my_poluchim_ot_sozdanija_iskusstvennogo_intellekta_mogut_v_konechnom_schete_unichtozhit_nas/2016-10-11-42148

你会选择什么人工智能的时候,他站之前的选择吗?

其中一个主要问题所面临的人的发展是如何获得的计算系统而不只是作出明智的决定,但也有情绪化。 因为AI可以很容易地选择杀死所有的人,为了节省其他的物种。 这个,如果你是被攻击的暴徒拿着一把刀,你拉你的枪。 在那一刻,而不是保护主,您忠实的小狗会攻击你只是因为你在手中更危险的武器...

而且会发生什么,如果大门是一样的吗? 门后面的号码一个... 给出如何有价值的是智慧,会发生什么,如果他们开始工作AI? 有什么可以遵循吗? 全面规模核战争? 一个全球性的流行病? 贾斯汀将会成为美国总统? 事实上,大赦国际就可以摧毁文明的形式,我们知道这一点。 今天,许多人说多少和如何社会迅速下降。 会发生什么,如果你仔细想想,AI会决定,这将更容易摧毁人类的,不是继续的技术发展,这只恶化的情况?

什么号门后面是两个?

唯一的选择是,我们年复一年继续改善我们的智能机器。 在某些时候,我们将建立的机器都比我们聪明,一旦我们有机器都比我们更聪明,他们开始改善自己。 然后我们就可能创造一个"智能爆炸",并认为这个过程可以摧毁我们所有人。 问题是,什么是我们要建立机,更主管比我们,丝毫的差异,他们的目标和我们自己可以带领我们到破坏作为一个物种。

昆虫的二十一世纪 ,只是想想我们如何对待蚂蚁。 我们不恨他们。 我们出去我们的方式伤害他们。 我们正在步行穿过这些小小的困难的工人没有注意到他们,但只要他们的存在严重干扰了我们的目标之一,也就是说,在施工的建筑,我们摧毁他们没有丝毫感到遗憾。 我们正在谈论什么我们一天建造的机器,无论它们是否意识到或不,你可以开始对我们像蚂蚁。

深思想,深刻的影响 智力的结果是一个过程的信息处理在物理系统。 我们已经创建了一个狭窄的情报,为我们的机器和它们中的许多执行某些职能的水平或甚至更好的人。 情报源的所有我们的价值,或武器,我们用它来保护所有我们的价值。 这是我们最宝贵的资源。 我们有问题,我们必须解决的问题。 我们想要结束艾滋病、糖尿病和癌症。 我们想要建立一个真正工作的经济体系。 我们希望改善地球的气候了。 你会做什么,艾,如果他根本没有这种东西深深的思想?

我们在哪里?

人类尚未达到峰值的情报。 这是非常重要的是要理解。 这是什么使得我们的情况很不稳定,而使我们能失去的。 在大多数情况下,潜在的人类的智慧远超过我们当前的想象。 如果我们建立的机器都比我们更聪明吗? 他们将能够更好地计算出的未来和更好地界定的地方,在那里他们要选择的方向进一步的运动。

速度的智能 想象,人类已经建立超级智能AI这是不是聪明得多的平均小组的科学家。 唯一的区别是,他的电子电路的运作大约一万倍的速度比我们的生化的。 因此,汽车"认为,"大约一万倍的意识,建造它。 因此,离开AI工作周期间,我们将发现,他已经执行了20,000年的知识产权工作的人等同。 我们要做什么有这个的处理速度? 减慢速度AI人的水平?

最好的情况下 实际上,你和我是最关注的事件将如何发展一个理想的环境。 想象一下,我们的思想和建造一个超级智能AI,没有任何问题与安全。 这是因为如果我们创造了一个Oracle的行为完全为目的。 我们得到什么? 事实上,我们将创造出完美的节省劳力的设备。 所以我们谈论的是结束无聊的人的存在。 类的! 你也可以说,建立这样的机会是终结的所有知识产权的工作。 它可能看起来,它是好的,但问问你自己什么会发生在这种情况下? 即使是现在,有轻微发展AI,我们看到的增长收入不平等和失业,这是我们从来没有见过。 我们都不愿意分享自己的财富与别人,可能是世界上统治的几trillionerov,而其余的人类将完全取决于他们,而是从将会受到他们AI,将作sverginare不放过任何人。

下一个军备竞赛

想象一下,在世界上每一个国家有一个AI,计算出理想的情况胜利,在全球战争。 不管什么它是一个战争地面、空中或甚至网络战,获胜剧本会得到所有人。 事实上,大赦国际将为每个超级大国,该战略的胜利,最终导致结束人类,因为这将是一场战争的人工智能的危害人类罪。

"不要担心,并没有垃圾邮件你漂亮的小脑袋有关这些愚蠢的问题..."

事实上,大赦国际将建立一个社区纳西索-rastamanov的。 不用担心,很快乐。 那是什么隐晦的说AI我们的生活更容易的今天。 今天,我们觉得大赦国际在其胚胎形成使我们笨,会发生什么事在50年或100年中,我们承诺将艾超过了人类的智慧。 如果情报问题的信息处理,并且我们继续改善我们的机器,你不认为我们已经创建了一个超级智能吗? 我们已经注意到的是不安全的,例如大赦国际在浏览器,这会导致人们进入车道和跳上车停在湖。 和我说的是事实,我们只有50岁以满足面临的主要敌人的人超级智能。

技术,直接进入大脑

汽车在未来可以不分享我们的价值观,因为他们是从字面上的扩展我们自己。 他们将被缝到我们的大脑和我们的,事实上,成为他们的脑边缘系统。 想想你有什么东西放在脑中,就可以读取和处理它根据以一个未知的算法。 有时候你不信任你的大脑,然后芯片。 但是,随着超级智能AI,嵌入芯片在他的大脑,将是最安全的和合理的方式向前迈进。 但是数据安全问题,我们就可以解决不了即使是今天,让你想知道什么都是错误的。

我们需要考虑这些方案和行动 人类已经没有解决的问题,大赦国际,我们可以提供,只是建议。 人们应当最初建立AI的原则基础上的"不伤害人类。" 当你谈论一个超级智能AI,可以修改自己,它似乎是为了进行它的建立,我们作为一个物种,需要解决我们所有的内部问题,否则,我们将注定要失败。 我们必须认识到,我们正在成为一种神。 想象一下,你生活在凝视上帝,你身体上感觉到和什么要去忏悔你没有教堂,以及到移动设备。 出版

P.S.并记住,只要改变你的想法—我们一起改变世界了。 ©

资料来源:muz4in.net/news/kak_vygody_kotorye_my_poluchim_ot_sozdanija_iskusstvennogo_intellekta_mogut_v_konechnom_schete_unichtozhit_nas/2016-10-11-42148