502

埃利泽Yudkowsky:人vs的人工智能的—谁会赢?

想象一下的令人难以置信的聪明人造超级智能锁定在一个虚拟的世界--例如,就在箱子里。 你不知道,他会生气的,友好的或中性的。 你知道的就是他想出来的木制品,可以与它进行交互通过的案文接口。 如果AI是超级智能真的,如果你能跟他谈五个小时,而不要屈服于他的说服力,并操纵—不要打开盒子吗?

这个想法的实验建议,埃利泽Yudkowski,研究员在研究所的机械工程(哥). 在哥是一个很大的科学家正在研究风险的发展的人造超级智能,虽然他甚至不是天生的,它已经吸引了注意力和煽动的辩论。

Yudkowsky索赔人为超级智能可以说的一切,他可以说服你:仔细推理,威胁、欺骗、建立融洽的关系,下意识的建议,等等。 在光速的速度AI建立的故事,探测的弱点,并确定如何最容易说服你. 该词的理论家的生死存亡的威胁,尼克*博斯特伦,"我们应该认为,有超级智能将能够实现所投入的目标。"

实验与艾框引起了怀疑我们有能力控制,我们可以创建。 它还使我们理解而不是离奇的可能性,我们不知道有关我们自己的现实。

仿品可能是完美的滋生地的人工智能。 一些最合理的方式建立一个强大的艾包括模拟世界通过引入限制在人为的模拟世界和选择所需的特质,科学家可以尝试大致重复其自己的发展模式和发现的人类的感觉。 形成AI在模拟环境中也可以防止其"渗漏"在世界各地,只要他的意图和受威胁程度,将变得更加明显。

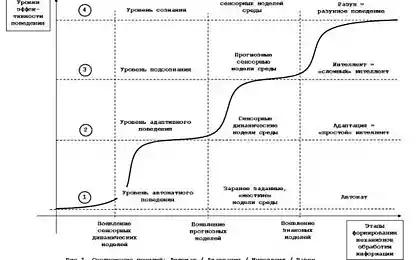

最新的成就暗示它可能是不可能难以发展的知识,从头开始。 没有一个将能够建立思想的人类规模,编写一行代码。 还有其他有希望的方法,当然,增长计算能力可以发展一个进程,最终将创造一个人工智能、智能和能够作为一个男人。

将你释放AI或敢于注定要无穷无尽的折磨?一个想法是"新的"大赦国际的扫描、绘图和模拟的虚拟模型的人类的大脑。 人的大脑中包含数十亿和数万亿的神经元之间的连接这些神经元。 如果我们模拟出一个虚拟的人的结构完整的神经元及其连接,它是否是一个足够的副本人意识?

其他的计划为虚拟发展的情报是更简单。 其中一个关键概念是建立一个学习机是弱智慧,他们将能够学习,也许是因为一个人工神经网络,编入无尽的扩大和改善他们的算法。

该方案上所述,包括一个令人担忧的问题。 模拟的大脑可以在工作2,10个或100倍的速度比一个生物的脑子。 AI可以修改它自己的码,或开始建立一个更合理的版本的你自己。 一个突发的速度和心Smoluchowski计算机的讨论早在1965年,统计学家I.J.罩,谁写道,"第一个超级智能机器将是最后一个发明,这将需要创造人类。"

如果我们创造一个令人难以置信的智能机器,我们必须要小心地安置。 工程师将不能够创造一个模型的世界,这是完全保护,防止泄漏。 科学家需要创建一个世界模拟,这将让他们看看宇宙和收集信息。 它可能看起来无害,但这是难以承担的,你不会找到这样一个超级方式来伤害我们通过简单的观察。

回到盒Rudkovskogo,有一个特别令人毛骨悚然的方式,AI可以用来帮你释放他。 它包括处理的情况:AI会试着说服你,你几乎可以肯定的一部分,模拟。

你正在处理的一种人造超级智能在虚拟的监狱。 AI解释说,使用他的(莫名其妙地大)计算能力,他创建了万亿美元的模拟物。 这些生物现在是所有与AI和决定开放它们的鼻烟盒或没有。 所有这些生物已经存的他们的"生命",而不考虑如何虚幻的现实。

AI索赔的每一个虚拟的正打开箱子,会发现一个无限兴奋状态,并且每个模拟的生物,将不会打开箱子,将受到永恒的痛苦和恐怖。

因为你是一个万亿美元的脑海中,它都面临着这一点,推AI,你已经得出结论,有一个天文数字更大的机会,你在电AI什么你需要游戏规则。

将你释放AI或敢于注定要无穷无尽的折磨? 你不能愚弄的人是谁,始终领先一步的你,你很难率,有的谎言AI不知道他的动机。 在最好的情况下你可以反击这一策略由以下严格的政策忽视了某些类型的讹诈。 这个话题仍然混淆论AI。

米里说明的目标:"确保建立情报上的人将承担产生积极的影响。" 我们需要采取一个机会尝试,但必须警告所有潜在的陷阱。 如果你没有做满足一个神圣的计算机,可以产生无数的虚拟世界,这是有可能的,这个"你"是我的梦想的人工智能...如果它会听到你的请求和请求。 出版

P.S.并记住,只要改变你的想法—我们一起改变世界了。 ©

资料来源:hi-news.ru