3033

El pensamiento lógico. Parte 3: Perceptron, red de convolución

En la primera parte de la se describen las propiedades de las neuronas. segundo habló de las propiedades básicas asociadas a su formación. Ya en la siguiente sección, nos dirigimos a la descripción de cómo un cerebro real. Pero antes de eso, tenemos que hacer un esfuerzo final para aceptar e incluso un poco de teoría. Ahora parece probable que no particularmente interesante. Tal vez yo mismo habría zaminusovali un post entrenamiento. Pero todo esto "alfabeto" en gran medida nos ayuda a comprender el futuro.

Perceptrón

En la máquina cuota de aprendizaje dos enfoques básicos: aprendizaje supervisado y aprendizaje no supervisado. Métodos descritos anteriormente para aislar el componente principal - está aprendiendo sin profesor. La red neuronal no recibe ninguna explicación al hecho de que ella se alimenta a la entrada. Simplemente destaca aquellos regularidades estadísticas que están presentes en la corriente de datos de entrada. En contraste, supervisó el aprendizaje supone que parte de las imágenes de entrada, llama la muestra de entrenamiento, sabemos lo que el resultado de la salida que queremos. Por consiguiente, el problema - así configurado red neuronal para capturar los patrones que conectan los datos de entrada y de salida

.

En 1958, Frank Rosenblatt describe la construcción, lo que él llamó el perceptrón (Rosenblatt, 1958), que es capaz de aprender con un profesor (ver KDPV).

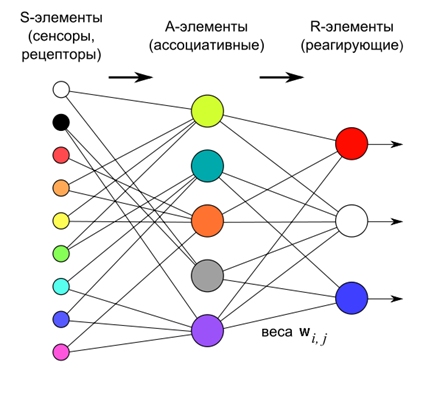

Según Rosenblatt perceptrón se compone de tres capas de neuronas. Primera capa - esta elementos sensores que definir lo que tenemos en la entrada. Segunda capa - elementos asociativos. Su comunicación con la capa de contacto se define y determina rígidamente por la transición a una más general que la capa de contacto asociativas descripciones y fotos.

Aprender perceptrón realizada por el cambio de los pesos de las neuronas de la tercera capa de la sustancia reaccionante. Meta de aprendizaje - Haga perceptrón correctamente clasifican las imágenes suministradas

.

Las neuronas de la capa de tercer trabajo como sumadores umbral. Por consiguiente, el peso de cada uno de estos parámetros definen un cierto hiperplano. Si hay una señal de entrada linealmente separables, las neuronas de salida de los justos y puede actuar como sus clasificadores.

Si - es un vector de la producción real y el perceptrón - vector, que esperamos recibir, en la calidad del vector de error de red neuronal dice:

Si le preguntas a minimizar el error medio cuadrado, a continuación, podemos derivar las llamadas delta en reglas modificaciones pesos:

En esta primera aproximación puede hacer el peso cero.

Esta regla no es más que la regla de Hebb, aplicado al caso de la perceptrón.

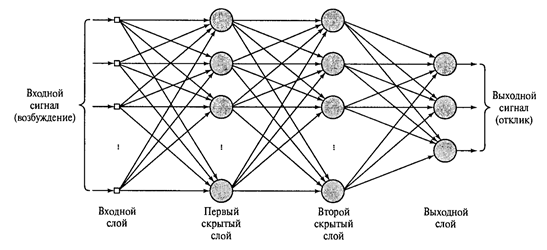

Si la fiesta es otra capa o múltiples capas de reaccionar y abandonar capa asociativa, que fue presentado por Rosenblatt validez más biológica, que por necesidad computacional, entonces obtenemos un perceptrón multicapa, como se muestra en la siguiente figura.

El perceptrón multicapa con dos capas ocultas (Haykin, 2006) i>

Si las neuronas que reaccionan capas eran simples combinador lineal es poco sentido en una complicación tal no sería. Rendimiento, independientemente del número de capas ocultas, todavía queda una combinación lineal de las señales de entrada. Pero al igual que en las capas ocultas se utilizan sumadores umbral, entonces cada nueva capa se rompe la linealidad de la cadena y se puede llevar a su descripción interesante.

Durante mucho tiempo no estaba claro cómo entrenar a un perceptrón multicapa. El método básico - Backpropagation fue descrito sólo en 1974, AI Galushkin independientemente y simultáneamente por Paul J .. Verbosom. Entonces fue redescubierto y llegó a ser ampliamente conocido en 1986 (David E. Rumelhart, Geoffrey E. Hinton, Ronald J. Williams, 1986).

El método consiste en dos pasos: avance y retroceso. Con pasillo directa servido señal de la formación y la actividad calculado de todos los nodos de la red, incluyendo la actividad de la capa de salida. Se obtiene al deducir la actividad de lo que se necesita para obtener la señal de error se determina. En la señal de error de paso inverso se propaga en la dirección opuesta a la salida a la entrada. Así pesos sinápticos se ajustan para minimizar este error. Descripción detallada del método se puede encontrar en muchas fuentes (por ejemplo, Haykin, 2006).

Es importante prestar atención al hecho de que en el Perceptrón multicapa información se procesa a partir de un nivel a otro. Cuando cada capa asigna un conjunto de atributos característicos de la señal de entrada. Esto crea una cierta analogía con la forma en que la información se convierte entre las zonas de la corteza cerebral.

Red de convolución. Neocognitrón

Comparación de perceptrón multicapa y el cerebro real es muy condicional. General - es que, al pasar de una zona a otra en la corteza o de capa a capa perceptrón, la información se está convirtiendo descripción más generalizada. Sin embargo, la estructura de la parte de la corteza es mucho más compleja que la organización de las neuronas en el perceptrón de capa. Estudios del sistema visual D. Hubel y T. Wiesel permite una mejor comprensión de la estructura de la corteza visual y empujaron a la utilización de este conocimiento en redes neuronales. Las ideas principales que se han utilizado - es la percepción de las áreas locales y la división de funciones dentro de las neuronas de una capa

.

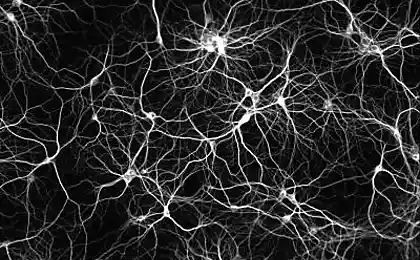

Localidad de la percepción ya es familiar para nosotros, significa que la neurona que recibe información, no monitorea para todo el espacio de la señal de entrada, pero sólo parte de ella. Anteriormente dijimos que esta zona se llama rastreo campo receptivo de la neurona.

El concepto de campo receptivo requiere una especificación separada. Tradicionalmente, el campo receptivo de una neurona se llama el espacio de los receptores, lo que afecta el funcionamiento de la neurona. Bajo se entienden las neuronas receptoras percibir directamente las señales externas. Imagínese una red neural que consiste en dos capas en la que la primera capa - capa de receptor y la segunda capa - las neuronas conectadas a los receptores. Para cada neurona de la segunda capa, los receptores que tienen contacto con él - este es su campo receptivo

.

Ahora tome una red multicapa compleja. Cuanto más nos alejamos de la entrada, más difícil será indicar qué y cómo los receptores influyen en la actividad de las neuronas localizadas de profundidad. Desde un cierto punto puede ser que para algunos receptores de las neuronas que existen puede ser llamado su campo receptivo. En esta situación, el campo receptivo de la neurona quiere llamar sólo esas neuronas con las que tiene contacto directo sináptica. Para separar estos conceptos serán llamados el espacio de los receptores de entrada - el campo receptivo originales. Y entonces el espacio de las neuronas que interactúa directamente con la neurona -. Campo receptivo local o simplemente campo receptivo, sin más aclaraciones

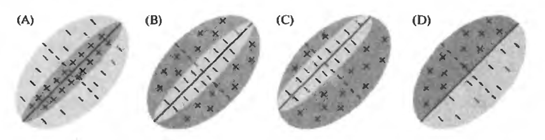

La división de las neuronas a la función asociada con la detección de la corteza visual primaria de dos tipos básicos de neuronas. (Simple), las neuronas simples responden a un estímulo, que se encuentra en un lugar determinado de su campo receptivo originales. (Complejas) neuronas complejos son activos en el estímulo, independientemente de su posición.

Por ejemplo, la siguiente figura muestra las opciones que podría parecerse a la imagen de la sensibilidad inicial de los campos receptivos de las células simples. Campo positivo activa una neurona suprimir negativo. Cada neurona tiene un estímulo simple, el más adecuado para él y causando así la actividad máxima. Pero lo importante es que este estímulo se instala firmemente en una posición en el campo receptivo originales. El mismo estímulo, pero se movió hacia un lado, no daría lugar a un sencillo neurona.

campos receptivos iniciales de células simples (J. Nicholls., Martin R., B. Wallace, P. Fuchs) I>

Neuronas complejos también tienen su estímulo preferido, pero pueden aprender este estímulo, independientemente de su posición en el campo receptivo originales.

A partir de estas dos ideas nacieron los modelos apropiados de las redes neuronales. La primera red de este tipo creado Kunihiko Fukushima. Ella fue nombrada cognitron. Más tarde se creó una red más avanzada - Neocognitrón (Fukushima, 1980). Neocognitrón - una estructura de varias capas. Cada capa consiste en neuronas simples © (s) y complejos.

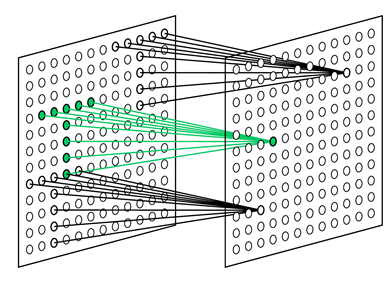

Neurona sencillo Objetivo supervisar su campo receptivo y la imagen reconocible, que se entrenó. Neuronas simples se recogieron en grupos (plano). Dentro de un grupo de neuronas simples sintonizados en el mismo estímulo, pero cada neurona está mirando su campo receptivo fragmento. Juntos, ordenadas todas las posiciones posibles de la imagen (ver figura siguiente). Todas las neuronas simples mismo plano tienen el mismo peso, pero diferentes campos receptivos. Se puede imaginar la situación de otra manera, se trata de una sola neurona, que es capaz de tratar en su camino de inmediato a todas las posiciones de la imagen original. Todo esto nos permite aprender de la misma manera, independientemente de su posición.

del campo receptivo de las células simples sintonizados para buscar el patrón seleccionado en diferentes posiciones (Fukushima K., 2013) i>

Cada neurona monitores integrados sus planos y neuronas simples fuegos cuando se activa al menos una de las neuronas simples en su plano (ver figura siguiente). Actividad neuronal simple dice que aprendió el estímulo característica en ese lugar en particular, que es su campo receptivo. La actividad de la neurona complejo significa que la misma imagen se reúne toda la capa en la que las siguientes neuronas simples.

Plano Neocognitrón i>

Cada capa tiene su entrada después de la imagen de entrada formada complejos neuronas de la capa anterior. De capa a capa se produce más y síntesis de la información que resulta en el reconocimiento de imágenes específicas, independientemente de su ubicación en la imagen original y una transformación.

Con respecto a la de análisis de imagen significa que detecta el nivel de la primera línea en un cierto ángulo, pasando a través de los pequeños campos receptivos. Es capaz de detectar todas las direcciones posibles en cualquier parte de la imagen. Siguiente Nivel detectar posibles combinaciones de características elementales, que definen una forma compleja. Y así hasta el nivel hasta que pueda determinar la imagen deseada (véase la figura más abajo).

El proceso de reconocimiento en Neocognitrón i>

Cuando se utiliza para el reconocimiento de escritura tal construcción es resistente al método de la escritura. El éxito de reconocimiento no afecta ni mover o girar sobre la superficie, ninguna deformación (tracción o compresión).

La diferencia más significativa desde el perceptrón multicapa completa Neocognitrón malla - un número mucho más pequeño de los pesos utilizados para el mismo número de neuronas. Si llega el caso, debido a "truco" que permite a las imágenes para determinar la Neocognitrón independientemente de su posición. Plano de células simples - es esencialmente una sola neurona, el peso del que determinan el núcleo de convolución. Este kernel se aplica a la capa anterior, se ejecuta en todas las posiciones posibles. En realidad las neuronas cada plano y preguntar por sus vínculos coordenadas de estas posiciones. Esto conduce al hecho de que todas las neuronas capa de células simples reloj que no aparece ya sea en su campo receptivo imagen correspondiente a la del núcleo. Es decir, si dicha imagen se reunirá en algún lugar de la señal de entrada para esa capa, esto es detectado por al menos una actividad de la neurona sencilla, y causar un compuesto correspondiente de la neurona. Este truco te permite buscar una imagen distintiva en cualquier lugar, donde quiera que apareció. Pero hay que recordar que esto es un truco y no es realmente corresponden a la obra real de la corteza.

Neocognitrón Educación se produce sin un maestro. Se corresponde con el procedimiento descrito anteriormente para la asignación de un conjunto completo de factores. Cuando la entrada de la Neocognitrón sirve imágenes reales, las neuronas no tienen más remedio que asignar estas imágenes los componentes inherentes. Por lo tanto, si se alimenta a la entrada de dígitos escritos a mano, los pequeños campos receptivos de neuronas simples de la primera capa podrán ver la líneas, ángulos, y la conjugación. Dimensiones zonas de competencia definen cuántos factores diferentes pueden ser asignados a cada región espacial. Principalmente asignado componentes más significativos. Para dígitos escritos a mano será líneas en diferentes ángulos. Si permanece factores inmunes, que luego se puede asignar y elementos más complejos.

De capa a capa conservado el principio general de aprendizaje - stand factores específicos de la pluralidad de señales de entrada. Alimentar dígitos escritos a mano sobre la primera capa a un cierto nivel, obtenemos los factores correspondientes a estos números. Cada dígito será una combinación de conjunto estable de características que se destacan como un factor independiente. La última capa contiene tantas neuronas Neocognitrón cómo se supone de detectar. La actividad de una de las neuronas de la capa de dicho reconocimiento en consecuencia (figura siguiente)

Reconocimiento en el Neocognitrón (Fukushima K., Neocognitrón, 2007) i>

El video a continuación proporciona una representación visual de la Neocognitrón.

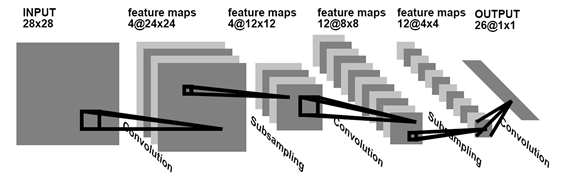

Aprendizaje alternativo sin un maestro - un aprendizaje supervisado. De este modo, en el ejemplo con los números, no podemos esperar hasta que la propia red proporcionará formas estadísticamente estables, y decirle que por su figura se presenta, y requieren una formación adecuada. Los resultados más significativos en este entrenamiento redes convolucionales lograron Yann LeCun (Y. LeCun e Y. Bengio, 1995). Él mostró cómo se pueden utilizar las redes de aprendizaje backpropagation, la arquitectura de los cuales, al igual que el Neocognitrón, que recuerda vagamente a la estructura de la corteza cerebral.

convolución Red para el reconocimiento de escritura a mano (Y. LeCun e Y. Bengio, 1995) i>

En este, se supone que la información inicial mínimo recordar y puede ir a cosas más interesantes y sorprendentes.

Continuación

Referencias

Partes anteriores:

Parte 1. Neurona

Parte 2. Factores

Alexei Redozubov (2014)

Fuente: habrahabr.ru/post/214317/