1816

0.4

2014-03-21

Логика мышления. Часть 8. Выделение факторов в волновых сетях

В предыдущих частях мы описали модель нейронной сети, которую назвали волновой. Наша модель существенно отличается от традиционных волновых моделей. Обычно исходят из того, что каждому нейрону свойственны собственные осцилляции. Совместная работа таких склонных к систематической пульсации нейронов, приводит в классических моделях к определенной общей синхронизации и появлению глобальных ритмов. Мы вкладываем в волновую активность коры совсем другой смысл. Мы показали, что нейроны способны фиксировать информацию не только за счет изменения чувствительности своих синапсов, но и благодаря изменениям в мембранных рецепторах, расположенных вне синапсов. В результате этого нейрон приобретает способность реагировать на большой набор определенных паттернов активности окружающих его нейронов. Мы показали, что срабатывание нескольких нейронов, образующих определенный узор, обязательно запускает волну, распространяющуюся по коре. Такая волна это не просто возмущение, передающееся от нейрона к нейрону, а сигнал создающий по мере продвижения определенный узор активности нейронов, уникальный для каждого излучившего его паттерна. Это означает, что в любом месте коры по тому узору, что принесла с собой волна, можно определить какие паттерны на коре пришли в активность. Мы показали, что через небольшие пучки волокон волновые сигналы могут проецироваться на другие зоны коры. Сейчас мы поговорим о том как может происходить синаптическое обучение нейронов в наших волновых сетях.

Выделение волновых факторов

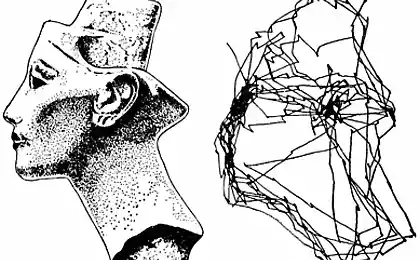

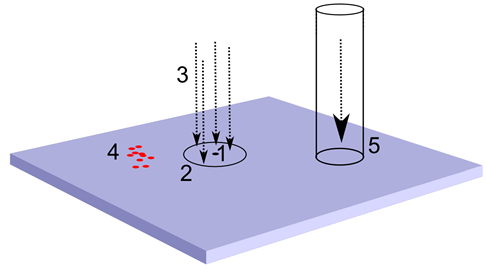

Возьмем произвольный нейрон коры (рисунок ниже). У него есть рецептивное поле, внутри которого он имеет густую сеть синаптических соединений. Эти соединения охватывают как окружающие его нейроны, так и входящие в кору аксоны, несущие сигналы от других участков мозга. Благодаря этому нейрон способен следить за активностью небольшой окружающей его области. Если на зону коры, к которой он принадлежит, приходится топографическая проекция, то нейрон получает сигналы с тех аксонов, что попадают в его рецептивное поле. Если на коре существуют активные паттерны вызванной активности, то нейрон видит фрагменты идентификационных волн от них, когда они проходят мимо него. Аналогично с волнами, которые возникают от волновых туннелей, переносящих волновую картину от одной области мозга к другой.

Источники информации для выделения фактора. 1 – нейрон коры, 2 – рецептивное поле, 3 – топографическая проекция, 4 – паттерн вызванной активности, 5 – волновой туннель

В активности, видимой нейроном на своем рецептивном поле, независимо от ее происхождения, соблюдается главный принцип – каждое уникальное явление вызывает свой уникальный, присущей только этому явлению узор. Повторяется явление – повторяется и паттерн активности, видимый нейрону.

Если происходящее содержит несколько явлений, то друг на друга накладывается несколько узоров. При наложении паттерны активности могут не совпасть по времени, то есть фронты волн могут разминуться. Чтобы учесть это, выберем показательный временной интервал, равный периоду одного волнового цикла. Накопим для каждого синаптического входа нейрона активность за этот промежуток времени. То есть просто просуммируем, сколько спайков пришло на тот или иной вход. В результате мы получим вектор входа, описывающий интегрированную за цикл картину синаптической активности. Имея такой входной вектор, мы можем использовать для нейрона все описанные ранее методы обучения. Например, мы можем превратить нейрон в фильтр Хебба и заставить его выделить главную компоненту, содержащуюся во входном потоке данных. По своему смыслу это будет выявление тех входов, на которых чаще всего входящие сигналы проявлялись совместно. Применительно к идентификационным волнам – это означает, что нейрон определит, какие волны обладают закономерностью появляться время от времени вместе, и настроит свои веса на узнавание этого сочетания. То есть, выделив такой фактор, нейрон станет проявлять вызванную активность, когда будет узнавать знакомое ему сочетание идентификаторов.

Таким образом, нейрон приобретет свойства нейрона-детектора, настроенного на определенное явление, детектируемое по своим признакам. При этом нейрон не просто будет срабатывать как датчик наличия (есть явление – нет явления), он будет уровнем своей активности сигнализировать о выраженности того фактора, на который он обучился. Интересно, что при этом не принципиальна природа синаптических сигналов. С одинаковым успехом нейрон может настраиваться на обработку волновых паттернов, паттернов топографической проекции или их совместную активность.

Надо отметить, что Хеббовское обучение, выделяющее первую главную компоненту, приведено чисто иллюстративно, чтобы показать, что локальное рецептивное поле любого нейрона коры содержит всю необходимую информацию для обучения его как универсального детектора. Реальные алгоритмы коллективного обучения нейронов, выделяющие множество разнообразных факторов, организованы несколько сложнее.

Стабильность – пластичность

Хеббовское обучение очень наглядно. Его удобно использовать для иллюстрации сути итерационного обучения. Если говорить только об активизирующих связях, то по мере того, как нейрон обучается, его веса настраиваются на определенный образ. Для линейного сумматора активность определяется:

Совпадение сигнала с образом, который выделяется на синаптических весах, вызывает сильный ответ нейрона, несовпадение – слабый. Обучая по Хеббу, мы усиливаем веса тех синапсов, на которые поступает сигнал в моменты, когда и сам нейрон активен, и ослабляем те веса, на которых в это время нет сигнала.

Чтобы избежать бесконечного роста весов, вводят нормирующую процедуру, которая держит их сумму в определенных границах. Такая логика приводит, например, к правилу Ойа:

Самое неприятное в стандартном Хеббовском обучении – это необходимость вводить коэффициент скорости обучения, который необходимо уменьшать по мере обучения нейрона. Дело в том, что если этого не делать, то нейрон, обучившись на какой-либо образ, затем, если характер подаваемых сигналов изменится, переобучится на выделение нового фактора, характерного для изменившегося потока данных. Уменьшение же скорости обучения, во-первых, естественно, замедляет процесс обучения, а во-вторых, требует не очевидных методов управления этим уменьшением. Неаккуратное обращение со скоростью обучения может привести к «одеревенению» всей сети и невосприимчивости к новым данным.

Все это известно как дилемма стабильности-пластичности. Желание реагировать на новый опыт грозит изменением весов ранее обученных нейронов, стабилизация же приводит к тому, что новый опыт перестает влиять на сеть и просто игнорируется. Приходится выбирать либо стабильность, либо пластичность. Чтобы понять, какие механизмы могут помочь в решении этой проблемы, вернемся к биологическим нейронам. Разберемся чуть подробнее с механизмами синаптической пластичности, то есть с тем, за счет чего происходит синаптическое обучение реальных нейронов.

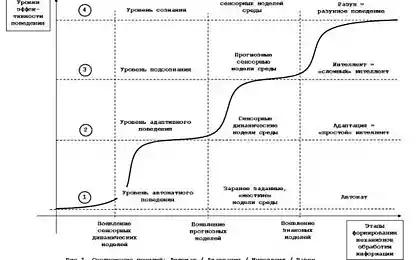

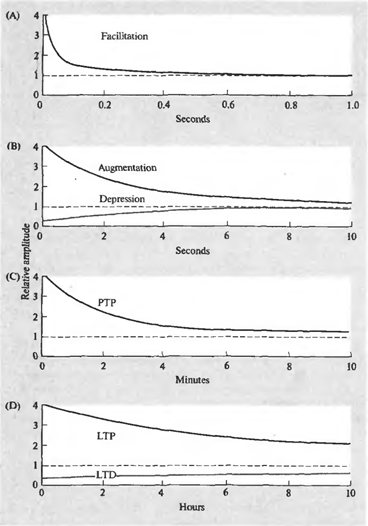

Суть явления синаптической пластичности в том, что эффективность синаптической передачи не постоянна и может меняться в зависимости от паттерна текущей активности. Причем продолжительность этих изменений может сильно варьироваться и обуславливаться разными механизмами. Различают несколько форм пластичности (рисунок ниже).

Динамика изменения синаптической чувствительности. (A) – фасилитация, (B) – усиление и депрессия, ( C) – посттетаническая потенция (D) – долговременная потенция и долговременная депрессия (Николлс Дж., Мартин Р., Валлас Б., Фукс П., 2003)

Короткий залп спайков может вызывать облегчение (фасилитацию) выделения медиатора из соответствующей пресинаптической терминали. Фасилитация появляется мгновенно, сохраняется во время залпа и существенно заметна еще около 100 миллисекунд после окончания стимуляции. То же короткое воздействие может привести к подавлению (депрессии) выделения медиатора, длящемуся несколько секунд. Фасилитация может перейти во вторую фазу (усиление), продолжительностью, аналогичной продолжительности депрессии.

Продолжительная высокочастотная серия импульсов обычно называется тетанусом. Название связано с тем, что подобная серия предшествует тетаническому мышечному сокращению. Поступление тетануса на синапс, может вызвать посттетаническую потенцию выделения медиатора, наблюдающуюся в течение нескольких минут.

Повторяющаяся активность может стать причиной долговременных изменений в синапсах. Одна из причин этих изменений – увеличение концентрации кальция в постсинаптической клетке. Сильное увеличение концентрации запускает каскады вторичных посредников, что ведет к образованию дополнительных рецепторов в постсинаптической мембране и общему увеличению чувствительности рецепторов. Более слабое увеличение концентрации дает обратный эффект – уменьшается количество рецепторов, падает их чувствительность. Первое состояние называется долговременной потенцией, второе – долговременной депрессией. Продолжительность таких изменений – от нескольких часов до нескольких дней (Николлс Дж., Мартин Р., Валлас Б., Фукс П., 2003).

То, как изменится чувствительность отдельного синапса в ответ на поступление внешних импульсов, произойдет ли усиление или наступит депрессия, определяется многими процессами. Можно предположить, что главным образом это зависит от того, как складывается общая картина возбуждения нейрона и в какой стадии обучения он находится.

Описанное поведение синаптической чувствительности позволяет далее предположить, что нейрон способен к следующим операциям:

- достаточно быстро настраиваться на определенный образ – фасилитация;

- сбрасывать эту настройку через интервал порядка 100 миллисекунд или переводить ее в более продолжительное удержание – усиление и депрессия;

- сбрасывать состояние усиления и депрессии или переводить их в долговременную потенцию или долговременную депрессию.

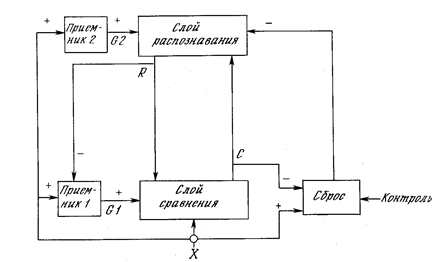

Сеть адаптивного резонанса АРТ

Практическая реализация этой теории – сети АРТ. Сначала сеть АРТ не знает ничего. Первый же поданный на нее образ создает новый класс. Сам образ копируется как прототип класса. Следующие образы сравниваются с существующими классами. Если образ оказывается близок к уже созданному классу, то есть вызывает резонанс, то происходит корректирующее обучение образа класса. Если же образ оказывается уникален и не похож ни на один из прототипов, то создается новый класс, при этом новый образ становится его прототипом.

Если предположить, что формирование нейронов детекторов в коре происходит схожим образом, то фазам синаптической пластичности можно дать следующее толкование:

- нейрон, еще не получивший специализацию как детектор, но пришедший в активность за счет волновой активации, оперативно меняет веса своих синапсов, настраиваясь на картину активности своего рецептивного поля. Эти изменения носят характер фасилитации и продолжаются порядка одного такта волновой активности;

- если оказалось, что в ближайшем окружении уже достаточно нейронов-детекторов, настроенных на такой стимул, то нейрон сбрасывается в исходное состояние, в противном случае его синапсы переходят в стадию более длительного удержания образа;

- Если в течение стадии усиления выполнились определенные условия, то синапсы нейрона переходят в стадию долговременного хранения образа. Нейрон становится детектором соответствующего стимула.

- чтобы с их помощью можно было достаточно полно и адекватно описывать все происходящее;

- чтобы такое описание вычленяло основные закономерности, свойственные происходящим событиям.

Хорошо известен подход, основанный на оптимальном сжатии данных. Так, например, используя факторный анализ, мы можем получить главные компоненты, на долю которых приходится основная доля изменчивости. Оставив значения нескольких первых компонент и отбросив остальное, мы сможем значительно уменьшить длину описания. Кроме того, значения факторов расскажут нам о выраженности в описываемом событии тех явлений, которым эти факторы соответствуют. Но такое сжатие имеет и обратную сторону. Для реальных событий первые главные факторы объясняют в совокупности обычно лишь небольшой процент общей дисперсии. Каждый их малозначимых факторов хотя и уступает во много раз по величине первым факторам, но именно сумма этих малозначимых факторов отвечает за основную информацию.

Например, если взять несколько тысяч кинофильмов и получить их оценки, проставленные сотнями тысяч пользователей, то с такими данными можно провести факторный анализ. Наиболее значимыми окажутся первые четыре – пять факторов. Они будут соответствовать основным жанровым направлениям кинематографа: боевик, комедия, мелодрама, детектив, фантастика. Для российских пользователей кроме того выделится сильный фактор, описывающий наше старое советское кино. Выделенные факторы имеют простую интерпретацию. Если описать какой-либо фильм в пространстве этих факторов, то это описание будет состоять из коэффициентов, говорящих, насколько тот или иной фактор выражен в данном фильме. Каждый пользователь имеет определенные жанровые предпочтения, которые влияют на его оценку. Факторный анализ позволяет вычленить основные направления этого влияния и превратить их в факторы. Но оказывается, что первые значимые факторы объясняют всего около 25% дисперсии оценок. Все остальное приходится на тысячи остальных мелких факторов. То есть если мы попытаемся сжать описание фильма до его портрета в главных факторах, мы потеряем основной объем информации.

Кроме того, нельзя говорить о неважности факторов с малой объясняющей способностью. Так, если взять несколько фильмов одного режиссера, то их оценки, скорее всего, окажутся тесно коррелированы между собой. Соответствующий фактор будет объяснять существенный процент дисперсии оценок этих фильмов, но только этих. Это значит, что поскольку этот фактор не проявляется в других фильмах, то его объясняющий процент во всем объеме данных будет ничтожен. Но именно для данных фильмов он будет значительно важнее, чем первые главные компоненты. И так практически для всех малых факторов.

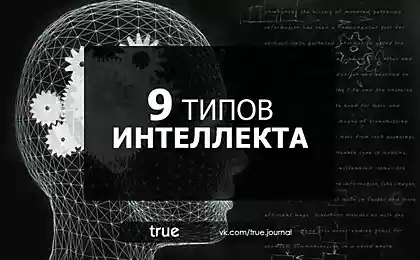

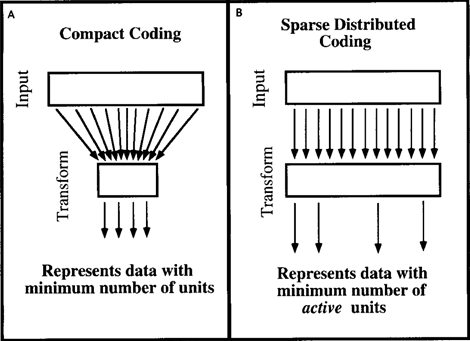

Рассуждения, приведенные для факторного анализа, можно переложить и на другие методы кодирования информации. Дэвид Филд в статье 1994 года «Какова цель сенсорного кодирования?» (Field, 1994) рассмотрел подобные вопросы относительно механизмов, свойственных мозгу. Он пришел к выводу, что мозг не занимается сжатием данных и не стремится к компактному виду данных. Мозгу более удобно их разряженное представление, когда имея для описания множество различных признаков, он одновременно использует только малую их часть (рисунок ниже).

Компактное кодирование (A) и экономное распределенное кодирование (B) (Field, 1994)

И факторный анализ, и многие другие методы описания отталкиваются от поиска определенных закономерностей и выделения соответствующих факторов или признаков классов. Но часто встречаются наборы данных, где этот подход практически неприменим. Например, если мы возьмем положение часовой стрелки, то окажется, что у нее нет предпочтительных направлений. Она равномерно движется по циферблату, отсчитывая час за часом. Чтобы передать положение стрелки, нам не надо выделять какие-либо факторы, да они и не выделятся, а достаточно разбить циферблат на соответствующие секторы и пользоваться этим разбиением. Очень часть мозг имеет дело с данными, которые не подразумевают деления, учитывающего плотность распределения событий, а просто требуют введения какого-либо интервального описания. Собственно, принцип адаптивного резонанса и предлагает механизм создания такого интервального описания, способный работать даже тогда, когда пространство данных представляет собой достаточно равномерную распределенную среду.

Выделение главных компонент или фиксация прототипов адаптивного резонанса – это далеко не все методы, позволяющие нейронным сетям обучать нейроны-детекторы, удобные для формирования систем описания. Собственно, любой способ, который позволяет либо получить здравое деление на группы, либо выделить какую-либо закономерность, может использоваться нейронной сетью, воспроизводящей кору мозга. Очень похоже, что реальная кора эксплуатирует множество различных методов, не ограничиваясь теми, что мы привели для примера.

Пока мы говорили об обучении отдельных нейронов. Но основной информационный элемент в наших сетях — это паттерн нейронов, только он способен запустить собственную волну. Отдельный нейрон в поле не воин. В следующей части мы опишем как могут возникать и работать нейронные паттерны, соответствующие определенным явлениям.

Использованная литература

Продолжение

Предыдущие части:

Часть 1. Нейрон

Часть 2. Факторы

Часть 3. Персептрон, сверточные сети

Часть 4. Фоновая активность

Часть 5. Волны мозга

Часть 6. Система проекций

Часть 7. Интерфейс человек-компьютер

Алексей Редозубов (2014)

Источник: habrahabr.ru/post/215151/

Портал БАШНЯ. Копирование, Перепечатка возможна при указании активной ссылки на данную страницу.

Логика мышления. Часть 7. Интерфейс человек-компьютер

Логика мышления. Часть 9. Паттерны нейронов-детекторов. Обратная проекция