608

0.1

2016-09-21

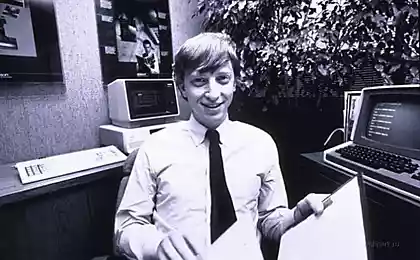

Почему Биллу Гейтсу ( и Вам ) не стоит бояться искусственного интеллекта

На прошлой неделе Билл Гейтс в ходе сессии вопросов и ответов на ресурсе Reddit получил интересный вопрос от одного из пользователей: «Какую угрозу для выживания человечества представляет машинный сверхинтеллект, и считаете ли вы, что полное шифрование всей активности в Интернете может защитить нас от этой угрозы (то есть чем меньше знают машины, тем лучше?».

К сожалению, Гейтс не ответил на вторую часть вопроса, но написал следующее:

«Я отношусь к людям, кто беспокоится по поводу сверхинтеллекта. Поначалу машины будут делать кучу работы для нас и не будут особо разумны. Будет неплохо, если мы будем умело ими руководить. Спустя несколько десятилетий этот интеллект станет достаточно мощным, чтобы стать проблемой. Я согласен с Элоном Маском и другими по этому вопросу и не понимаю, почему люди не беспокоятся».

К счастью робофобов, лучшая команда антигероев почти собрана. Элон Маск и Билл Гейтс — это кошелек и влияние, легендарный космолог Стивен Хокинг — чрезвычайно важная персона. Им не хватает разве что рук, которые будут способны на грязные поступки против машин в этой превентивной войне.

На самом деле, этим зарождающимся Мстителям нужно еще кое-что более дальновидное: любой признак того, что искусственный сверхинтеллект будет серьезной угрозой, или более серьезное исследование.

Тем не менее, на фоне растущей истерии вокруг несуществующего искусственного интеллекта, возникают серьезные недоумения. Эксперты не видят ни намека на исполинский тиранический искусственный интеллект в современном коде. Возможно, Гейтс, Хокинг и Маск чертовски умные ребята и знают что-то, чего не знаем мы. Но можно послушать и ведущих исследователей этого самого искусственного интеллекта.

Когда люди обсуждают нейронные сети, когнитивные вычисления и в целом понятие искусственного интеллекта, который должен превзойти человеческий, они также говорят и о машинном и глубоком обучении. Если кто и знает, что настало время паниковать, то эти ребята.

Искусственный сверхинтеллект не приходит ниоткуда

Вот Дилип Джорд, соучредитель стартапа искусственного интеллекта Vicarious, рассуждает о рисках сверхинтеллекта:«История помнит много паник вокруг самых разных технологий, от парового двигателя до ядерной энергии и биотехнологий. Вы продадите больше газет и билетов в кино, если сыграете на истерии, и сейчас, на мой взгляд, происходит то же самое: люди раздувают страхи вокруг искусственного интеллекта. Как ученые, мы должны информировать общественность о разнице между Голливудом и реальностью. Сообщество искусственного интеллекта не стоит еще даже на пороге создания чего-то подобного, о чем стоит беспокоиться».

Эта точка зрения Vicarious имеет вес не только из-за текущей работы компании над искусственным интеллектом, но и потому, что Элон Маск представил стартап как часть своего взгляда за занавес. Маск рассказал CNBC, что инвестировал в Vicarious «не для того, чтобы отбить инвестиции, а чтобы иметь возможность приглядывать за искусственным интеллектом». Он также писал, что «ведущие компании по разработке ИИ принимают серьезные меры для обеспечения безопасности. Они осознают опасность, что считают, что смогут формировать и контролировать цифровой сверхинтеллект и предотвратить его бегство в Интернет. Посмотрим…».

На вопрос Vicarious о том, сколько времени и ресурсов они посвящают защите от искусственного интеллекта, отвечал Скотт Феникс, еще один соучредитель Vicarious:

«Искусственный интеллект не появляется случайно или внезапно. Мы находимся в самом начале исследований того, как вообще построить базовую систему интеллекта, а впереди еще долгий процесс повторения и обучения такой системы, изучения путей ее создания и путей безопасности».

Vicarious не имеет дела со сверхинтеллектом. Его даже нет на радарах. О каких же тогда компаниях говорит Маск, а о каких серьезно беспокоится, по его же словам, мол, чтобы плохой сверхинтеллект не «сбежал в Интернет»? Как, по его же словам, построить тюрьму для демона, когда и самих-то демонов нет?

Вот как на вопрос о том, как компании активно удерживают искусственный интеллект под замком, ответил Ян Лекун, директор по исследованиям ИИ в Facebook:

«Некоторые люди задаются вопросом, как воспрепятствовать тому, что гипотетический сверхразумный доброжелательный искусственный интеллект решит «перепрограммировать» себя и гарантирует выпиливание всего человечества. Большинство этих людей сами не являются исследователями ИИ, даже программистами не являются».

Лекун также указывает один из источников путаницы: на разницу между интеллектом и автономией.

«Допустим, у вас на первый взгляд сверхразумная система, которая не обладает автономией. К примеру, шахматная программа, которая может одолеть практически любого человека. Обладает ли она сверхинтеллектом? Очень скоро автопилоты самолетов и самоуправляемые автомобили будут надежнее людей. Означает ли это, что они будут умнее людей? В очень узком смысле, эти системы будут «более разумны», чем люди, но их опыт будет лежать в очень узкой области, а у систем будет крайне мало автономии. Они не смогут выйти за рамки предписаний».

Это важное отличие, и оно хорошо описывает панику, которой поддались Маск, Хокинг, а теперь и Гейтс. ИИ может быть умным, не будучи разумным и творческим. Что еще более важно, ИИ не подгоняется неким цифровым эквивалентом биологического эволюционного пути, конкурируя и вопроизводясь с каждой мутацией все лучше и лучше, пока не достигнет безудержного сверхинтеллекта. Нет, не так работает ИИ.

Нас удивит машина с интеллектом мыши, но это произойдет не скоро

Алгоритм поиска выдает результаты быстрее любого человека, но в нем никогда не вырастет код этики и он не будет скрывать порнографию на свой вкус и цвет. Только писатель-фантаст или другой гуманитарий, далекий от компьютерных технологий, может представить, как искусственный интеллект человеческого уровня внезапным и непостижимым образом вырастает из ниоткуда. И если уж вы верите в одно чудо, почему бы не добавить другое, скажем, самособирающийся сверхинтеллект?Лекун выступает в защиту Маска, утверждая, что его комментарий, сравнивающий ИИ с ядерным оружием, был «преувеличен, но также неправильно понят».

«Элона очень беспокоят экзистенциальные угрозы человечеству (потому-то он и строит ракеты, которые смогут отправлять людей колонизировать другие планеты). Даже если риск восстания искусственного интеллекта ничтожен и призрачен, нам стоит задумываться о нем, выстраивать превентивную защиту, следовать строго очерченным правилам. Так же как были установлены биоэтические ограничения в 70-х и 80-х, еще до того, как генная инженерия стала использоваться повсюду, нам нужно создать ограничения в сфере этики искусственного интеллекта. Но, как правильно говорит Йошуа, у нас достаточно времени. Наши системы превосходят людей в очень узких областях, но общей ИИ человеческого уровня появится еще не скоро, возможно, через пару десятилетий, не говоря уж об автономном общем ИИ, который может быть никогда не построен».

Ученый, которому было что сказать по теме, был упомянут в предыдущем абзаце. Йошуа Бенгион — глава Лаборатории машинного обучения в Университете Монреаля, один из пионеров подобласти глубокого обучения (вместе с Лекуном). Вот его мнение по поводу того, что исследования ИИ таят в себе опасность:

«В этой точке зрения нет никакой истины, если рассматривать ее в контексте текущих исследований искусственного интеллекта. Большинство людей не понимают, насколько примитивные системы мы строим, и, к сожалению, многие журналисты (и некоторые ученые) распространяют страхи об ИИ, которые совершенно не соответствуют реальности. Мы бы офигели, если бы создали машину с интеллектом мыши в ближайшем будущем, но мы пока далеки от этого, очень далеки. Да, у этих алгоритмов уже сейчас есть полезное применение, и дальше будет больше. Более того, я правда считаю, что люди однажды создадут машины, которые будут столь же умны, сколько люди во многих отношениях. Однако это будет в далеком будущем, поэтому нынешние дебаты — пустая трата времени. Когда вопрос станет насущным, конечно, мы соберем ученых, философов и юристов, чтобы определить лучшие пути предупреждения последствий, принадлежащие в настоящее время научной фантастике».

На вопрос о том, является ли сверхинтеллект неизбежностью, Бенгио ответил:

«Довольно сложно ответить на этот вопрос, отбросив все строгости научного осмысления. Я вижу много хороших математических и вычислительных причин, почему исследования ИИ однажды зайдут в тупик (из-за экспоненциального роста сложности), в который зашел однажды человеческий интеллект — что, в принципе, также объясняет, почему дельфины и слоны, хотя и отличаются большим мозгом, не являются сверхразумными. Мы просто не знаем достаточно, чтобы зайти хоть сколько-нибудь дальше предположений в этом вопросе. Если эта гипотеза тупика подтвердится, однажды у нас будут компьютеры, которые будут так же умны, как люди, но будут обладать более быстрым доступом к знаниям. Но к тому времени люди могут тоже завладеть этим доступом к информации (в принципе, мы уже этим занимаемся, но медленно — через поисковые алгоритмы). Конечно, это не имеет ничего общего со сверхинтеллектом. Я думаю об ИИ как о помощи разуму, подобно тому, как промышленная революция была помощью рукам в течение двух последних столетий».

Что касается замечания Маска о том, что ИИ «потенциально опаснее ядерного оружия» и с ним нужно быть поосторожнее, Бенгио обращается к настоящему времени, не выбивая дверь в неизвестное будущее:

«Пока этот вопрос не имеет смысла. В будущем все может измениться, но пока мы гадаем на кофейной гуще. Когда мы доберемся туда, разумеется, мы задумаемся серьезно».

Общий лейтмотив в обсуждениях — время. Когда вы говорите с исследователями ИИ — опять же конкретно исследователями ИИ, людьми, которые работают с этими системами — они не особо беспокоятся о том, что сверхинтеллект подкрадывается к ним (глупцы, бегите!). В отличие от жутких историй, которых начитался Маск, исследователи искусственного интеллекта вообще не берутся даже обсуждать сверхинтеллект, его не существует даже в планах. Прав ли Билл Гейтс?

Источник: hi-news.ru

Портал БАШНЯ. Копирование, Перепечатка возможна при указании активной ссылки на данную страницу.