913

El corazón del imperio Google

Mucha gente conoce la diversidad de Google - el motor de búsqueda y de la red popular y social, así como un montón de otros servicios útiles e innovadores. Pero pocos de nosotros sabemos: cómo la compañía fue capaz de desplegar y mantener con una tolerancia de tan alto rendimiento y la culpa? ¿Cómo es el hecho de que proporcionan este tipo de oportunidades, - centro de datos Google, ¿cuáles son sus características? Sólo por esto y se discutirá en este artículo.

Fuente

En realidad, Google Inc. ha sido ninguna sorpresa los poderosos dinámica de su crecimiento. Un activista activo de "energía verde", muchas patentes en varios campos, abiertas y amistosas hacia los usuarios - éstas son las primeras asociaciones que se presentan ante la mención de Google para muchos. No menos impresionante y centro de datos (data center o centro de datos) de la empresa: Se trata de una red de centros de datos colocados en todo el mundo, el moschnostyu220 total de MW (a partir del año pasado). Dado el hecho de que la inversión en centros de datos sólo el año pasado ascendió a 2, 5 millones de dólares, está claro que la empresa considera que es de importancia estratégica dirección y prometedor. Al mismo tiempo, hay una especie de contradicción dialéctica, porque, a pesar de la publicidad de la empresa Google, sus centros de datos son el tipo de conocimiento secreto, oculto tras siete sellos. La compañía cree que la divulgación de los detalles del proyecto puede ser utilizado por los competidores, por lo tanto, sólo una parte de la información sobre las soluciones más avanzadas se filtran en las masas, pero incluso esta información es muy interesante.

Vamos a empezar con el hecho de que el propio Google no está directamente involucrado en la construcción del centro de datos. Él tiene un departamento que se ocupa del desarrollo y mantenimiento, y la compañía trabaja con integradores locales que hacen la introducción. La cantidad exacta de centro de datos construido no se anuncia, pero oprima su número varía de 35 a 40 en todo el mundo. La principal concentración de centros de datos representó los Estados Unidos, Europa occidental y Asia oriental. Además, algunos de los equipos ubicados en locales arrendados de centro de datos comercial, tener buenos canales de comunicación. Se sabe que Google utiliza el espacio para acomodar el equipo de centros de datos comercial Equinix (EQIX) y Savvis (SVVS). Google pretende cambiar estratégicamente exclusivamente a la utilización de sus propios centros de datos - la corporación se atribuye a la creciente demanda de privacidad de los usuarios que confían en nosotros, y fugas, inevitablemente, en los centros de datos comerciales. Siguiendo las últimas tendencias, este verano se anunció que Google ofrecerá alquiler de infraestructuras "nube" a terceras empresas y desarrolladores un modelo apropiado IaaS de servicio Compute Engine, que proporcionará la potencia de cálculo de una configuración fija con un pago por el uso por hora.

La característica principal de la red de centros de datos no es tanto en la fiabilidad de un único centro de datos, como en el geo-agrupación. Cada centro de datos tiene un montón de enlaces de comunicación de alta capacidad con el mundo exterior y replica sus datos a otros centros de datos, distribuidos geográficamente en todo el mundo. Por lo tanto, incluso una fuerza mayor, como meteoritos no afectó sustancialmente la seguridad de los datos. Centros de datos Geografía

El primer centro de datos públicos se encuentra en Douglas, Estados Unidos. Este centro de datos de contenedores (Fig. 1) se inauguró en 2005. El mismo centro de datos es el más público. De hecho, es una especie de estructura de trama, que se asemeja a un hangar, en cuyo interior están dispuestos en dos filas de contenedores. En una serie - 15 contenedores dispuestos en una capa y en el segundo - 30 contenedores dispuestos en dos niveles. Este centro de datos es de aproximadamente 45.000 servidores de Google. Contenedores - mar 20 pies. Por el momento, el trabajo puesto en los contenedores de 45, y el poder de los equipos informáticos es de 10 MW. Cada contenedor tiene su propia conexión con el circuito hidráulico de enfriamiento de una unidad de distribución de energía - que tiene, además de los interruptores automáticos y analizadores tiene el consumo de electricidad de los grupos de consumidores eléctricos para calcular el coeficiente de PUE. Estaciones de bombeo separado ubicados, cascadas de enfriadores, grupos electrógenos diesel y transformadores. Declarado PUE, igual a 1,25. Sistema de refrigeración - dual, mientras que el segundo bucle con economizadores torres de refrigeración utilizados, puede reducir significativamente el tiempo de funcionamiento de la unidad. De hecho, es nada más que una torre de refrigeración abierta. El agua absorbe el calor desde el servidor, se suministra a la parte superior de la torre, donde pulverizada y fluye hacia abajo. Debido a la disipación de calor del agua se transfiere al aire, que se sopla por los ventiladores desde el exterior, y la propia agua se vaporiza parcialmente. Esta solución reduce significativamente el tiempo de enfriadores en el centro de datos. Curiosamente, en un principio para la reposición de agua en el circuito externo para utilizar el agua del grifo purificada es apta para el consumo. En Google de pronto se dieron cuenta de que el agua no tiene por qué ser tan limpio, por lo que el sistema se estableció, la limpieza de las aguas residuales de las instalaciones de tratamiento cercanas y repoblación del agua en el circuito de refrigeración externo.

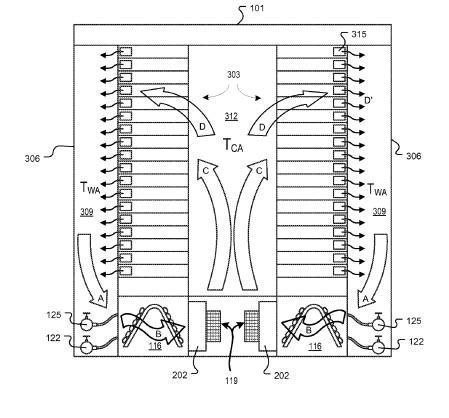

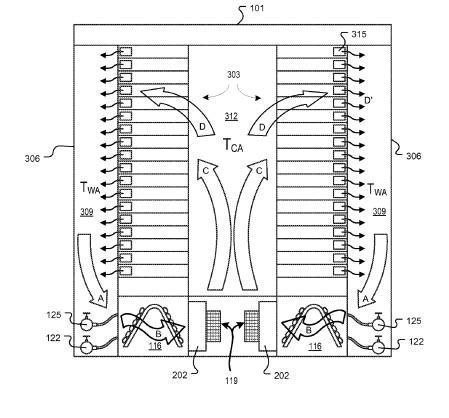

Dentro de cada contenedor de servidores en rack se basan en el principio del pasillo "frío" común. A lo largo de ella son el intercambiador de calor de suelo elevado y ventiladores que soplan aire frío a través de las tomas de aire de la parrilla a los servidores. El aire calentado desde la parte trasera de los armarios se toma bajo el suelo elevado, que pasa a través de un intercambiador de calor y se enfría, formando una recirculación. Los contenedores están equipadas con iluminación de seguridad, botones de EPO, el humo y sensores de temperatura de seguridad contra incendios.

Fig. 1. centro de datos de contenedores en Douglas

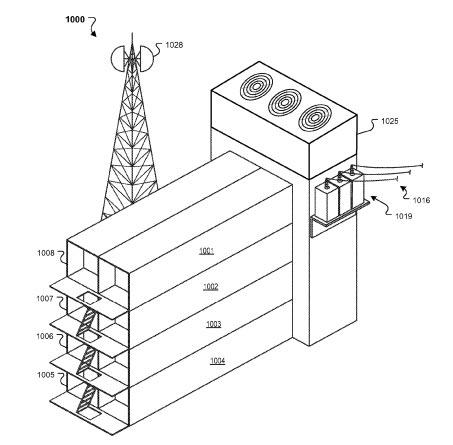

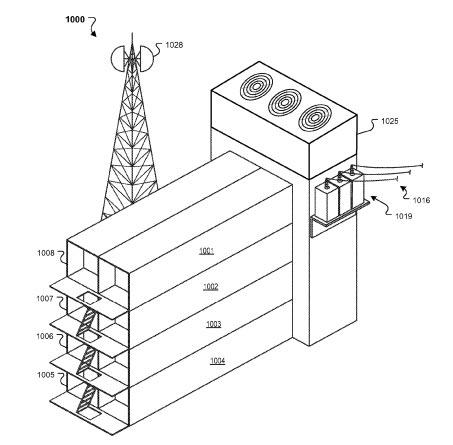

Es interesante que Google tarde patentó la idea de "torre de contenedores": los contenedores se colocan el uno del otro, por una parte organizada, y los demás - Utilidades - sistema eléctrico, aire acondicionado y un suministro de canales de comunicación externa (Fig. 2).

Fig. 2. El principio del aire de refrigeración en el contenedor

Fig. 3. Patentado "torre de contenedores»

Abrir un año más tarde, en 2006, en The Dalles (USA), a orillas del río Columbia, el centro de datos ha consistido en tres edificios separados, dos de ellas (cada área de 6 400 sq. Metros) se han erigido en el primer lugar (Figura 0.4) - se encuentran en las salas de máquinas. Cerca de estos edificios son edificios que albergan las unidades de refrigeración. El área de cada edificio - 1700 sq. metros. Además, el complejo cuenta con un edificio administrativo (1 800 sq. Metros) y un albergue para el alojamiento temporal de personal (1 500 sq. Metros).

Anteriormente, el proyecto era conocido bajo el nombre clave de Proyecto 02. Cabe señalar que el mismo lugar para el centro de datos no fue elegido por casualidad: antes de que haya funcionado capacidad de fundición de aluminio de 85 MW, que fue suspendido.

Fig. 4. La construcción de la primera fase del centro de datos en Dallas

En 2007, Google comenzó a construir un centro de datos en el suroeste de Iowa - en Council Bluffs, cerca del río Missouri. El concepto se asemeja al objeto anterior, pero hay diferencias externas: el equipo de construcción integrada y refrigeración, en lugar de torres situadas a ambos lados de la estructura principal (Fig. 5) de enfriamiento.

Fig. 5. El centro de datos en Council Bluffs - concepto típico de la construcción de los centros de datos Google

. Aparentemente, este concepto se ha tomado como las mejores prácticas, como se puede ver en el futuro. Ejemplos de esto - los centros de datos en Estados Unidos:

- Lenoir City (Carolina del Norte) Área -building de 13 000 metros cuadrados. metros; Construido en 2007-2008. (Fig. 6);

- Moncks Corner (SC) - abrió sus puertas en 2008; Se compone de dos edificios, entre los cuales el área reservada para la construcción de la tercera; tener sus propias subestaciones de alta tensión;

- Condado de Mayes (Oklahoma) es la construcción se prolongó durante tres años - 2.007 hasta 2.011; Centro de datos se llevó a cabo en dos fases - cada incluía la construcción de un área de construcción de 12 000 metros cuadrados. metros; centro de fuente de alimentación de datos es proporcionada por una planta de energía eólica.

Fig. 6. El centro de datos de Lenoir City

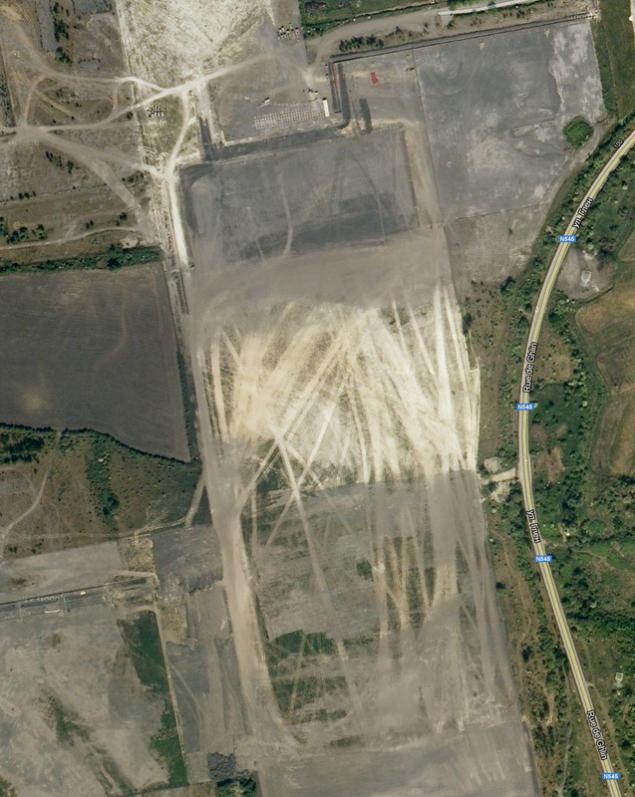

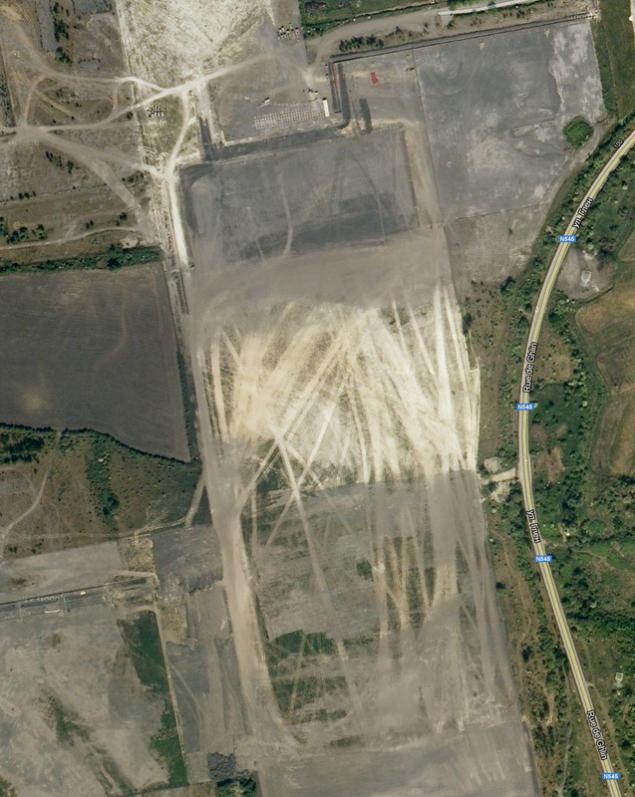

Pero la primacía de la vida privada pertenece al centro de datos en Saint-Gislene (Fig. 7a). Construido en Bélgica en el período 2007-2008. Este centro de datos es mayor que el centro de datos en Council Bluffs. Además, el centro de datos es notable por el hecho de que cuando se trata de ver los mapas de satélite de Google, en lugar se ve un área en blanco en un campo abierto (Fig. 7b). Google dice que la falta de impacto negativo en el funcionamiento del centro de datos para los pueblos de los alrededores: como gradiren de agua en el centro de datos utilizando aguas residuales tratadas. Por esta estación especial fue construido junto a una purificación de varias etapas, y el agua se suministra al canal navegable técnico de la estación.

Fig. 7a. Centro de datos en Saint-Gislene mapa de búsqueda Bing motor

Fig. 7b. Pero en Google no existe!

Google está en el proceso de construcción señaló que el agua que se utiliza para la refrigeración del lazo externo lógicamente derivada de su almacenamiento natural y no quitar el acueducto. Corporación para su futuro centro de datos adquiridos en Finlandia (Hamina), una antigua fábrica de papel, que fue reconstruida por el centro de datos (Fig. 8). El proyecto fue ejecutado en 18 meses. Su realización involucró a 50 empresas, y un acabado con éxito del proyecto se llevó a cabo en 2010. Al mismo tiempo, tal escala no fue casual: en efecto desarrollado concepto de refrigeración ha permitido a Google dijo más sobre la ecología de sus centros de datos. El clima del Norte en combinación con un bajo punto de agua salada permitido proporcionar una refrigeración sin enfriadores, utilizando sólo las bombas y los intercambiadores de calor de congelación. Utiliza la plantilla para un doble bucle "agua - agua" e intercooler. El agua de mar es bombeada, se pone en el intercambiador de calor enfría el centro de datos, y luego vierten en la bahía en el Mar Báltico.

Fig. 8. Reconstrucción de una antigua fábrica de papel en Hamina la convierte en un centro de datos

energéticamente eficiente En 2011, en la parte norte de Dublín (Irlanda) fue construido zona centro de datos de 4000 metros cuadrados. metros. Para crear un centro de datos ya existían renovado edificio de almacén aquí. Este es el más humilde de los centros de datos famosos construido como una plataforma para el despliegue de las compañías de servicios en Europa. En el mismo año se inició el desarrollo de una red de centros de datos en Asia, tres de los centros de datos deben estar disponibles en Hong Kong, Singapur y Taiwán. Y este año, Google anunció la compra de terrenos para la construcción del centro de datos en Chile.

Es de destacar que en un centro de datos de nueva construcción para Google taiwaneses han ido de una manera diferente, decidido a tomar ventaja de los beneficios económicos de nabolee más barato, electricidad nocturna tarifa. El agua en grandes tanques enfriado por unidades de refrigeración con tanques, acumuladores de frío y se utiliza para la refrigeración durante el día. Pero si hay una transición de fase del refrigerante utilizado, o la empresa se centrará sólo en el tanque con agua fría - es desconocido. Tal vez, después de entrar en el centro de datos en funcionamiento, Google proporcionará esta información.

Curiosamente, la idea polar es aún más ambicioso proyecto -plavuchy centro de datos corporativo, que en 2008 patentó Google. La patente establece que el equipo de TI se encuentra en una embarcación flotante, el enfriamiento se lleva a cabo con agua de mar fría, y la electricidad es producida por generadores flotantes, la generación de electricidad a partir del movimiento de las olas. Para el proyecto piloto utilizará un generadores de producción flotante Pelamius: 40 tales generadores, flotando en un área de 50x70 metros, permitirá producir hasta 30 megavatios de electricidad, suficiente para correr el centro de datos

.

Por cierto, Google publicará regularmente medir la eficiencia energética PUE de sus centros de datos. Y método muy interesante de medición. Si en el sentido clásico de los estándares Green Grid es la relación entre el consumo de energía del centro de datos para su capacidad de TI, Google mide el PUE de un objeto entero, incluyendo no sólo el sistema de soporte de vida del centro de datos, sino también la pérdida de conversión en los centros de transformación, los cables, el consumo de energía en la oficina . edificios y así sucesivamente d -. es decir, todo lo que se encuentra dentro del perímetro del objeto. PUE se mide como el valor medio durante un período de un año. A partir de 2012 el PUE promedio para todos los centros de datos de Google era 1.13.

Características de la construcción del centro de datos de la selección del sitio

En realidad, es evidente que mediante la construcción de tan enormes centros de datos, su localización seleccionada por Google no es accidental. ¿Cuáles son los criterios toman en cuenta principalmente los especialistas de la empresa?

1. electricidad barata suficiente, la posibilidad de su oferta y su origen limpio. La adhesión a la política de preservación del medio ambiente, la empresa utiliza fuentes de energía renovables, como un centro de datos grande Google consume alrededor de 50 a 60 MW - suficiente de ser el único cliente en toda la planta. Por otra parte, las energías renovables pueden ser independientes de los precios energéticos. Actualmente hay parques de turbinas hidroeléctricas y eólicas.

2. La presencia de grandes cantidades de agua que pueden ser utilizados para la refrigeración. Esto puede ser un canal o un cuerpo natural de agua.

3. La presencia de zonas de amortiguamiento entre carreteras y asentamientos para la construcción de perímetro vigilado y mantener la máxima privacidad del sujeto. Al mismo tiempo que se requiere para las rutas normales de transporte hasta el centro de datos.

4. El área de terreno que se compró para la construcción de centros de datos, debe permitir su expansión y construcción de edificios auxiliares o su propia electricidad renovable.

5. Los canales de comunicación. Debe haber pocos, y que deben ser protegidos. Este requisito se ha vuelto particularmente importante tras el fracaso de los canales regulares de los problemas de comunicación en el centro de datos ubicado en Oregón (EE.UU.). Conexión aérea pasó a lo largo de las líneas eléctricas, aisladores en la que los cazadores locales que se convierten en una especie de objetivo para el rodaje de las competiciones. Por lo tanto, en relación con el centro de datos de la temporada de caza constantemente se interrumpió, y su recuperación llevó mucho tiempo y una fuerza considerable. Al final, hemos resuelto el problema, allanando el enlace subterráneo.

6. Los incentivos fiscales. El requisito lógico, teniendo en cuenta que el uso de "tecnologías verdes" son mucho más caros que los tradicionales. En consecuencia, el cálculo de las reducciones de impuestos de retorno debería reducir los costos ya elevados de capital para la primera fase. Fig. 9. Modelo "Spartan" servidor de Google - nada más

Todos los servidores están instalados en 40 pulgadas, bastidores abiertos de dos de guillotina que se colocan en serie con un pasillo "frío" común. Curiosamente, el centros de datos de Google no utiliza estructuras especiales para limitar el "frío" del corredor, y los usos bisagras listones de plástico móviles rígidas, diciendo que es una solución sencilla y económica para instalar de forma rápida más en las filas existentes de gabinetes y, si es necesario, para reducir laminillas existente sobre la parte superior del gabinete.

Se sabe que, además de la hardware, Google utiliza un sistema de archivos del sistema de archivos Google (GFS), destinados a grandes conjuntos de datos. La peculiaridad de este sistema es que es un clúster: la información se divide en bloques de 64 Mbytes y se almacena en al menos tres lugares al mismo tiempo, con la posibilidad de encontrar la copia replicada. Si alguno de los sistemas falla, las copias replicadas están utilizando de forma automática especializada modelo de software MapReduce. El modelo en sí implica operaciones rasparallelirovanie y realizar tareas en varios equipos simultáneamente. Cuando esta información se encripta en el interior del sistema. Sistema BigTable utiliza distribuye matrices de almacenamiento para almacenar grandes cantidades de información con un rápido acceso a almacenamiento, como la indexación web, Google Earth y Google Finance. Como una aplicación web básica utiliza Google Web Server (GWS) y Google Front-End (GFE), utilizando un núcleo optimizada de Apache. Todos estos sistemas son propiedad exclusiva y personalizada - Google explica por el hecho de que los sistemas privados y personalizados son muy estables frente a los ataques externos y las vulnerabilidades son mucho menos

.

Lo tengo todo. Pido disculpas por la demora, un poco confundido en el post :)

Fuente:

Fuente

En realidad, Google Inc. ha sido ninguna sorpresa los poderosos dinámica de su crecimiento. Un activista activo de "energía verde", muchas patentes en varios campos, abiertas y amistosas hacia los usuarios - éstas son las primeras asociaciones que se presentan ante la mención de Google para muchos. No menos impresionante y centro de datos (data center o centro de datos) de la empresa: Se trata de una red de centros de datos colocados en todo el mundo, el moschnostyu220 total de MW (a partir del año pasado). Dado el hecho de que la inversión en centros de datos sólo el año pasado ascendió a 2, 5 millones de dólares, está claro que la empresa considera que es de importancia estratégica dirección y prometedor. Al mismo tiempo, hay una especie de contradicción dialéctica, porque, a pesar de la publicidad de la empresa Google, sus centros de datos son el tipo de conocimiento secreto, oculto tras siete sellos. La compañía cree que la divulgación de los detalles del proyecto puede ser utilizado por los competidores, por lo tanto, sólo una parte de la información sobre las soluciones más avanzadas se filtran en las masas, pero incluso esta información es muy interesante.

Vamos a empezar con el hecho de que el propio Google no está directamente involucrado en la construcción del centro de datos. Él tiene un departamento que se ocupa del desarrollo y mantenimiento, y la compañía trabaja con integradores locales que hacen la introducción. La cantidad exacta de centro de datos construido no se anuncia, pero oprima su número varía de 35 a 40 en todo el mundo. La principal concentración de centros de datos representó los Estados Unidos, Europa occidental y Asia oriental. Además, algunos de los equipos ubicados en locales arrendados de centro de datos comercial, tener buenos canales de comunicación. Se sabe que Google utiliza el espacio para acomodar el equipo de centros de datos comercial Equinix (EQIX) y Savvis (SVVS). Google pretende cambiar estratégicamente exclusivamente a la utilización de sus propios centros de datos - la corporación se atribuye a la creciente demanda de privacidad de los usuarios que confían en nosotros, y fugas, inevitablemente, en los centros de datos comerciales. Siguiendo las últimas tendencias, este verano se anunció que Google ofrecerá alquiler de infraestructuras "nube" a terceras empresas y desarrolladores un modelo apropiado IaaS de servicio Compute Engine, que proporcionará la potencia de cálculo de una configuración fija con un pago por el uso por hora.

La característica principal de la red de centros de datos no es tanto en la fiabilidad de un único centro de datos, como en el geo-agrupación. Cada centro de datos tiene un montón de enlaces de comunicación de alta capacidad con el mundo exterior y replica sus datos a otros centros de datos, distribuidos geográficamente en todo el mundo. Por lo tanto, incluso una fuerza mayor, como meteoritos no afectó sustancialmente la seguridad de los datos. Centros de datos Geografía

El primer centro de datos públicos se encuentra en Douglas, Estados Unidos. Este centro de datos de contenedores (Fig. 1) se inauguró en 2005. El mismo centro de datos es el más público. De hecho, es una especie de estructura de trama, que se asemeja a un hangar, en cuyo interior están dispuestos en dos filas de contenedores. En una serie - 15 contenedores dispuestos en una capa y en el segundo - 30 contenedores dispuestos en dos niveles. Este centro de datos es de aproximadamente 45.000 servidores de Google. Contenedores - mar 20 pies. Por el momento, el trabajo puesto en los contenedores de 45, y el poder de los equipos informáticos es de 10 MW. Cada contenedor tiene su propia conexión con el circuito hidráulico de enfriamiento de una unidad de distribución de energía - que tiene, además de los interruptores automáticos y analizadores tiene el consumo de electricidad de los grupos de consumidores eléctricos para calcular el coeficiente de PUE. Estaciones de bombeo separado ubicados, cascadas de enfriadores, grupos electrógenos diesel y transformadores. Declarado PUE, igual a 1,25. Sistema de refrigeración - dual, mientras que el segundo bucle con economizadores torres de refrigeración utilizados, puede reducir significativamente el tiempo de funcionamiento de la unidad. De hecho, es nada más que una torre de refrigeración abierta. El agua absorbe el calor desde el servidor, se suministra a la parte superior de la torre, donde pulverizada y fluye hacia abajo. Debido a la disipación de calor del agua se transfiere al aire, que se sopla por los ventiladores desde el exterior, y la propia agua se vaporiza parcialmente. Esta solución reduce significativamente el tiempo de enfriadores en el centro de datos. Curiosamente, en un principio para la reposición de agua en el circuito externo para utilizar el agua del grifo purificada es apta para el consumo. En Google de pronto se dieron cuenta de que el agua no tiene por qué ser tan limpio, por lo que el sistema se estableció, la limpieza de las aguas residuales de las instalaciones de tratamiento cercanas y repoblación del agua en el circuito de refrigeración externo.

Dentro de cada contenedor de servidores en rack se basan en el principio del pasillo "frío" común. A lo largo de ella son el intercambiador de calor de suelo elevado y ventiladores que soplan aire frío a través de las tomas de aire de la parrilla a los servidores. El aire calentado desde la parte trasera de los armarios se toma bajo el suelo elevado, que pasa a través de un intercambiador de calor y se enfría, formando una recirculación. Los contenedores están equipadas con iluminación de seguridad, botones de EPO, el humo y sensores de temperatura de seguridad contra incendios.

Fig. 1. centro de datos de contenedores en Douglas

Es interesante que Google tarde patentó la idea de "torre de contenedores": los contenedores se colocan el uno del otro, por una parte organizada, y los demás - Utilidades - sistema eléctrico, aire acondicionado y un suministro de canales de comunicación externa (Fig. 2).

Fig. 2. El principio del aire de refrigeración en el contenedor

Fig. 3. Patentado "torre de contenedores»

Abrir un año más tarde, en 2006, en The Dalles (USA), a orillas del río Columbia, el centro de datos ha consistido en tres edificios separados, dos de ellas (cada área de 6 400 sq. Metros) se han erigido en el primer lugar (Figura 0.4) - se encuentran en las salas de máquinas. Cerca de estos edificios son edificios que albergan las unidades de refrigeración. El área de cada edificio - 1700 sq. metros. Además, el complejo cuenta con un edificio administrativo (1 800 sq. Metros) y un albergue para el alojamiento temporal de personal (1 500 sq. Metros).

Anteriormente, el proyecto era conocido bajo el nombre clave de Proyecto 02. Cabe señalar que el mismo lugar para el centro de datos no fue elegido por casualidad: antes de que haya funcionado capacidad de fundición de aluminio de 85 MW, que fue suspendido.

Fig. 4. La construcción de la primera fase del centro de datos en Dallas

En 2007, Google comenzó a construir un centro de datos en el suroeste de Iowa - en Council Bluffs, cerca del río Missouri. El concepto se asemeja al objeto anterior, pero hay diferencias externas: el equipo de construcción integrada y refrigeración, en lugar de torres situadas a ambos lados de la estructura principal (Fig. 5) de enfriamiento.

Fig. 5. El centro de datos en Council Bluffs - concepto típico de la construcción de los centros de datos Google

. Aparentemente, este concepto se ha tomado como las mejores prácticas, como se puede ver en el futuro. Ejemplos de esto - los centros de datos en Estados Unidos:

- Lenoir City (Carolina del Norte) Área -building de 13 000 metros cuadrados. metros; Construido en 2007-2008. (Fig. 6);

- Moncks Corner (SC) - abrió sus puertas en 2008; Se compone de dos edificios, entre los cuales el área reservada para la construcción de la tercera; tener sus propias subestaciones de alta tensión;

- Condado de Mayes (Oklahoma) es la construcción se prolongó durante tres años - 2.007 hasta 2.011; Centro de datos se llevó a cabo en dos fases - cada incluía la construcción de un área de construcción de 12 000 metros cuadrados. metros; centro de fuente de alimentación de datos es proporcionada por una planta de energía eólica.

Fig. 6. El centro de datos de Lenoir City

Pero la primacía de la vida privada pertenece al centro de datos en Saint-Gislene (Fig. 7a). Construido en Bélgica en el período 2007-2008. Este centro de datos es mayor que el centro de datos en Council Bluffs. Además, el centro de datos es notable por el hecho de que cuando se trata de ver los mapas de satélite de Google, en lugar se ve un área en blanco en un campo abierto (Fig. 7b). Google dice que la falta de impacto negativo en el funcionamiento del centro de datos para los pueblos de los alrededores: como gradiren de agua en el centro de datos utilizando aguas residuales tratadas. Por esta estación especial fue construido junto a una purificación de varias etapas, y el agua se suministra al canal navegable técnico de la estación.

Fig. 7a. Centro de datos en Saint-Gislene mapa de búsqueda Bing motor

Fig. 7b. Pero en Google no existe!

Google está en el proceso de construcción señaló que el agua que se utiliza para la refrigeración del lazo externo lógicamente derivada de su almacenamiento natural y no quitar el acueducto. Corporación para su futuro centro de datos adquiridos en Finlandia (Hamina), una antigua fábrica de papel, que fue reconstruida por el centro de datos (Fig. 8). El proyecto fue ejecutado en 18 meses. Su realización involucró a 50 empresas, y un acabado con éxito del proyecto se llevó a cabo en 2010. Al mismo tiempo, tal escala no fue casual: en efecto desarrollado concepto de refrigeración ha permitido a Google dijo más sobre la ecología de sus centros de datos. El clima del Norte en combinación con un bajo punto de agua salada permitido proporcionar una refrigeración sin enfriadores, utilizando sólo las bombas y los intercambiadores de calor de congelación. Utiliza la plantilla para un doble bucle "agua - agua" e intercooler. El agua de mar es bombeada, se pone en el intercambiador de calor enfría el centro de datos, y luego vierten en la bahía en el Mar Báltico.

Fig. 8. Reconstrucción de una antigua fábrica de papel en Hamina la convierte en un centro de datos

energéticamente eficiente En 2011, en la parte norte de Dublín (Irlanda) fue construido zona centro de datos de 4000 metros cuadrados. metros. Para crear un centro de datos ya existían renovado edificio de almacén aquí. Este es el más humilde de los centros de datos famosos construido como una plataforma para el despliegue de las compañías de servicios en Europa. En el mismo año se inició el desarrollo de una red de centros de datos en Asia, tres de los centros de datos deben estar disponibles en Hong Kong, Singapur y Taiwán. Y este año, Google anunció la compra de terrenos para la construcción del centro de datos en Chile.

Es de destacar que en un centro de datos de nueva construcción para Google taiwaneses han ido de una manera diferente, decidido a tomar ventaja de los beneficios económicos de nabolee más barato, electricidad nocturna tarifa. El agua en grandes tanques enfriado por unidades de refrigeración con tanques, acumuladores de frío y se utiliza para la refrigeración durante el día. Pero si hay una transición de fase del refrigerante utilizado, o la empresa se centrará sólo en el tanque con agua fría - es desconocido. Tal vez, después de entrar en el centro de datos en funcionamiento, Google proporcionará esta información.

Curiosamente, la idea polar es aún más ambicioso proyecto -plavuchy centro de datos corporativo, que en 2008 patentó Google. La patente establece que el equipo de TI se encuentra en una embarcación flotante, el enfriamiento se lleva a cabo con agua de mar fría, y la electricidad es producida por generadores flotantes, la generación de electricidad a partir del movimiento de las olas. Para el proyecto piloto utilizará un generadores de producción flotante Pelamius: 40 tales generadores, flotando en un área de 50x70 metros, permitirá producir hasta 30 megavatios de electricidad, suficiente para correr el centro de datos

.

Por cierto, Google publicará regularmente medir la eficiencia energética PUE de sus centros de datos. Y método muy interesante de medición. Si en el sentido clásico de los estándares Green Grid es la relación entre el consumo de energía del centro de datos para su capacidad de TI, Google mide el PUE de un objeto entero, incluyendo no sólo el sistema de soporte de vida del centro de datos, sino también la pérdida de conversión en los centros de transformación, los cables, el consumo de energía en la oficina . edificios y así sucesivamente d -. es decir, todo lo que se encuentra dentro del perímetro del objeto. PUE se mide como el valor medio durante un período de un año. A partir de 2012 el PUE promedio para todos los centros de datos de Google era 1.13.

Características de la construcción del centro de datos de la selección del sitio

En realidad, es evidente que mediante la construcción de tan enormes centros de datos, su localización seleccionada por Google no es accidental. ¿Cuáles son los criterios toman en cuenta principalmente los especialistas de la empresa?

1. electricidad barata suficiente, la posibilidad de su oferta y su origen limpio. La adhesión a la política de preservación del medio ambiente, la empresa utiliza fuentes de energía renovables, como un centro de datos grande Google consume alrededor de 50 a 60 MW - suficiente de ser el único cliente en toda la planta. Por otra parte, las energías renovables pueden ser independientes de los precios energéticos. Actualmente hay parques de turbinas hidroeléctricas y eólicas.

2. La presencia de grandes cantidades de agua que pueden ser utilizados para la refrigeración. Esto puede ser un canal o un cuerpo natural de agua.

3. La presencia de zonas de amortiguamiento entre carreteras y asentamientos para la construcción de perímetro vigilado y mantener la máxima privacidad del sujeto. Al mismo tiempo que se requiere para las rutas normales de transporte hasta el centro de datos.

4. El área de terreno que se compró para la construcción de centros de datos, debe permitir su expansión y construcción de edificios auxiliares o su propia electricidad renovable.

5. Los canales de comunicación. Debe haber pocos, y que deben ser protegidos. Este requisito se ha vuelto particularmente importante tras el fracaso de los canales regulares de los problemas de comunicación en el centro de datos ubicado en Oregón (EE.UU.). Conexión aérea pasó a lo largo de las líneas eléctricas, aisladores en la que los cazadores locales que se convierten en una especie de objetivo para el rodaje de las competiciones. Por lo tanto, en relación con el centro de datos de la temporada de caza constantemente se interrumpió, y su recuperación llevó mucho tiempo y una fuerza considerable. Al final, hemos resuelto el problema, allanando el enlace subterráneo.

6. Los incentivos fiscales. El requisito lógico, teniendo en cuenta que el uso de "tecnologías verdes" son mucho más caros que los tradicionales. En consecuencia, el cálculo de las reducciones de impuestos de retorno debería reducir los costos ya elevados de capital para la primera fase. Fig. 9. Modelo "Spartan" servidor de Google - nada más

Todos los servidores están instalados en 40 pulgadas, bastidores abiertos de dos de guillotina que se colocan en serie con un pasillo "frío" común. Curiosamente, el centros de datos de Google no utiliza estructuras especiales para limitar el "frío" del corredor, y los usos bisagras listones de plástico móviles rígidas, diciendo que es una solución sencilla y económica para instalar de forma rápida más en las filas existentes de gabinetes y, si es necesario, para reducir laminillas existente sobre la parte superior del gabinete.

Se sabe que, además de la hardware, Google utiliza un sistema de archivos del sistema de archivos Google (GFS), destinados a grandes conjuntos de datos. La peculiaridad de este sistema es que es un clúster: la información se divide en bloques de 64 Mbytes y se almacena en al menos tres lugares al mismo tiempo, con la posibilidad de encontrar la copia replicada. Si alguno de los sistemas falla, las copias replicadas están utilizando de forma automática especializada modelo de software MapReduce. El modelo en sí implica operaciones rasparallelirovanie y realizar tareas en varios equipos simultáneamente. Cuando esta información se encripta en el interior del sistema. Sistema BigTable utiliza distribuye matrices de almacenamiento para almacenar grandes cantidades de información con un rápido acceso a almacenamiento, como la indexación web, Google Earth y Google Finance. Como una aplicación web básica utiliza Google Web Server (GWS) y Google Front-End (GFE), utilizando un núcleo optimizada de Apache. Todos estos sistemas son propiedad exclusiva y personalizada - Google explica por el hecho de que los sistemas privados y personalizados son muy estables frente a los ataques externos y las vulnerabilidades son mucho menos

.

Lo tengo todo. Pido disculpas por la demora, un poco confundido en el post :)

Fuente: