913

Серце імперії Google

Багато людей знають багатогранну природу Google – це популярний пошуковий двигун і соціальна мережа, а також безліч інших корисних і інноваційних послуг. Але мало хто заданий: як компанія керувала розгортанням і підтримує їх з такою високою ефективністю і толерантністю до відмов? Як це організовано, що надає такі можливості – Центр даних Google, які його особливості? Це те, що буде розглянуто в цій статті.

Джерело

Не дивлячись на те, що Google довго дивує потужну динаміку зростання. Активний винищувач для «зеленої енергії», багато патентів в різних сферах, відкритості та дружніх до користувачів є першими асоціаціями, які виникають, коли багато хто згадує Google. Не менш вражаючим є дата-центр (центр даних або центр даних) компанії: це ціла мережа центрів обробки даних, розташованих по всьому світу, загальною потужністю 220 МВт (в минулому році). З огляду на те, що інвестиції в дата-центри за минулий рік окремо склали $ 2,5 млрд, зрозуміло, що компанія вважає стратегічно важливим і перспективним. У той же час є діалектична суперечність, тому що, незважаючи на публічність діяльності Google, його центри даних є своєрідним, як відомо, секрет, прихованим за семи печаток. Компанія вважає, що розкриття деталей проекту може бути використана конкурентами, тому лише частина інформації про найбільш прогресивні рішення, які витікають на громадськість, але навіть ця інформація дуже цікава.

Щоб розпочати роботу, Google не будує центрів обробки даних. Має відділ, який займається розробкою та обслуговуванням, а компанія співпрацює з місцевими інтеграторами, які здійснюють впровадження. Точна кількість центрів обробки даних не рекламується, але в пресі їх кількість коливається від 35 до 40 по всьому світу. Основна концентрація дата-центрів падає на Сполучених Штатах, Західній Європі та Східній Азії. Крім того, в оренду приміщення торгових центрів з хорошими каналами зв'язку знаходиться окреме обладнання. Відомо, що Google використовувало простір для дому обладнання центрів комерційної інформації Equinix (EQIX) та Саввіс (SVVS). Google є стратегічно орієнтованим на перемикання виключно до використання власних центрів обробки даних - корпорація пояснює це зростаючими вимогами до конфіденційності інформації користувачів, які довіряють компанії, і неминучість витоку інформації в комерційних дата-центрах. Після останніх тенденцій, влітку цього року було оголошено, що Google надасть можливість «закрити» інфраструктуру для сторонніх компаній і розробників, що відповідає моделі сервісу Compute Engine IaaS, яка забезпечить обчислювальну потужність для фіксованих конфігурацій з погодинною виплатою за використання.

Головною особливістю мережі центрів обробки даних не так багато в високій надійності єдиного центру даних, як в геодезингу. Кожен центр даних має багато каналів зв'язку високої чіткості з зовнішнім світом і реплікує його дані в кілька інших центрів обробки даних, що географічно розподілені по всьому світу. Таким чином, навіть форс-мажорний вплив такого типу, як метаоритний вплив не істотно впливає на безпеку даних. Географія центрів даних

Центр публічних даних знаходиться в місті Дуглас, США. Цей центр даних контейнерів (Figure 1) був відкритий у 2005 році. Цей центр даних є найбільш громадським. По суті, це різновид каркасної конструкції, що нагадує ангар, всередині якого контейнери розташовуються в двох рядах. В одному ряду - 15 контейнерів, розташованих в одному ярусі, і в другому - 30 контейнерів, розташованих в двох ярусах. Центр даних налічує близько 45,000 серверів Google. Контейнери - 20-фут марин. На сьогоднішній день введено в експлуатацію 45 контейнерів, а потужність ІТ-обладнання – 10 МВт. Кожен контейнер має власний зв'язок з гідравлічним охолодженням, власний блок розподілу потужності - він має, крім автоматичних вимикачів, також аналізаторів споживання електроенергії споживчих груп для розрахунку коефіцієнта PUE. Окремо розташовані насосні станції, каскади охолоджувача, дизель-генератори та трансформатори. Оголошено ПЮ 1.25. Система охолодження є двоконтурним, при цьому в другому контурі використовуються економайзери з охолоджувальними вежами, що значно зменшує час роботи охолоджувачів. По суті, це нічого більше, ніж відкрита вежа охолодження. Вода, яка виводить тепло з серверної кімнати, подається до вершини вежі, звідки вона обприскується і зливається вниз. У зв'язку з поливом води тепло передається в повітря, який відкачується ззовні вентиляторами, а сама вода частково випаровується. Це рішення значно знижує час охолоджувачів в центрі даних. Цікаво, що спочатку очищена вода для пиття була використана для поповнення запасів води в зовнішньому контурі. Google швидко зрозумів, що вода не повинна бути такою чистою, тому система була створена для лікування стічних вод з сусідніх очисних установок і поповнення води в зовнішньому охолодженні.

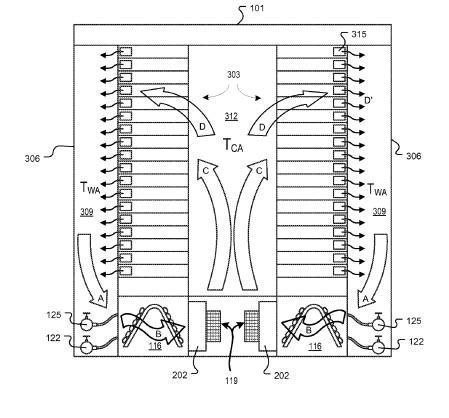

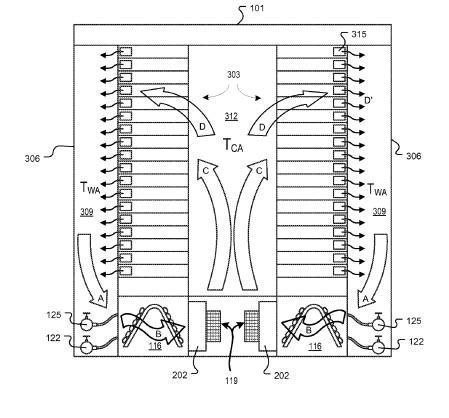

Всередині кожен контейнер, стійки з серверами будуються за принципом загального холодного коридору. Під ним під помилковим підлогою є теплообмінник і вентилятори, які продувають охолоджене повітря через решітки на серверні впуски. Нагрівається повітря від задньої частини шаф проводиться під хибним підлогою, проходить через теплообмінник і охолоджується, утворюючи переробка. Контейнери обладнані аварійним освітленням, кнопками EPO, датчиками диму та температури пожежної безпеки.

Рис. 1. Центр контейнерних даних у Дуглас

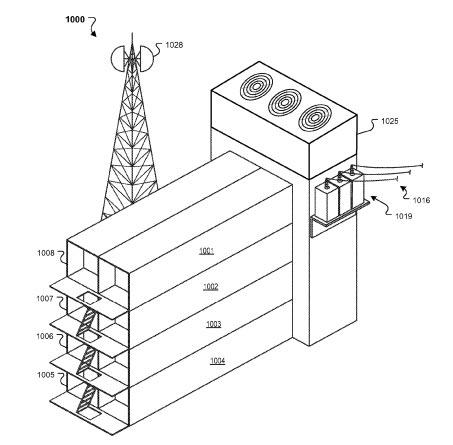

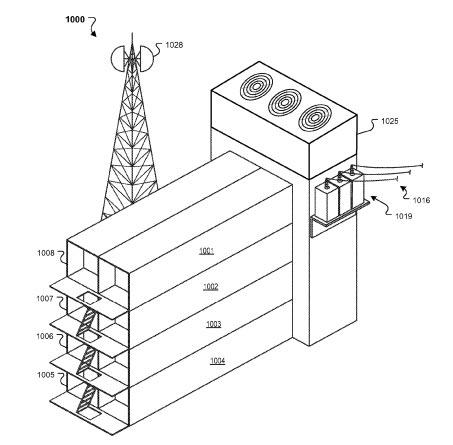

Цікаво, що Google згодом запатентував ідею «контейнерної башти»: контейнери розміщені на вершині один одного, з одного боку, організований вхід, а з іншого - інженерних комунікацій - систем електропостачання, кондиціонування та зовнішніх каналів зв'язку (рис. 2).

Рис. 2. Принцип повітряного охолодження в контейнері

Рис. 3. Запатентована «Контейнерна вежа»

Відкрито рік пізніше, в 2006 році, в Дуллесах (США), на березі річки Колумбії, дата-центр вже складався з трьох відокремлених будівель, два з яких (все з площею 6,400 кв.м) були побудовані в першу чергу (рис. 4) – вони розташовані машинні приміщення. Поруч з цими будівлями є споруди, які холодильні установки будинку. Площа кожної будівлі становить 1 700 кв.м. Крім того, у комплексі є адміністративна будівля (1,800 кв.м) та гуртожиток на тимчасове розміщення персоналу (1,500 кв.м).

Проект був раніше відомий як Project 02. Слід зазначити, що розташування для центру даних не було обрано шансом: перед тим, що тут функціонують алюмінієвий плавак потужністю 85 МВт, робота якого була призупинена.

Рис. 4. Будівництво першої фази центру даних у Далласі

У 2007 році Google почав будувати центр даних на південно-західному Іові, в округу Брюффс, біля річки Міссурі. Концепція нагадує попередній об'єкт, але є зовнішні відмінності: будівлі поєднуються, а холодильне обладнання замість охолоджувальних башт розташоване по обидва боки основної конструкції (рис. 5).

Рис. 5. Центр даних в Повітровому Бюфф є типовим поняттям для побудови центрів обробки даних Google.

У майбутньому ця концепція була прийнята як найкраща практика, оскільки вона може бути простежена в майбутньому. До прикладів відносяться дата-центри США:

Lenoir City (Північна Кароліна) – будівля площею 13,000 кв.м; побудована в 2007-2008 рр. (Фігура 6);

- Монкс Кукурудза (Південна Кароліна) - відкрита в 2008 році; складається з двох будівель, між якими зарезервований сайт для будівництва третьої; наявність власної високовольтної підстанції;

— Майес Каун (Оклахома) — будівництво затримало протягом трьох років — з 2007 по 2011 рік; центр даних був реалізований на двох стадіях — кожен включив будівництво будівлі площею 12,000 кв.м; блок живлення до центру даних забезпечує вітроелектростанція.

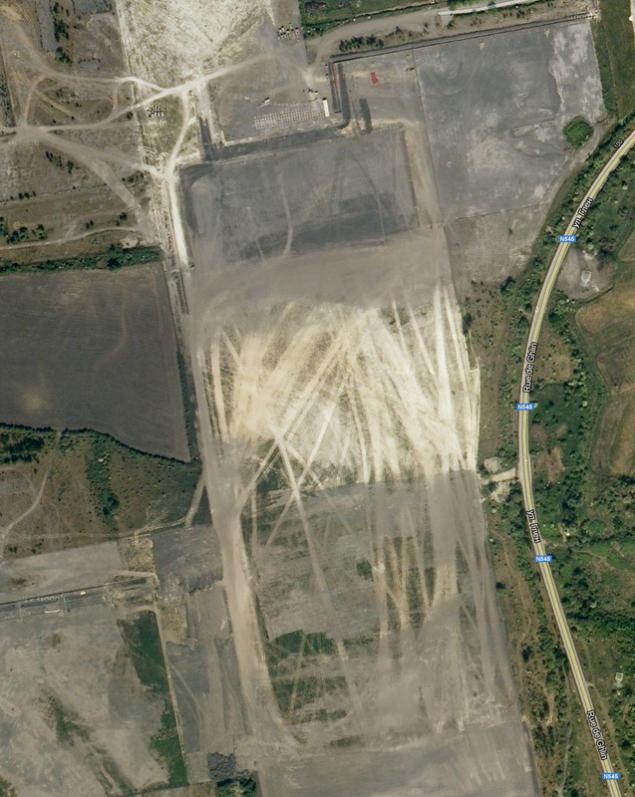

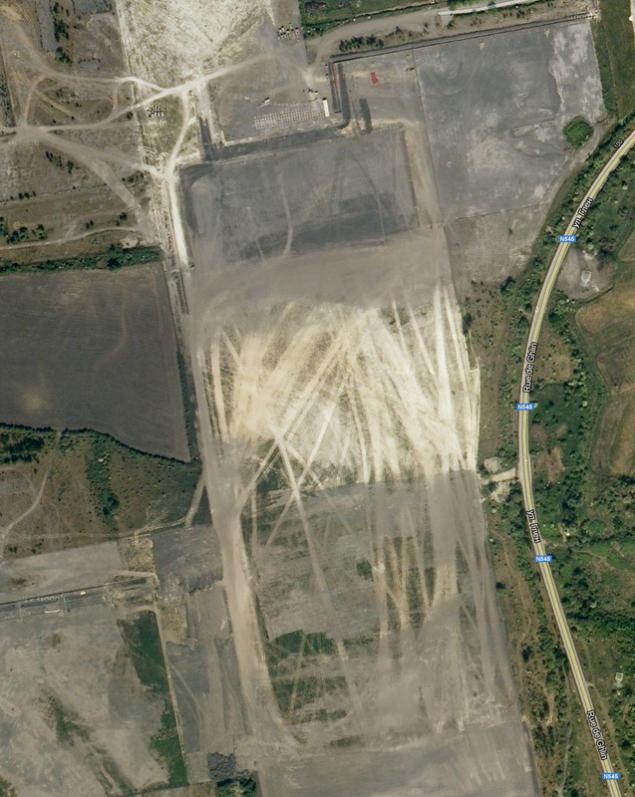

Рис. 6. Центр даних в м. Леноір

Але першість секретності відноситься до центру даних у Сент-Гіслані (рис 7а). Побудований в Бельгії між 2007 і 2008, цей центр даних більше, ніж центр даних в County Bluff. Крім того, цей центр даних не вдається в тому, що коли ви намагаєтеся переглянути супутникову карту Google, замість цього ви побачите порожню площу в порожній полі (рис. 7б). Google каже, що не існує негативного впливу на роботу цього центру даних на навколишні населені пункти: оброблені стічних вод використовуються як вода для охолодження вежі в дата-центрі. З цією метою було побудовано спеціальну багатоступеневу очисну станцію, а вода додається до станції через технічний канал.

Рис. 7а. Центр даних у Сент-Гіслані на карті пошукової системи

Рис. 7б. Не існує на Google Maps!

Фахівці Google в процесі будівництва відзначили, що вода, яка використовується для охолодження зовнішньої схеми, логічно буде отримувати від природного сховища, а не приймати з водопостачання. Корпорація для свого майбутнього дата-центру набула старої паперової фабрики у Фінляндії (Гаміна), яка була реконструйована як дата-центр (Фігура 8). Проект проводився протягом 18 місяців. 50 компаній взяли участь у його реалізації, а успішне завершення проекту відбулося в 2010 році. У той же час ця вага не випадково: розроблена концепція охолодження дійсно дозволила Google заявити екологічність своїх центрів обробки даних. У північному кліматі поєднаний з низькою температурою заморожування солі допускається охолодження без охолоджувачів, використовуючи тільки насоси і теплообмінники. Тут використовується типова схема з подвійним водяним контуром та проміжним теплообмінником. Морська вода перекачується в теплообмінники, охолоджує центр даних, а потім викидається в бухту Балтійського моря.

р.

р.

Рис. 8. Реконструкція старої паперової фабрики в Hamina перетворює її в енергоефективний центр даних

У 2011 році в Північній частині Дубліна було побудовано 4000-квадро-метровий центр даних. Для створення дата-центру було відновлено складське приміщення, яке вже існувало тут. Це найбільш скромні відомі дата-центри, побудовані в якості ярлика для розгортання послуг компанії в Європі. У цьому ж році почалася розробка мережі центрів обробки даних в Азії, з трьома дата-центрами, які з'являються в Гонконгі, Сінгапурі та Тайвані. У цьому році Google оголосила про купівлю земельних ділянок для побудови центру даних в Чилі.

Зауважте, що в дата-центрі під будівництвом в Тайвані фахівці Google прийняли різний шлях, позбавляючи скористатися економічними перевагами дешевого, нічного тарифу електроенергії. Вода в величезних резервуарах охолоджується охолоджувачем з холодними баками і використовується для охолодження в денний час. Але чи буде використовуватися фазовий перехід теплоносія, або компанія зупиниться тільки на резервуарі з охолодженою водою. Можливо, після введення в експлуатацію центру даних Google надасть цю інформацію.

Цікаво, що полярна ідея – це навіть болдерний проект корпорації – плаваючий центр даних, який був запатентований Google у 2008 році. Патент стверджує, що ІТ-обладнання знаходиться на плаваючому посуді, охолодження здійснюється холодною офшорною водою, а електрика виробляється плаваючими генераторами, які генерують електроенергію з руху хвиль. Для пілотного проекту планується використовувати плаваючі генератори виробництва Pelamius: 40 таких генераторів, що пливуть на площу 50х70 метрів, виготовлять до 30 МВт електроенергії, достатній для експлуатації центру даних.

Google регулярно публікує PUE своїх центрів обробки даних. Сам метод вимірювання цікавий. Якщо в класичному розумінні Green Grid стандарти є співвідношення споживання енергії центру даних до його ІТ-мережі, то Google запускає PUE в цілому для об'єкта, в тому числі не тільки системи підтримки життя даних, але і перетворення втрат у трансформаторних підстанціях, кабелів, споживання електроенергії в офісних просторах і т.д. – це, все, що всередині периметру об'єкта. Вимірюваний PUE дається як середнє значення за щорічний період. Станом на 2012 рік, середнє PUE по всіх дата-центрах Google було 1.13.

Особливості вибору місця для побудови центру даних

По суті, зрозуміло, що при побудові таких величезних центрів обробки даних, їх розташування не вибрано Google. Які критерії враховуються фахівці компанії?

1,1 км Визначте дешеву електрику, можливість її постачання та екологічно чистого походження. У зв'язку з їх прихильністю до навколишнього середовища компанія використовує відновлювані джерела енергії, оскільки один великий центр даних Google споживає близько 50-60 МВт – достатньо бути єдиним клієнтом всієї електростанції. Крім того, відновлювані джерела можуть бути незалежними від цін на електроенергію. В даний час використовуються гідроелектростанції та вітроелектростанції.

2,2 км Велика кількість води, яку можна використовувати для охолодження. Це може бути як канал, так і натуральне тіло води.

3. У Наявність буферних зон між дорогами і населеними пунктами для побудови захищеного периметра і збереження максимальної конфіденційності об'єкта. У той же час автомагістралі необхідні для нормального транспортного сполучення з центром даних.

4. У Площа земельних ділянок, придбаних для будівництва дата-центрів, повинна забезпечити подальше розширення та будівництво допоміжних будівель або власних відновлюваних джерел енергії.

5. Умань Контакти З них слід мати кілька, і вони повинні бути захищені. Ця вимога стала особливо актуальною після регулярних проблем втрати каналів зв'язку в дата-центрі, розташованому в Орегоні (США). Повітряні лінії зв'язку пропускаються через силові лінії, ізолятори, на які стали для місцевих мисливців, які, як цілі для зйомки змагань. Таким чином, під час мисливського сезону зв'язок з дата-центром було постійно вирізати, і було багато часу і значних зусиль для відновлення. У результаті проблема була вирішена шляхом укладання підземних комунікаційних ліній.

6. Жнівень Податкові перерви. За умови, що використання «зелених технологій» значно дорожчі, ніж традиційні. Відповідно, при розрахунку повернення коштів, податкові пільги повинні зменшити вже високі капітальні витрати на першому етапі. Рис. 9. типовий Спартанний сервер Google нічого зайвого

Всі сервери встановлюються в 40-дюймових дворамних відкритих стійках, які розміщені в рядках з загальним «холодним» коридором. Цікаво, в дата-центрах Google не використовує спеціальні конструкції для обмеження «холодного» коридору, але використовує навісні жорсткі знімні полімерні ламелі, що робить це простим і вигідним рішенням, що дозволяє дуже швидко встановлювати шафи в існуючі рядки і при необхідності складати існуючі ламелі над верхнім шафою.

Крім апаратного забезпечення, Google використовує файлову систему Google (GFS), яка призначена для великих обсягів даних. Особливість цієї системи полягає в тому, що вона кластерована: інформація розділена на блоки 64 Мб і зберігається в принаймні трьох місцях одночасно з можливістю пошуку копійки примірників. Якщо будь-який з систем не виходить, копії автоматично розміщуються за допомогою спеціалізованих програм моделі MapReduce. Сама модель передбачає паралельні роботи і виконання завдань на декількох машинах одночасно. Інформація зашифрована всередині системи. BigTable використовує розподілені сховища для зберігання великої кількості інформації з швидким доступом для зберігання, таких як індексація веб-сайтів, Google Earth та Google Finance. Основні веб-додатки Google Web Server (GWS) і Google Front-End (GFE), які використовують оптимізоване ядро Apache. Всі ці системи закриті і налаштовані - Google пояснює це, кажучи, що закриті і налаштовані системи є дуже стійкими до зовнішніх атак і мають значно менші вразливості.

Я зробив. Про те, що затримки, я трохи славився :

Джерело:

Джерело

Не дивлячись на те, що Google довго дивує потужну динаміку зростання. Активний винищувач для «зеленої енергії», багато патентів в різних сферах, відкритості та дружніх до користувачів є першими асоціаціями, які виникають, коли багато хто згадує Google. Не менш вражаючим є дата-центр (центр даних або центр даних) компанії: це ціла мережа центрів обробки даних, розташованих по всьому світу, загальною потужністю 220 МВт (в минулому році). З огляду на те, що інвестиції в дата-центри за минулий рік окремо склали $ 2,5 млрд, зрозуміло, що компанія вважає стратегічно важливим і перспективним. У той же час є діалектична суперечність, тому що, незважаючи на публічність діяльності Google, його центри даних є своєрідним, як відомо, секрет, прихованим за семи печаток. Компанія вважає, що розкриття деталей проекту може бути використана конкурентами, тому лише частина інформації про найбільш прогресивні рішення, які витікають на громадськість, але навіть ця інформація дуже цікава.

Щоб розпочати роботу, Google не будує центрів обробки даних. Має відділ, який займається розробкою та обслуговуванням, а компанія співпрацює з місцевими інтеграторами, які здійснюють впровадження. Точна кількість центрів обробки даних не рекламується, але в пресі їх кількість коливається від 35 до 40 по всьому світу. Основна концентрація дата-центрів падає на Сполучених Штатах, Західній Європі та Східній Азії. Крім того, в оренду приміщення торгових центрів з хорошими каналами зв'язку знаходиться окреме обладнання. Відомо, що Google використовувало простір для дому обладнання центрів комерційної інформації Equinix (EQIX) та Саввіс (SVVS). Google є стратегічно орієнтованим на перемикання виключно до використання власних центрів обробки даних - корпорація пояснює це зростаючими вимогами до конфіденційності інформації користувачів, які довіряють компанії, і неминучість витоку інформації в комерційних дата-центрах. Після останніх тенденцій, влітку цього року було оголошено, що Google надасть можливість «закрити» інфраструктуру для сторонніх компаній і розробників, що відповідає моделі сервісу Compute Engine IaaS, яка забезпечить обчислювальну потужність для фіксованих конфігурацій з погодинною виплатою за використання.

Головною особливістю мережі центрів обробки даних не так багато в високій надійності єдиного центру даних, як в геодезингу. Кожен центр даних має багато каналів зв'язку високої чіткості з зовнішнім світом і реплікує його дані в кілька інших центрів обробки даних, що географічно розподілені по всьому світу. Таким чином, навіть форс-мажорний вплив такого типу, як метаоритний вплив не істотно впливає на безпеку даних. Географія центрів даних

Центр публічних даних знаходиться в місті Дуглас, США. Цей центр даних контейнерів (Figure 1) був відкритий у 2005 році. Цей центр даних є найбільш громадським. По суті, це різновид каркасної конструкції, що нагадує ангар, всередині якого контейнери розташовуються в двох рядах. В одному ряду - 15 контейнерів, розташованих в одному ярусі, і в другому - 30 контейнерів, розташованих в двох ярусах. Центр даних налічує близько 45,000 серверів Google. Контейнери - 20-фут марин. На сьогоднішній день введено в експлуатацію 45 контейнерів, а потужність ІТ-обладнання – 10 МВт. Кожен контейнер має власний зв'язок з гідравлічним охолодженням, власний блок розподілу потужності - він має, крім автоматичних вимикачів, також аналізаторів споживання електроенергії споживчих груп для розрахунку коефіцієнта PUE. Окремо розташовані насосні станції, каскади охолоджувача, дизель-генератори та трансформатори. Оголошено ПЮ 1.25. Система охолодження є двоконтурним, при цьому в другому контурі використовуються економайзери з охолоджувальними вежами, що значно зменшує час роботи охолоджувачів. По суті, це нічого більше, ніж відкрита вежа охолодження. Вода, яка виводить тепло з серверної кімнати, подається до вершини вежі, звідки вона обприскується і зливається вниз. У зв'язку з поливом води тепло передається в повітря, який відкачується ззовні вентиляторами, а сама вода частково випаровується. Це рішення значно знижує час охолоджувачів в центрі даних. Цікаво, що спочатку очищена вода для пиття була використана для поповнення запасів води в зовнішньому контурі. Google швидко зрозумів, що вода не повинна бути такою чистою, тому система була створена для лікування стічних вод з сусідніх очисних установок і поповнення води в зовнішньому охолодженні.

Всередині кожен контейнер, стійки з серверами будуються за принципом загального холодного коридору. Під ним під помилковим підлогою є теплообмінник і вентилятори, які продувають охолоджене повітря через решітки на серверні впуски. Нагрівається повітря від задньої частини шаф проводиться під хибним підлогою, проходить через теплообмінник і охолоджується, утворюючи переробка. Контейнери обладнані аварійним освітленням, кнопками EPO, датчиками диму та температури пожежної безпеки.

Рис. 1. Центр контейнерних даних у Дуглас

Цікаво, що Google згодом запатентував ідею «контейнерної башти»: контейнери розміщені на вершині один одного, з одного боку, організований вхід, а з іншого - інженерних комунікацій - систем електропостачання, кондиціонування та зовнішніх каналів зв'язку (рис. 2).

Рис. 2. Принцип повітряного охолодження в контейнері

Рис. 3. Запатентована «Контейнерна вежа»

Відкрито рік пізніше, в 2006 році, в Дуллесах (США), на березі річки Колумбії, дата-центр вже складався з трьох відокремлених будівель, два з яких (все з площею 6,400 кв.м) були побудовані в першу чергу (рис. 4) – вони розташовані машинні приміщення. Поруч з цими будівлями є споруди, які холодильні установки будинку. Площа кожної будівлі становить 1 700 кв.м. Крім того, у комплексі є адміністративна будівля (1,800 кв.м) та гуртожиток на тимчасове розміщення персоналу (1,500 кв.м).

Проект був раніше відомий як Project 02. Слід зазначити, що розташування для центру даних не було обрано шансом: перед тим, що тут функціонують алюмінієвий плавак потужністю 85 МВт, робота якого була призупинена.

Рис. 4. Будівництво першої фази центру даних у Далласі

У 2007 році Google почав будувати центр даних на південно-західному Іові, в округу Брюффс, біля річки Міссурі. Концепція нагадує попередній об'єкт, але є зовнішні відмінності: будівлі поєднуються, а холодильне обладнання замість охолоджувальних башт розташоване по обидва боки основної конструкції (рис. 5).

Рис. 5. Центр даних в Повітровому Бюфф є типовим поняттям для побудови центрів обробки даних Google.

У майбутньому ця концепція була прийнята як найкраща практика, оскільки вона може бути простежена в майбутньому. До прикладів відносяться дата-центри США:

Lenoir City (Північна Кароліна) – будівля площею 13,000 кв.м; побудована в 2007-2008 рр. (Фігура 6);

- Монкс Кукурудза (Південна Кароліна) - відкрита в 2008 році; складається з двох будівель, між якими зарезервований сайт для будівництва третьої; наявність власної високовольтної підстанції;

— Майес Каун (Оклахома) — будівництво затримало протягом трьох років — з 2007 по 2011 рік; центр даних був реалізований на двох стадіях — кожен включив будівництво будівлі площею 12,000 кв.м; блок живлення до центру даних забезпечує вітроелектростанція.

Рис. 6. Центр даних в м. Леноір

Але першість секретності відноситься до центру даних у Сент-Гіслані (рис 7а). Побудований в Бельгії між 2007 і 2008, цей центр даних більше, ніж центр даних в County Bluff. Крім того, цей центр даних не вдається в тому, що коли ви намагаєтеся переглянути супутникову карту Google, замість цього ви побачите порожню площу в порожній полі (рис. 7б). Google каже, що не існує негативного впливу на роботу цього центру даних на навколишні населені пункти: оброблені стічних вод використовуються як вода для охолодження вежі в дата-центрі. З цією метою було побудовано спеціальну багатоступеневу очисну станцію, а вода додається до станції через технічний канал.

Рис. 7а. Центр даних у Сент-Гіслані на карті пошукової системи

Рис. 7б. Не існує на Google Maps!

Фахівці Google в процесі будівництва відзначили, що вода, яка використовується для охолодження зовнішньої схеми, логічно буде отримувати від природного сховища, а не приймати з водопостачання. Корпорація для свого майбутнього дата-центру набула старої паперової фабрики у Фінляндії (Гаміна), яка була реконструйована як дата-центр (Фігура 8). Проект проводився протягом 18 місяців. 50 компаній взяли участь у його реалізації, а успішне завершення проекту відбулося в 2010 році. У той же час ця вага не випадково: розроблена концепція охолодження дійсно дозволила Google заявити екологічність своїх центрів обробки даних. У північному кліматі поєднаний з низькою температурою заморожування солі допускається охолодження без охолоджувачів, використовуючи тільки насоси і теплообмінники. Тут використовується типова схема з подвійним водяним контуром та проміжним теплообмінником. Морська вода перекачується в теплообмінники, охолоджує центр даних, а потім викидається в бухту Балтійського моря.

р.

р.Рис. 8. Реконструкція старої паперової фабрики в Hamina перетворює її в енергоефективний центр даних

У 2011 році в Північній частині Дубліна було побудовано 4000-квадро-метровий центр даних. Для створення дата-центру було відновлено складське приміщення, яке вже існувало тут. Це найбільш скромні відомі дата-центри, побудовані в якості ярлика для розгортання послуг компанії в Європі. У цьому ж році почалася розробка мережі центрів обробки даних в Азії, з трьома дата-центрами, які з'являються в Гонконгі, Сінгапурі та Тайвані. У цьому році Google оголосила про купівлю земельних ділянок для побудови центру даних в Чилі.

Зауважте, що в дата-центрі під будівництвом в Тайвані фахівці Google прийняли різний шлях, позбавляючи скористатися економічними перевагами дешевого, нічного тарифу електроенергії. Вода в величезних резервуарах охолоджується охолоджувачем з холодними баками і використовується для охолодження в денний час. Але чи буде використовуватися фазовий перехід теплоносія, або компанія зупиниться тільки на резервуарі з охолодженою водою. Можливо, після введення в експлуатацію центру даних Google надасть цю інформацію.

Цікаво, що полярна ідея – це навіть болдерний проект корпорації – плаваючий центр даних, який був запатентований Google у 2008 році. Патент стверджує, що ІТ-обладнання знаходиться на плаваючому посуді, охолодження здійснюється холодною офшорною водою, а електрика виробляється плаваючими генераторами, які генерують електроенергію з руху хвиль. Для пілотного проекту планується використовувати плаваючі генератори виробництва Pelamius: 40 таких генераторів, що пливуть на площу 50х70 метрів, виготовлять до 30 МВт електроенергії, достатній для експлуатації центру даних.

Google регулярно публікує PUE своїх центрів обробки даних. Сам метод вимірювання цікавий. Якщо в класичному розумінні Green Grid стандарти є співвідношення споживання енергії центру даних до його ІТ-мережі, то Google запускає PUE в цілому для об'єкта, в тому числі не тільки системи підтримки життя даних, але і перетворення втрат у трансформаторних підстанціях, кабелів, споживання електроенергії в офісних просторах і т.д. – це, все, що всередині периметру об'єкта. Вимірюваний PUE дається як середнє значення за щорічний період. Станом на 2012 рік, середнє PUE по всіх дата-центрах Google було 1.13.

Особливості вибору місця для побудови центру даних

По суті, зрозуміло, що при побудові таких величезних центрів обробки даних, їх розташування не вибрано Google. Які критерії враховуються фахівці компанії?

1,1 км Визначте дешеву електрику, можливість її постачання та екологічно чистого походження. У зв'язку з їх прихильністю до навколишнього середовища компанія використовує відновлювані джерела енергії, оскільки один великий центр даних Google споживає близько 50-60 МВт – достатньо бути єдиним клієнтом всієї електростанції. Крім того, відновлювані джерела можуть бути незалежними від цін на електроенергію. В даний час використовуються гідроелектростанції та вітроелектростанції.

2,2 км Велика кількість води, яку можна використовувати для охолодження. Це може бути як канал, так і натуральне тіло води.

3. У Наявність буферних зон між дорогами і населеними пунктами для побудови захищеного периметра і збереження максимальної конфіденційності об'єкта. У той же час автомагістралі необхідні для нормального транспортного сполучення з центром даних.

4. У Площа земельних ділянок, придбаних для будівництва дата-центрів, повинна забезпечити подальше розширення та будівництво допоміжних будівель або власних відновлюваних джерел енергії.

5. Умань Контакти З них слід мати кілька, і вони повинні бути захищені. Ця вимога стала особливо актуальною після регулярних проблем втрати каналів зв'язку в дата-центрі, розташованому в Орегоні (США). Повітряні лінії зв'язку пропускаються через силові лінії, ізолятори, на які стали для місцевих мисливців, які, як цілі для зйомки змагань. Таким чином, під час мисливського сезону зв'язок з дата-центром було постійно вирізати, і було багато часу і значних зусиль для відновлення. У результаті проблема була вирішена шляхом укладання підземних комунікаційних ліній.

6. Жнівень Податкові перерви. За умови, що використання «зелених технологій» значно дорожчі, ніж традиційні. Відповідно, при розрахунку повернення коштів, податкові пільги повинні зменшити вже високі капітальні витрати на першому етапі. Рис. 9. типовий Спартанний сервер Google нічого зайвого

Всі сервери встановлюються в 40-дюймових дворамних відкритих стійках, які розміщені в рядках з загальним «холодним» коридором. Цікаво, в дата-центрах Google не використовує спеціальні конструкції для обмеження «холодного» коридору, але використовує навісні жорсткі знімні полімерні ламелі, що робить це простим і вигідним рішенням, що дозволяє дуже швидко встановлювати шафи в існуючі рядки і при необхідності складати існуючі ламелі над верхнім шафою.

Крім апаратного забезпечення, Google використовує файлову систему Google (GFS), яка призначена для великих обсягів даних. Особливість цієї системи полягає в тому, що вона кластерована: інформація розділена на блоки 64 Мб і зберігається в принаймні трьох місцях одночасно з можливістю пошуку копійки примірників. Якщо будь-який з систем не виходить, копії автоматично розміщуються за допомогою спеціалізованих програм моделі MapReduce. Сама модель передбачає паралельні роботи і виконання завдань на декількох машинах одночасно. Інформація зашифрована всередині системи. BigTable використовує розподілені сховища для зберігання великої кількості інформації з швидким доступом для зберігання, таких як індексація веб-сайтів, Google Earth та Google Finance. Основні веб-додатки Google Web Server (GWS) і Google Front-End (GFE), які використовують оптимізоване ядро Apache. Всі ці системи закриті і налаштовані - Google пояснює це, кажучи, що закриті і налаштовані системи є дуже стійкими до зовнішніх атак і мають значно менші вразливості.

Я зробив. Про те, що затримки, я трохи славився :

Джерело: