769

伊隆·马斯克,比尔·盖茨和斯蒂芬·霍金是参加了“年度勒德分子”

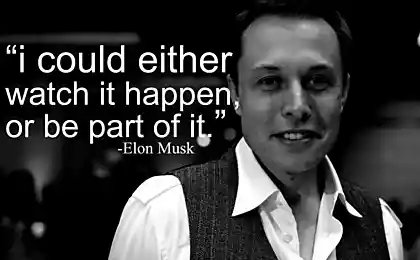

专家自称委员会信息技术与创新基金会,<一个href="https://itif.org/publications/2015/12/21/2015-itif-luddite-award-nominees-worst-year%E2%80%99s-worst-innovation-killers">опубликовала提名奖“勒德年”,其中包括10项名单。根据裁决书的作者也有相当多的人认为,未来的技术,如RFID,标签或转基因生物的发展,是一个危险的人类。在“恐惧”列表中的第一个项目是指人工智能(AI),并根据该奖项的作家,其危险不必要声明伊隆·马斯克,比尔·盖茨和斯蒂芬·霍金。在颁奖“勒德分子»<一href="http://www.theguardian.com/technology/2015/dec/24/elon-musk-nominated-for-luddite-of-the-year-prize-over-artificial-intelligence-fears">обратила注意监护人。

事实上,一些人,其中包括伊隆·马斯克,认为AI到底发展会导致一个事实,即“心机”获得了一些危险的特性对人类,因此人们会被奴役或销毁。本主题是刻苦钻研开发在这样著名的好莱坞电影,如“黑客帝国”和“终结者”,因而“爱的恐惧”加强了在社会中的代表性。伊隆·马斯克去年表示担心人工智能可能比核武器更加危险:

事实上,一些人,其中包括伊隆·马斯克,认为AI到底发展会导致一个事实,即“心机”获得了一些危险的特性对人类,因此人们会被奴役或销毁。本主题是刻苦钻研开发在这样著名的好莱坞电影,如“黑客帝国”和“终结者”,因而“爱的恐惧”加强了在社会中的代表性。伊隆·马斯克去年表示担心人工智能可能比核武器更加危险:

价值由博斯特伦阅读超级智能。我们需要超级小心AI。可能比nukes.-伊隆·马斯克(elonmusk)更危险2014年8月3日 BLOCKQUOTE>

作者保费认为,关于人类的未来这样的意见 - 这是人工智能在这一阶段的发展只是一个错误的认识。是否这样的情况,即AI才能真正自治,并获得了“心”的问题 - 是值得商榷的,至少,这个问题是不是在不久的将来。因此,科学家们努力的Siri或恒温器巢的努力,几乎导致这样的事实,有一天他们会想破坏他们的创造者。

全部列表“卢德运动”如下。添加资料( PDF ),其作者认为这种表述的无效。<溴/ >

- 在人工智能的恐惧。

- 在自主防御武器的禁令,即所谓的“杀手机器人»。

- 在使用自动扫描仪汽车数量的限制。

- 在使用尤伯杯般的服务的限制。

- 避免使用的商品代替纸张的电子标签中。

- 禁止在加州驾照使用RFID-标签。 < LI>私人财产和公共利益之间的冲突。有一个在怀俄明州(美国),当私人土地通过法院业主已禁止非营利组织成员开展生物学研究在其领土上的情况的看法。

- 要取消网络中立

- 对转基因食品的斗争原则< /

- 在使用的限制自动提交违反交通法规

如你所知,卢德运动 - 这是工业革命的英国,其成员看到了自己的主要危险,在生产新的机器可以取代他们在工作场所,因此设备必须被销毁过程中出现的社会运动。

资料来源: geektimes.ru/post/268340/