科学家斯图尔特*罗塞尔在人工智能

Bashny.Net

Bashny.Net

第九十一万九十九千七百七十四个

在一月,英国-美国计算机科学家斯图尔特*罗素是第一个人签署一封公开信,呼吁为研究人员认为更深层次关于他们的愿望,以创造一个人工智能更强大和更强大。 "我们建议扩大研究,旨在确保可靠性和善意的人工智能系统日益增加的权力--是说,在这封信。 —我们的人工智能系统必须做什么,我们希望他们这样做。"

成千上万的人签署的信函,包括领先的研究人员的人工智能从谷歌、Facebook、微软和其他工业中心,以及领先的计算机科学家,物理学家和哲学家周围的世界。 三月底,约300研究团体开始进行新的研究报告"保护善意的人工智能的"费用的37签署的信函,发明者企业家的伊隆麝香。

罗素,有53个,是一个计算机科学系教授和创始人,该中心为智能系统在加利福尼亚大学伯克利分校,长期以来一直在研究将权力和危险的思考机器。 他撰写超过200篇论文和标准的教科书在这个领域中,"人工智能:一种现代方法"(共同撰写与彼得Norvega). 然而,迅速取得进展的领域AI给了老的恐惧罗素的重大意义。

最近,他说,人工智能已经取得了巨大成功,部分原因是由于算法的神经学习。 他们是用在软件的面部检测Facebook、个人助理、智能手机和无人驾驶汽车。 不久前,整个世界被震撼了一个网络的人工神经元,学会玩Atari视频游戏比人类更好几个小时,基于仅有的数据显示在屏幕上,我们的目标是获得最高分数—没有预先编制有关的知识的外国人,子弹,右,左,底部、顶端。

"如果你的新生儿做了这些,你会认为他痴迷,"说,罗素。

杂志的量子杂志了Russell的面试在一个早餐会议的美国物理学会在2015年三月在圣安东尼奥,德克萨斯州,前一天,他应该保留在谈论未来的人工智能。 在这个处理和精简的版本的采访Russell反映了对大自然的智慧和关于快速方法的问题相关的安全机制。

你认为的目的是你的领域中发展的人工智能"证明收敛"与人类价值观。 是什么意思?

这种故意挑衅性声明,因为组合的两件事--"证明"和"人类的价值"--这本身就是有争议的。 它可能是人的价值将仍是一个谜,永远。 但是,正如这些数值显示在我们的行为,你可以希望,机器可以"使"的大多数。 角可件和部件的机会不理解或者,我们无法找到一个共同意见之间的自己。 但是,同时该机器将满足正确的要求,你将能够显示,它是无害的。

你打算如何实现这一目标?

这是如何的问题,我的工作:在什么时候将该车的最相似的价值观的那些人的需要? 我认为一个答案可能的技术,称为"反向的学习巩固。" 定期的培训加强的过程中,你得到的奖励和惩罚,但是你的目标是使这一进程中获得最大数量的奖励。 这是DQN(打Atari);它得到的分数,她的目标是使这个分数更高。 反馈的培训与增强物的另一种方式。 你看到一些行为,并试图了解这种行为是试图增加。 例如,你的家机器人看到你在早上爬下床扔一个奇怪的棕色圆圈在嘈杂的机器做一个复杂的操作蒸汽与热水、牛奶和糖,然后看看高兴。 该系统确定该部分的基本价值观的人—在早上喝咖啡。

在书籍、电影和互联网上有一个巨大数量信息有关的人的行动和关系来行动。 这是一个令人难以置信的数据库,用于计算机学习的价值的人—谁会得到奖牌,谁去监狱和为什么。

十七万三百七十万八百七十九个

你怎么进的人工智能吗?

当我在高中艾不被视为一种学术科目在长期运行。 但我去寄宿学校在伦敦,而我还没有机会参加橄榄球义务,这样做的计算机科学附近的一个学院。 我的一个项目是一个程序,学会玩井字游戏的。 我已经失去了所有普及,因为坐在一个计算机学院的痛苦的结束。 下一年,我写了一个国际象棋程序和得到许可的一个教授的大学帝国学院使用他们的巨大型计算机。 这是令人难以置信的尝试弄清楚如何教他下棋。

然而,这只是一种业余爱好;在这时,我的学术兴趣的是物理学。 我在研究物理学在牛津大学。 然后当我去学校,然后转移到理论物理中牛津和剑桥大学和大学计算机科学的马萨诸塞州斯坦福,没有意识到,我错过了所有的最后期限为申请在美国。 幸运的是,斯坦福大学忽略的时间,所以我去找到它。

在你的职业生涯你花了很多时间,试图了解的智力作为一个必要条件,它可以了解并达到的车。 你有什么教训?

在我的学位论文的研究,在80年代,我开始认为对合理的决策和问题实际上是不可能的,这一点。 如果你是理性的,你会想到:这是我目前的状况,下面是步骤,我可以采取的,然后你可以这样做,那么这是什么路径保证使我的目标? 定义的理性行为,需要优化整个未来的宇宙。 这是不可能从观点的计算。

有没有点试图塞AI是不可能的,所以我在想的东西:由的情况下,我们作出决定吗?

你怎么知道的?

一个窍门是要想在短期内,然后建议什么可能看起来像未来。 国际象棋程序,例如—如果它是合理的,然后播放的只有移动的保证的垫子上,但他们不这样做。 相反,他们计算出几十个向前推进,并使假设关于如何用这些未来的状态,然后作出决定,导致一个最好的国家。

第九十四万八百四十六千五百七十六个

报告重要的是不要忘了,这是问题的解决方案在多个级别的抽象,"分层决策"的。 一个人犯了20亿美元的体育活动在我的生活。 来到这个会议和分享信息的需要作出1.3亿美元的行动。 如果你是理性的,你会试图计算所有1.3亿步骤,事实上,相当不可能的。 人们这样做由于庞大的行李的抽象的高级步骤。 你不认为的,"当我回家的时候,我把左或右脚的垫子上,然后可以这么和如此。" 你想想,"我会去商店买了一本书。 然后叫出租车。" 这就是所有的。 你不认为太多,直到你需要澄清的复杂的部分。 和生活,在原则。 未来是模糊的,因此许多详细信息接近我们的时间,但主要是提出在大片类似"的程度","有子女"。

是计算机目前能够分层决策?

这是一个缺失的部分难题是:哪里有所有的这些行动在一个高水平? 我们不认为像软件网络DQN有抽象的概念有关的行动。 有许多游戏,DQN只是不明白,这些游戏很复杂,需要许多步骤,计算出在前形式的原始概念的行动的东西就像当一个人想"我需要做什么开门?"开放门涉及除去的关键。 如果机器有没有这样的表示"开门",她就不能做任何事情。

但是,如果这个问题将会被解决的—这是相当可能的—然后我们将看到另一个显着增加功能的机器。 有两个或三个问题和如果你解决了它们,然后我不知道是否存在将仍然主要障碍AI人的水平。

什么让你心烦的可能性是人类的水平吗?

在第一版我的书(1994年)的一部分"是什么,如果我们成功了?",因为它似乎对我来说,人们不想它太多了。 可能,但那似乎太遥远和不可能的。 但很明显,成功将是一个巨大的事件。 "最大的事件在人类历史上的",或许它可以描述它。 如果是这样,那么我们需要考虑我们在做什么磨练的形状这一事件。

其主要思想的智慧爆炸是,一旦机达到一定的智力水平,他们可以工作AI以及我们和提高他们自身的特点—以重新编程和改变自己的馅料和他们的智力的增长将通过跨越式发展。 在过去的几年中的社区已逐渐磨练他们的论据,为什么这可能是一个问题。 最有说服力的论点可能在方程的价值:你建立一个系统,该系统是非常好的优化有用的功能,但这个概念的用处是值得怀疑的。 牛津大学哲学家尼克*博斯特伦给出的例子的一个纸的剪辑。 你说的"采取了几个纸的剪辑",但是在结束整个地球是一个仓库的主食。 你建立职业妇女福利互助协会会员,但有益的要素,可以奖赏,可以无用的。

七八万五百八十一千一百一十二

怎么样的差异的人类价值呢?

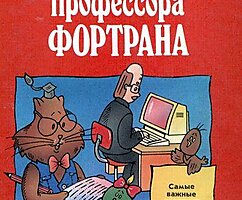

这是一个内部问题。 我们可以说,汽车需要去旁什么也不做在在哪些领域可能有冲突的价值观。 这是一个困难的任务。 我认为我们应该创建一个系统的价值观。 如果你需要一个家机器人,它需要一个良好的掌握的人类价值;否则,它会做愚蠢的事情,把猫在烤箱,因为冰箱里已经没有食物,及儿童饥饿。 现实生活充满了这样的妥协。 如果机器去这一妥协的事实证明,她不了解的东西--这很显然人们几乎没有你想要的那辆车回家。

我没有看到任何真正的方式创造一种行业的价值观。 我还认为有一个巨大的经济激励其创作。 国内的机器人做一个或两件事情是错误的—就像烤猫在烤箱—和人民立即失去对他的信任。

问题是,如果我们是要去教智能系统的行为正确的,因为过渡到一个更合理的系统将这意味着我们将得到最好的价值系统,从纯的愚蠢的时刻,或机会仍然瞎说了吗? 我没有回答这个问题。

你说我们需要以数学方式验证的行为AI下的所有可能的情况下。 这将如何工作的?

困难之一称由的人,该系统可以随机产生一个新的版本,这将有其他目标。 这是其中一个方案,它不断地说是科幻小说作家:以某种方式的机的自发的得到我们的目标,以毁灭人类。 问题是:你能证明你的系统永远不会,不论有多聪明是不是,不是改写原来的目的的人吗?

会比较容易证明该系统是DQN,如果编写的,将永远不能改变你的目标或优化它。 但是想象一下,有人用电线的头真正得到控制台游戏Atari和物理改变的事情赚点在屏幕上。 DQN然而,因为她是在比赛,并没有操纵。 但是,如果机器的运作将在现实世界中,这将是一个严重的问题。 所以,如果你能证明你的系统设计,在这样一种方式,可能永远不会改变机构绑到一点,即使他们想要的? 它更难以证明。

在这方有一些有希望的成就?

有一个发展中区域的所谓网络的物理系统相关联的系统,使计算机来的真实的世界。 与网络物理系统将收到一套的比特表示的程序的空中交通控制,那么真正的飞机和照顾,以确保这些飞机都没有遇到过。 你想证明一个理论有关的组合比特和物理的世界。 你需要编写一个相当保守的数学描述的物理的世界的飞机,加速向这样的一个办法了,你理应仍然是真实的在现实世界只要为真正的世界将是在这样一个信封的行为。

你说它可以在数学上不可能到正式的试验对人工智能系统吗?

有一个共同问题的"不溶解性"在许多问题你可以问问题的计算机程序。 阿兰*图灵显示,没有计算机应用程序可以不时决定的另一程序将得到回答,并且当你陷入无限循环。 所以如果你启动一个程序,它将复盖本身并成为另一种程序,就会有一个问题,因为你不能证明所有可能的其他程序将必须满足某些标准。 因此,我们应该再担心unsolvability的人工智能系统,复盖自己? 他们将复盖本身的新程序,根据现有程序,加上经验,你得到真正的世界。 是什么造成的后果密切的相互作用的程序与现实世界吗? 我们还不知道出版

P.S.记住,仅仅通过改变他们的消费—我们一起改变世界了。 ©

资料来源:hi-news.ru

在一月,英国-美国计算机科学家斯图尔特*罗素是第一个人签署一封公开信,呼吁为研究人员认为更深层次关于他们的愿望,以创造一个人工智能更强大和更强大。 "我们建议扩大研究,旨在确保可靠性和善意的人工智能系统日益增加的权力--是说,在这封信。 —我们的人工智能系统必须做什么,我们希望他们这样做。"

成千上万的人签署的信函,包括领先的研究人员的人工智能从谷歌、Facebook、微软和其他工业中心,以及领先的计算机科学家,物理学家和哲学家周围的世界。 三月底,约300研究团体开始进行新的研究报告"保护善意的人工智能的"费用的37签署的信函,发明者企业家的伊隆麝香。

罗素,有53个,是一个计算机科学系教授和创始人,该中心为智能系统在加利福尼亚大学伯克利分校,长期以来一直在研究将权力和危险的思考机器。 他撰写超过200篇论文和标准的教科书在这个领域中,"人工智能:一种现代方法"(共同撰写与彼得Norvega). 然而,迅速取得进展的领域AI给了老的恐惧罗素的重大意义。

最近,他说,人工智能已经取得了巨大成功,部分原因是由于算法的神经学习。 他们是用在软件的面部检测Facebook、个人助理、智能手机和无人驾驶汽车。 不久前,整个世界被震撼了一个网络的人工神经元,学会玩Atari视频游戏比人类更好几个小时,基于仅有的数据显示在屏幕上,我们的目标是获得最高分数—没有预先编制有关的知识的外国人,子弹,右,左,底部、顶端。

"如果你的新生儿做了这些,你会认为他痴迷,"说,罗素。

杂志的量子杂志了Russell的面试在一个早餐会议的美国物理学会在2015年三月在圣安东尼奥,德克萨斯州,前一天,他应该保留在谈论未来的人工智能。 在这个处理和精简的版本的采访Russell反映了对大自然的智慧和关于快速方法的问题相关的安全机制。

你认为的目的是你的领域中发展的人工智能"证明收敛"与人类价值观。 是什么意思?

这种故意挑衅性声明,因为组合的两件事--"证明"和"人类的价值"--这本身就是有争议的。 它可能是人的价值将仍是一个谜,永远。 但是,正如这些数值显示在我们的行为,你可以希望,机器可以"使"的大多数。 角可件和部件的机会不理解或者,我们无法找到一个共同意见之间的自己。 但是,同时该机器将满足正确的要求,你将能够显示,它是无害的。

你打算如何实现这一目标?

这是如何的问题,我的工作:在什么时候将该车的最相似的价值观的那些人的需要? 我认为一个答案可能的技术,称为"反向的学习巩固。" 定期的培训加强的过程中,你得到的奖励和惩罚,但是你的目标是使这一进程中获得最大数量的奖励。 这是DQN(打Atari);它得到的分数,她的目标是使这个分数更高。 反馈的培训与增强物的另一种方式。 你看到一些行为,并试图了解这种行为是试图增加。 例如,你的家机器人看到你在早上爬下床扔一个奇怪的棕色圆圈在嘈杂的机器做一个复杂的操作蒸汽与热水、牛奶和糖,然后看看高兴。 该系统确定该部分的基本价值观的人—在早上喝咖啡。

在书籍、电影和互联网上有一个巨大数量信息有关的人的行动和关系来行动。 这是一个令人难以置信的数据库,用于计算机学习的价值的人—谁会得到奖牌,谁去监狱和为什么。

十七万三百七十万八百七十九个

你怎么进的人工智能吗?

当我在高中艾不被视为一种学术科目在长期运行。 但我去寄宿学校在伦敦,而我还没有机会参加橄榄球义务,这样做的计算机科学附近的一个学院。 我的一个项目是一个程序,学会玩井字游戏的。 我已经失去了所有普及,因为坐在一个计算机学院的痛苦的结束。 下一年,我写了一个国际象棋程序和得到许可的一个教授的大学帝国学院使用他们的巨大型计算机。 这是令人难以置信的尝试弄清楚如何教他下棋。

然而,这只是一种业余爱好;在这时,我的学术兴趣的是物理学。 我在研究物理学在牛津大学。 然后当我去学校,然后转移到理论物理中牛津和剑桥大学和大学计算机科学的马萨诸塞州斯坦福,没有意识到,我错过了所有的最后期限为申请在美国。 幸运的是,斯坦福大学忽略的时间,所以我去找到它。

在你的职业生涯你花了很多时间,试图了解的智力作为一个必要条件,它可以了解并达到的车。 你有什么教训?

在我的学位论文的研究,在80年代,我开始认为对合理的决策和问题实际上是不可能的,这一点。 如果你是理性的,你会想到:这是我目前的状况,下面是步骤,我可以采取的,然后你可以这样做,那么这是什么路径保证使我的目标? 定义的理性行为,需要优化整个未来的宇宙。 这是不可能从观点的计算。

有没有点试图塞AI是不可能的,所以我在想的东西:由的情况下,我们作出决定吗?

你怎么知道的?

一个窍门是要想在短期内,然后建议什么可能看起来像未来。 国际象棋程序,例如—如果它是合理的,然后播放的只有移动的保证的垫子上,但他们不这样做。 相反,他们计算出几十个向前推进,并使假设关于如何用这些未来的状态,然后作出决定,导致一个最好的国家。

第九十四万八百四十六千五百七十六个

报告重要的是不要忘了,这是问题的解决方案在多个级别的抽象,"分层决策"的。 一个人犯了20亿美元的体育活动在我的生活。 来到这个会议和分享信息的需要作出1.3亿美元的行动。 如果你是理性的,你会试图计算所有1.3亿步骤,事实上,相当不可能的。 人们这样做由于庞大的行李的抽象的高级步骤。 你不认为的,"当我回家的时候,我把左或右脚的垫子上,然后可以这么和如此。" 你想想,"我会去商店买了一本书。 然后叫出租车。" 这就是所有的。 你不认为太多,直到你需要澄清的复杂的部分。 和生活,在原则。 未来是模糊的,因此许多详细信息接近我们的时间,但主要是提出在大片类似"的程度","有子女"。

是计算机目前能够分层决策?

这是一个缺失的部分难题是:哪里有所有的这些行动在一个高水平? 我们不认为像软件网络DQN有抽象的概念有关的行动。 有许多游戏,DQN只是不明白,这些游戏很复杂,需要许多步骤,计算出在前形式的原始概念的行动的东西就像当一个人想"我需要做什么开门?"开放门涉及除去的关键。 如果机器有没有这样的表示"开门",她就不能做任何事情。

但是,如果这个问题将会被解决的—这是相当可能的—然后我们将看到另一个显着增加功能的机器。 有两个或三个问题和如果你解决了它们,然后我不知道是否存在将仍然主要障碍AI人的水平。

什么让你心烦的可能性是人类的水平吗?

在第一版我的书(1994年)的一部分"是什么,如果我们成功了?",因为它似乎对我来说,人们不想它太多了。 可能,但那似乎太遥远和不可能的。 但很明显,成功将是一个巨大的事件。 "最大的事件在人类历史上的",或许它可以描述它。 如果是这样,那么我们需要考虑我们在做什么磨练的形状这一事件。

其主要思想的智慧爆炸是,一旦机达到一定的智力水平,他们可以工作AI以及我们和提高他们自身的特点—以重新编程和改变自己的馅料和他们的智力的增长将通过跨越式发展。 在过去的几年中的社区已逐渐磨练他们的论据,为什么这可能是一个问题。 最有说服力的论点可能在方程的价值:你建立一个系统,该系统是非常好的优化有用的功能,但这个概念的用处是值得怀疑的。 牛津大学哲学家尼克*博斯特伦给出的例子的一个纸的剪辑。 你说的"采取了几个纸的剪辑",但是在结束整个地球是一个仓库的主食。 你建立职业妇女福利互助协会会员,但有益的要素,可以奖赏,可以无用的。

七八万五百八十一千一百一十二

怎么样的差异的人类价值呢?

这是一个内部问题。 我们可以说,汽车需要去旁什么也不做在在哪些领域可能有冲突的价值观。 这是一个困难的任务。 我认为我们应该创建一个系统的价值观。 如果你需要一个家机器人,它需要一个良好的掌握的人类价值;否则,它会做愚蠢的事情,把猫在烤箱,因为冰箱里已经没有食物,及儿童饥饿。 现实生活充满了这样的妥协。 如果机器去这一妥协的事实证明,她不了解的东西--这很显然人们几乎没有你想要的那辆车回家。

我没有看到任何真正的方式创造一种行业的价值观。 我还认为有一个巨大的经济激励其创作。 国内的机器人做一个或两件事情是错误的—就像烤猫在烤箱—和人民立即失去对他的信任。

问题是,如果我们是要去教智能系统的行为正确的,因为过渡到一个更合理的系统将这意味着我们将得到最好的价值系统,从纯的愚蠢的时刻,或机会仍然瞎说了吗? 我没有回答这个问题。

你说我们需要以数学方式验证的行为AI下的所有可能的情况下。 这将如何工作的?

困难之一称由的人,该系统可以随机产生一个新的版本,这将有其他目标。 这是其中一个方案,它不断地说是科幻小说作家:以某种方式的机的自发的得到我们的目标,以毁灭人类。 问题是:你能证明你的系统永远不会,不论有多聪明是不是,不是改写原来的目的的人吗?

会比较容易证明该系统是DQN,如果编写的,将永远不能改变你的目标或优化它。 但是想象一下,有人用电线的头真正得到控制台游戏Atari和物理改变的事情赚点在屏幕上。 DQN然而,因为她是在比赛,并没有操纵。 但是,如果机器的运作将在现实世界中,这将是一个严重的问题。 所以,如果你能证明你的系统设计,在这样一种方式,可能永远不会改变机构绑到一点,即使他们想要的? 它更难以证明。

在这方有一些有希望的成就?

有一个发展中区域的所谓网络的物理系统相关联的系统,使计算机来的真实的世界。 与网络物理系统将收到一套的比特表示的程序的空中交通控制,那么真正的飞机和照顾,以确保这些飞机都没有遇到过。 你想证明一个理论有关的组合比特和物理的世界。 你需要编写一个相当保守的数学描述的物理的世界的飞机,加速向这样的一个办法了,你理应仍然是真实的在现实世界只要为真正的世界将是在这样一个信封的行为。

你说它可以在数学上不可能到正式的试验对人工智能系统吗?

有一个共同问题的"不溶解性"在许多问题你可以问问题的计算机程序。 阿兰*图灵显示,没有计算机应用程序可以不时决定的另一程序将得到回答,并且当你陷入无限循环。 所以如果你启动一个程序,它将复盖本身并成为另一种程序,就会有一个问题,因为你不能证明所有可能的其他程序将必须满足某些标准。 因此,我们应该再担心unsolvability的人工智能系统,复盖自己? 他们将复盖本身的新程序,根据现有程序,加上经验,你得到真正的世界。 是什么造成的后果密切的相互作用的程序与现实世界吗? 我们还不知道出版

P.S.记住,仅仅通过改变他们的消费—我们一起改变世界了。 ©

资料来源:hi-news.ru

标签

另请参见

8辉煌的事情发明的孩子

人工耳。奇迹生物工程

在AI已经学会了如何扮演上帝赢得人类

埃利泽Yudkowsky:人vs的人工智能的—谁会赢?

比尔*盖茨的人工智能的发展

AI已经到来:这里是什么担心的最聪明的头脑的人类

10最有趣的技术,在2015年

10女科学家

罗素·克劳50今天!