思维的逻辑。第3部分:感知器,卷积网络

Bashny.Net

Bashny.Net

在的第一部分我们描述的神经元的性质。 第二谈论有关他们的训练的基本属性。在下一节中,我们转向如何真正大脑的描述。但在此之前,我们需要做最后的努力,并接受一点点的理论。现在看来最有可能的是不是特别有趣。我想我自己会zaminusovali训练后。但所有这些“字母”,极大地帮助我们理解未来。

感知

在机器学习份额两种基本方法:监督学习和无监督学习。上面描述的亮点主要成分的方法 - 就是学习无师自通。所述神经网络接收没有解释为什么她被馈送到输入端。它简单地强调了那些统计规律所存在的输入数据流中。与此相反,该监督学习假定输入图像的一部分,所谓的训练样本,我们知道,输出的结果,我们所希望的。因此,问题 - 如此配置的神经网络,以捕获连接的输入和输出数据的模式

。

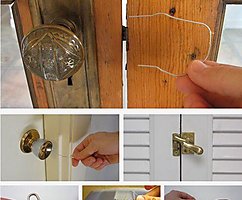

1958年,弗兰克·罗森布拉特描述了他所谓的感知器(罗森布拉特,1958)的结构,能够与老师(见KDPV)学习。

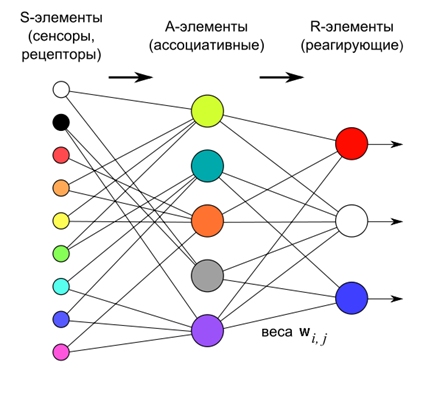

布拉特感知由神经元的三层。第一层 - 定义一下我们在进口该传感器元件。第二层 - 联想的元素。他们与触摸层关系是硬编码,并确定过渡到比触摸层关联图片描述比较一般。

感知训练是通过改变反应的第三层的神经元的权重。学习目标 - 使感知提交的图像正确分类

。

第三层充当的神经阈值加法器。因此,每个这些参数的权重限定了一定的超平面。如果有一个线性可分的输入信号,所述输出神经元正好可以作为其分类。

如果 - 是实际产出和感知的载体 - 载体,我们希望收到,对神经网络的性能表示误差矢量:

如果要求,以最小化均方误差,所以能够得到所谓的delta-规则修改的权重:

在这种情况下,最初的近似值可能使零(重量)。

这个规则是不超过赫布法则,施加到感知器的情况下,更。

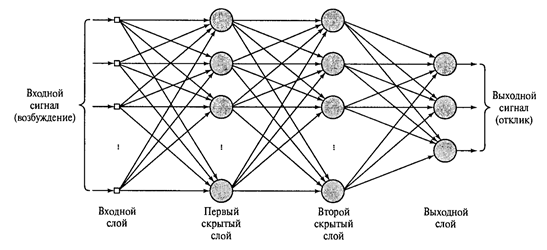

如果周末是另一层或多个层和反应以放弃缔层,这是由布拉特引入多种生物的确定性,比由于计算必要性,那么我们得到的多层感知器,如该图所示如下。

有两个隐藏层(赫金,2006年)多层感知器 I>

如果神经元的反应层是简单的线性组合是毫无意义在这样一个复杂不会。产率,无论隐藏层的数目,仍然存在于输入信号的线性组合。但作为隐藏层使用门槛加法器,那么每个新层打破线性的链条,可携带的有趣的描述。

很长一段时间,目前还不清楚它是如何可能培养出多层感知。其基本方法 - 反向传播只在1974年,AI描述Galushkin和独立,同时J.保罗。Verbosom。然后,它被重新发现,并成为众所周知的1986年(大卫E.鲁梅哈特,杰弗里·E.韩丁,罗纳德·威廉斯,1986)。

该方法包括两个通行证:正向和反向。与直接通训练信号被馈送和计算的所有网络节点的活动,包括输出层的活性。减去的是,为获得一误差信号所要求的活动得到确定。在反向通,误差信号从输出到输入的相反方向传播。因而突触加权值被调整以最小化误差。该方法的详细说明可在各种来源(例如,Haykin的,2006年)中找到。

重要的是要注意,在一个多层感知信息是从水平到水平处理的事实是重要的。当每个层被分配给一组固有的输入信号特征的。这就产生了一定的类比与信息在大脑皮质的区域之间转换的方式。

卷积网络。 Neocognitron

多层感知器和一个真正的大脑的比较是非常有条件的。一般 - 是,从区上升到在皮质或从层区层感知器,信息是变更一般化的描述。然而,皮质的部分的结构比神经元的层感知的组织复杂得多。视觉系统D.胡贝尔和威塞尔T的研究允许更好地理解视觉皮层的结构和推到使用这种知识在神经网络。已经使用的主要思路 - 是单层内感知和神经元的功能分工的局部地区

。

美国已经知道当地的感知,这意味着接收信息的神经元,下面是不是对所有输入信号的空间,只是其中的一部分。前面我们说,这个区域被称为跟踪神经元的感受野。

感受野的概念需要一个单独的规范。传统上,在神经元的感受野被称为影响神经元的动作受体的空间。根据受体神经元被理解直接感知外部信号。代表一神经网络包括两层,其中第一层 - 接受层和第二层 - 连接受体的神经元。第二层的每个神经元,那些与他接触的受体 - 这是他的感受野

。

现在需要一个复杂的多层网络。我们从入口搬开进一步,就越难将指示哪些受体和在位于深神经元的活动的效果。在某些时候可能是对于存在可以被称为其感受野一些神经元受体。在这种情况下,神经元的感受野只想要调用这些神经元与它有直接的突触接触。为了区分这些概念将被称为输入空间的受体 - 原来感受野。然后神经元的相互作用,直接与神经元的空间 - 当地的感受野或者干脆感受野,没有进一步的澄清

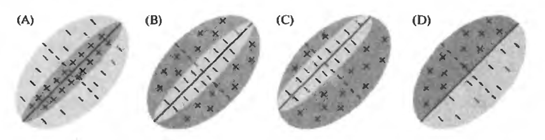

神经科为函数的两种主要类型的神经元的初级视皮层的检测有关。简单(简单)的神经元的刺激,设在它们的原始感受野的某一特定地点响应。复杂(复杂)的神经元活跃的刺激,无论他的位置。

例如,下面的图显示可能看起来像简单细胞的感受域的灵敏度的原始图像的选项。正激活神经元区域,抑制负。每个神经元有一个简单的刺激,对他来说最合适的,因此,导致最大活性。但重要的是,这种激励紧紧结合在感受野原来的位置。相同的刺激,但转移到了一边,就不会触发一个简单的神经元。

简单的细胞(J.尼科尔斯。马丁R.华莱士B.,福克斯体育)的初步感受野 I>

复杂的神经元也有自己喜欢的刺激,但他们可以学习这种刺激,无论其原有感受野的位置。

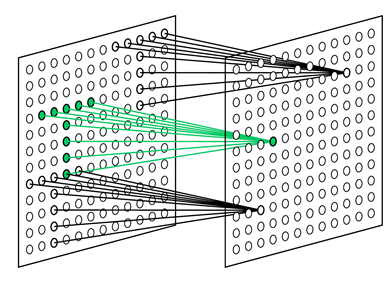

从这两个思路出生神经网络的适当的模型。第一个这样的网络创建邦彦福岛。它被命名为cognitron。后来,他创造了一个更先进的网络 - neocognitron(福岛,1980)。 Neocognitron - 数层建筑。每一层是由简单的(S)和复杂©神经元。

一个简单的神经元监视他们的感受野和识别的图像,这是他的训练。简单的神经元被收集成组(平面)。在同一组调谐到相同的刺激简单的神经元,但每个神经观看感受野其片段。在一起,它们经历了图像的所有可能的位置(参见下图)。所有简单的神经元一个平面上具有相同的重量,但不同的感受野。你能想象的情况以不同的方式,即一个神经元,这是能够立即途中尝试原始图像的所有项目。所有这一切都可以让你学会以同样的方式,无论其位置。

被配置为搜索在不同的位置选择的模式(福岛K.,2013) i>的

简单细胞的感受野

每个神经元的复杂看着他们的飞机,如果启用了至少一个简单的神经元在其平面触发简单的神经元(见下图)。活动简单的神经元说,他了解到的特征刺激在一个特定的地方,这是它的感受野。活性复合物的神经元表示相同的图像通常遇到的一个层上,随后通过简单的神经元。

飞机neocognitron I>

每个层具有其输入后的输入图像所形成的前一层的复杂的神经元。从层到层发生更多的信息汇编导致在识别特定的图象,无论其上的原始图象和转换位置的。

关于该图像分析装置,其检测在以一定角度的第一行的水平,通过小感受野。它能够在任何地方检测所有可能的方向在图像中。下一级检测可能组合的基本特征,限定复杂形状。因此重要的是,还没有能够确定所需要的图象(见下图)。

在识别过程中neocognitron I>

当用于手写识别,这样的设计是耐写入的方法。识别的成功并不影响运动的表面或旋转或变形(拉伸或压缩)上。

从全网状neocognitron多层感知最显著差异 - 与神经元的相同数目的使用权重的数量少得多。碰巧的是,由于“绝招”,这使得无论他们的位置,以确定neocognitron图像。简单细胞的飞机 - 基本上决定着卷积核一个神经元的权重。这个内核被施加到上一层,在所有可能的位置上运行它。其实神经元每架飞机,并要求他的关系协调这些职位。这导致一个事实,即在一层简单细胞的所有神经元应当确保,如果有任何在其感受野图像对应的内核。也就是说,如果这样的图像输入信号中的该层其他地方找到,这是通过至少一个简单的神经元活动检测,并导致对应的神经元复合物。这一招可以让你找到一个鲜明的形象在任何地方,无论他出现了。但是,我们必须记住,这是一招,它是不是真的符合皮质的实际工作。

教育neocognitron发生无师自通。它对应于前面描述的分离步骤全套因素。当输入neocognitron提供实时图像,神经别无选择,只能突出固有的这些图像组件。因此,如果输入手写数字,第一层的简单的神经元的小感受野将看到线条,角度和缀合。竞争领域的尺寸决定了许多不同的因素可以站在每一个空间区域。主要分配最显著的组件。对于手写的数字,这将是该行以不同的角度。如果你保持免疫因素,它可能会继续站出来,更复杂的元素。

从层到层保持学习的一般原则 - 站在特定于多个输入信号中的因素。馈送手写在第一层上的数字在一定的水平,我们获得对应于这些数字的因素。每个数字将是稳定的一套脱颖而出,成为一个独立的要素特征的组合。最后的层中含有尽可能多的神经元neocognitron它是如何应该检测。这一层的一个神经元的活动讲话识别相应的图象的(如下所示)

的

识别在neocognitron(福岛K.,Neocognitron,2007年) i>的

下面的视频提供了neocognitron的可视化表示。

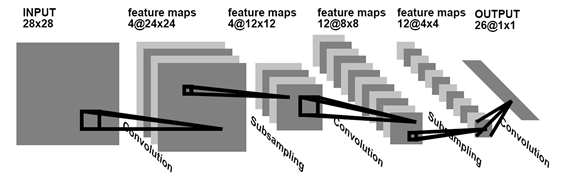

可供选择的学习无师自通 - 本次培训的老师。因此,在数字的例子中,我们不能等待网络本身将提供一个强大的统计表格,并告诉她,她的身影呈现,并需要适当的培训。在本次培训卷积网络中最显著取得的成果晏LeCun(Y. LeCun和Y. Bengio,1995)。他展示了如何使用反向传播学习网络,架构其中,像neocognitron,依稀让人联想到大脑皮质的结构。

网络卷积手写识别(Y. LeCun和Y. Bengio,1995) i>的

在此,我们假设最低初始信息回忆和你可以去的东西更有趣,更令人惊讶的。

续

参考

前面的部分:

第1部分神经元

第2部分因素

阿列克谢Redozubov (2014)

来源: habrahabr.ru/post/214317/

标签

另请参见

思维的逻辑。第2部分因素

思维的逻辑。第6部分投影系统

思维的逻辑。第九部分神经探测器的格局。背投

逻辑思维。第10部分:空间的自组织

思维的逻辑。第11部分:动态神经网络。关联

逻辑思维。第12部分:记忆的痕迹

思维的逻辑。部分16批次演示

逻辑思维。 13.部分联想记忆

思维的逻辑。 15.部分记忆巩固

人工智能的未来:趋势与前景